Macro dinamiche del rischio cyber

Ogni anno, in concomitanza con il ben noto meeting annuale, il World Economic Forum pubblica il Global Risk Report prodotto con la collaborazione di esperti e decision-maker disseminati in tutto il mondo per identificare e analizzare i rischi più rilevanti per la nostra società globalizzata. I rischi di cui si occupa il Global Risk Report riguardano tutti gli aspetti della nostra vita economica, sociale, politica, culturale e tra questi, negli ultimi anni, hanno iniziato a affacciarsi nella classifica e a risalirne la china i rischi che fanno parte di un cluster che possiamo identificare con il nome “rischio cyber”.

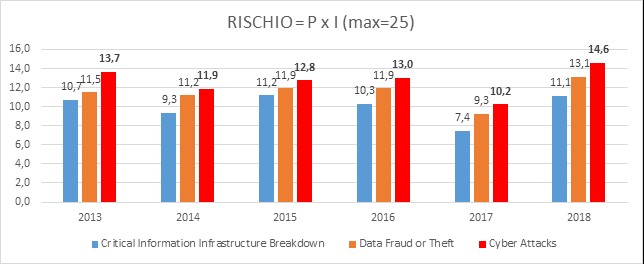

La figura seguente mostra il valore di rischio normalizzato su di una scala 5×5 di probabilità e impatto dei rischi facenti parte del cluster cyber.

Si tratta di valori di rischio elevati che si accentuano in modo particolare nell’ultima rilevazione. Dobbiamo inoltre considerare che:

- nel 2016, Data fraud entra nei top 10 risk all’ 8° posto per probabilità di accadimento, ma è fuori dalla top 10 per impatto percepito;

- nel 2017, Data fraud or theft e Cyberattacks entrano nei top 10 risk al 5°e 6°posto rispettivamente per probabilità di accadimento, ma sono fuori dalla top 10 per impatto percepito;

- Nel 2018 i due rischi, in ordine invertito, scalano al 3°e 4° posto della classifica per probabilità di accadimento, mentre Cyberattacks che entra al 6° posto della top 10 dei rischi per impatto percepito.

Si tratta, quindi, di una crescita costante dell’importanza di questi rischi nel percepito di una serie di personaggi generalmente fuori dallo stretto mondo degli specialisti che si occupano di questa materia.

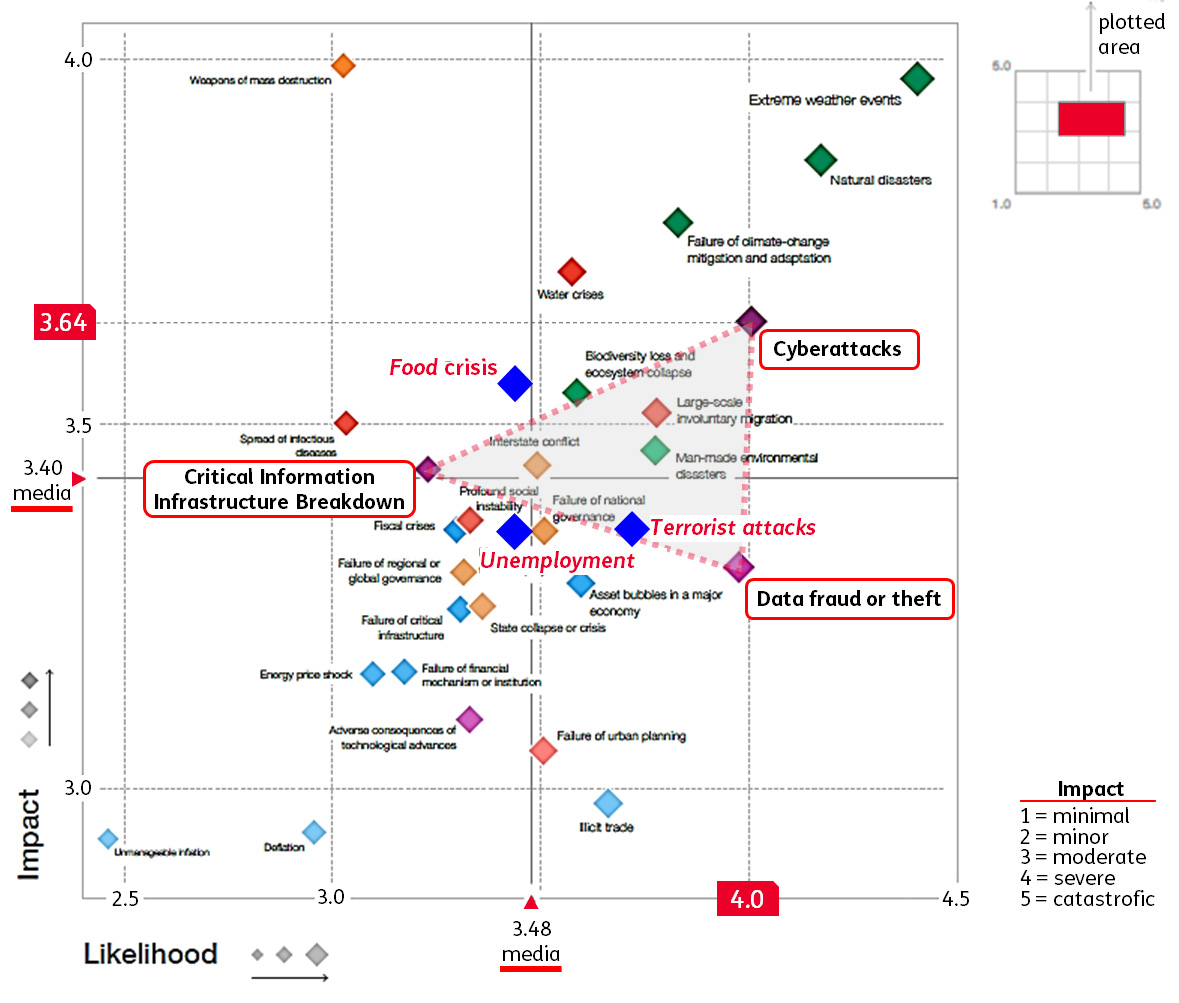

Ora, osservando il Global Risk Landscape 2018, si nota che il cluster dei rischi cyber crea una sorta di triangolo posizionato nel quadrante in alto a destra della mappa. In effetti, la cosa che sorprende è che il percepito del panel di contributori al Global Risk Landscape sia che i cyberattack comportino un rischio (probabilità x impatto) più elevato rispetto ai più tradizionali rischi legati ad attacchi terroristici, crisi alimentari e disoccupazione.

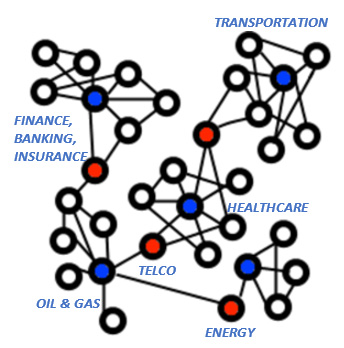

Questo è un punto certamente interessante che trova, secondo me, risposta nel fatto che il rischio cyber è un rischio particolare, dotato di caratteristiche in grado di amplificarne il potenziale negativo. Il rischio Cyber, infatti, è un rischio di sistema.[1] D’altra parte, è del tutto intuitivo osservare che il funzionamento delle infrastrutture critiche è sempre più basato sulle tecnologie digitali, che l’interdipendenza delle “Critical Information Infrastructure” aumenta costantemente e di conseguenza, aumenta il rischio che un danno prodotto in un nodo del sistema si ripercuota sui nodi circostanti con effetti a catena potenzialmente catastrofici. Ovviamente, non si tratta solo di questo, bisogna considerare almeno altri due fattori che contribuiscono a sostenere una valutazione di rischio così elevata: 1) l’anonimia, ovvero, il fatto che è praticamente impossibile attribuire la responsabilità di un cyberattack ad un individuo o gruppi; 2) l’asimmetria, ovvero, il fatto che un attaccante può concentrarsi su di una singola vulnerabilità ed un ambito anche ristretto, mentre chi difende non può esimersi dal considerare tutto il contesto degli asset dell’istituzione/ente/azienda e tutte le vulnerabilità[2], il che aumenta esponenzialmente la complessità da gestire.

A supporto di questa tesi, possiamo osservare che negli ultimi 3 anni si sono verificati almeno tre eventi che presentano tutte le caratteristiche del rischio sistemico, ovvero, di un evento in grado di produrre gravi effetti indiretti di secondo e anche di terzo livello.

Il 21 Ottobre 2016, un attacco DDoS a DYN (provider di servizi DNS negli USA) ha generato per 6 ore seri impatti sulla disponibilità dei servizi dei principali over-the-top statunitensi. La botnet utilizzata per l’attacco era composta da circa 10 milioni di indirizzi IP, per la maggior parte videoregistratori e videocamere “intelligenti”. Nei fatti, si è trattato del primo significativo black out di Internet negli Stati Uniti.

Il 17 Dicembre 2016, a Kiev, un attacco ai sistemi di distribuzione dell’energia elettrica realizzato utilizzando un malware poi denominato “Industroyer” causa un black out che si è protratto per 75 minuti.

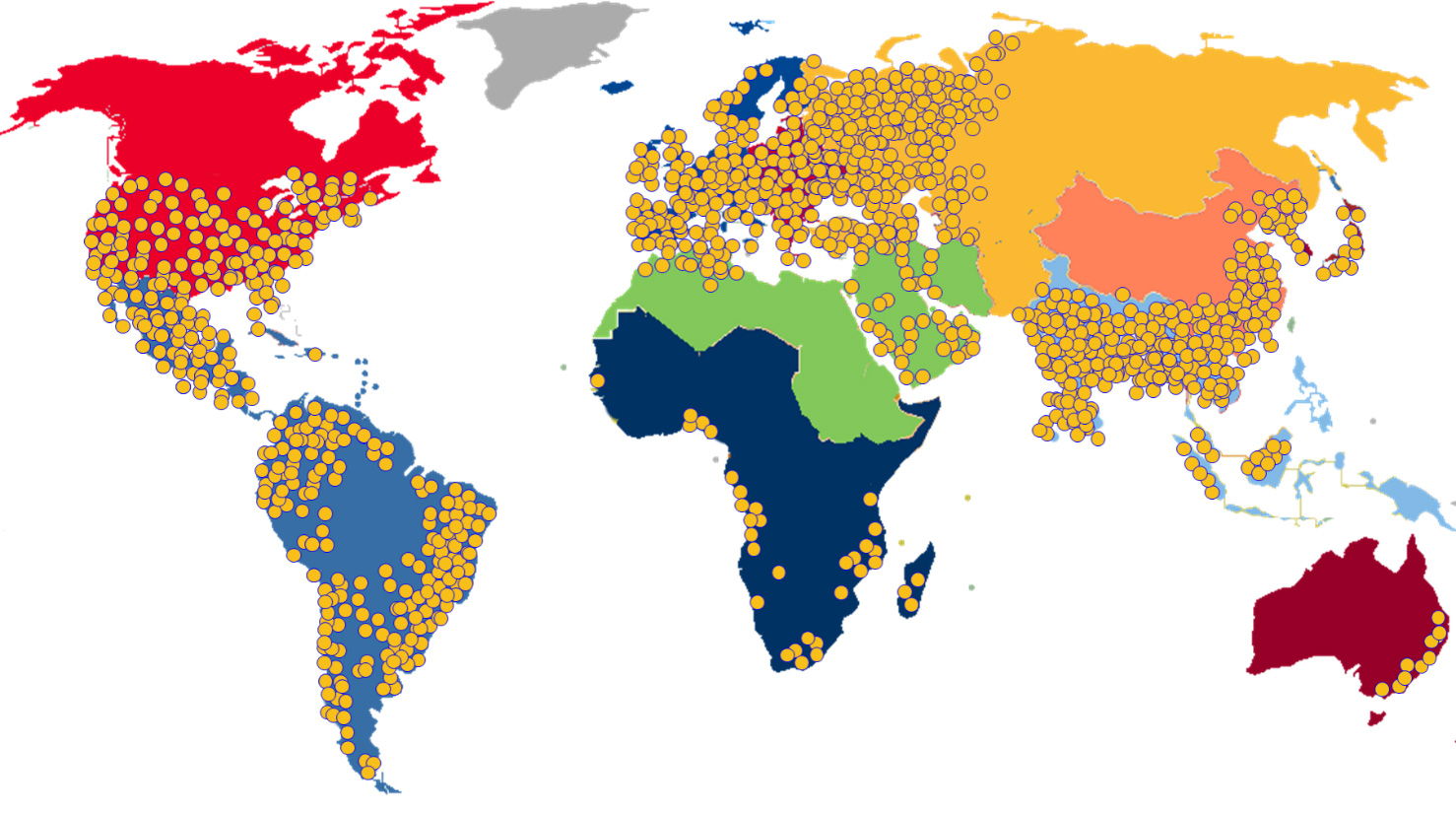

Il 12 maggio 2017, il virus informatico WannaCry ha infettato centinaia di migliaia di sistemi Microsoft Windows in tutto il mondo, mettendo in seria difficoltà più di 105 paesi. Una vera e propria epidemia su vasta scala che ha colpito più di duecentomila computer, paralizzando aziende e organizzazioni, dal Servizio Sanitario Nazionale inglese alla compagnia telefonica spagnola Telco, passando per FedEx, Renault, Deutsche Bahn e il Ministero degli Interni russo. Tra i paesi più colpiti troviamo Spagna, Gb, Usa, Cina, Portogallo, Vietnam, Russia e Ucraina.

Storicamente, il rischio sistemico è stato studiato in relazione al sistema bancario[3] e al mondo della finanza; ora, però, l’incredibile livello di interconnessione raggiunto dal substrato digitale che rende possibile quasi ogni forma di attività umana, si pone esso stesso come elemento sistemico in grado di causare crisi di dimensioni forse non immaginabili e non comparabili con il singolo evento in grado di innescarla.

Energia, comunicazioni e trasporti sono le infrastrutture critiche[4] per eccellenza, in quanto caratterizzate da un alto grado di interdipendenza e – non trattando le prime due beni “immagazzinabili” – sono in grado di provocare effetti istantanei trasmettendo rapidamente a tutti gli altri settori disagi e degrado della qualità della vita[5]. Da questo punto di vista, è chiaro perché il legislatore Europeo si sia a lungo dedicato al tema della resilienza in particolare delle reti di servizi essenziali (Direttiva NIS).

Per comprendere meglio il ruolo del rischio cyber come rischio sistemico è necessario mappare il grado di interconnessione delle singole infrastrutture critiche, il loro grado di vicinanza, il livello di causalità reciproco e l’esposizione al rischio dei singoli punti di interconnessione. Sulla base di questo, poi, bisognerebbe definire delle metriche utili a fissare delle soglie di attenzione. È un tema ancora non sufficientemente presidiato anche se, dal punto di vista regolatorio, recentemente sono stati fatti diversi passi in avanti nel senso di costruire una risposta “di sistema” almeno sul terreno della privacy, della resilienza delle reti e dell’aumento della sensibilità sul tema del cyber Risk.

Insomma, se il rischio cyber è un rischio di sistema e la cyber resilience è un bene pubblico, allora anche la risposta di paesi, istituzioni e imprese deve essere “di sistema”. Anche se GDPR, Direttiva NIS, Regolamento eIDAS e Cybersecurity Act[6], costituiscono un framework di regole che inizia ad assumere una dimensione organica, a livello di implementazione, invece, manca ancora una solida consuetudine a condividere semantiche, metriche, metodi di misurazione e statistiche sul fenomeno cyber, elementi indispensabili se si vuole affrontare questo rischio come rischio di sistema.

Come per molte malattie, il rischio cyber è amplificato, anzi, “si nutre” di altri fattori digitali che sono strettamente correlati tra di loro. Direi che il fattore primigenio può essere fatto risalire alla legge di Moore[7] che fornisce il carburante che ha consentito a tutta l’industria digitale di svilupparsi ad una velocità esponenziale. È, infatti, evidente che la crescita vertiginosa della potenza dei microprocessori e quindi della capacità di calcolo garantita dalla legge di Moore, abbinata all’incredibile livello di miniaturizzazione raggiunto nei processi produttivi delle componenti elettroniche ha permesso l’esplosione dell’era delle reti di telecomunicazioni e dell’informatica che ha aperto all’era di Internet come piattafroma di distribuzione di tutte le innovazioni digitali.

Dal 2017 al 2020, la popolazione globale passerà da 7,7 a 7,8 miliardi di persone crescendo di 100 milioni di unità (+1%), mentre la “popolazione” dei device IOT connessi alla rete passerà da 8,4 miliardi a 20,4 miliardi[8] con un incremento di 12 miliardi di oggetti (+242%) il che, credo, rende chiara la misura dell’enorme velocità a cui viaggia il mondo digitale. La velocità estrema è, quindi, il tratto principale che caratterizza gli ecosistemi digitali e che influisce in modo così significativo sul rischio cyber. Tutto viene consumato in grande fretta e di conseguenza, il ciclo di vita delle tecnologie si riduce drasticamente. Se pensiamo, ad esempio, ad un’industry capital intensive come quella delle tecnologie radiomobili che deve assorbire costi elevati per la concessione delle frequenze e per la stesura delle reti (torri, antenne, accesso radio, core network, etc.), osserviamo che in meno di 40 anni si sono succedute 5 differenti tecnologie: il TACS parte nei primi anni 80, il 2G nel 1991, il 3G dopo 10 anni, il 4G dopo 9 anni e il 5G dopo 8 anni e la velocità di download passa dai 384 kbps del primo 3G, ai 100 Mbps del 4G, ai 10 Gbps del 5G. In questo processo di crescita vorticosa ci sono due date chiave: la disponibilità estesa e a basso costo di capacità di banda sulle reti di telecomunicazioni che è databile all’anno 2000 e la nascita degli OTT che è databile tra 2007 e 2008. Dopo il 2008 abbiamo assistito alla rapida crescita del numero di device costantemente connessi, ad un economia che dipende sempre di più da algoritmi di IA, alla crescita del potere dei social ed al rischio delle fake news, alla crescita dello sfruttamento dei contenuti personali dovuto allo spostamento sempre più avanti del trade-off tra privacy e servizio.

Ma ciò non basta. Le tecnologie digitali stanno cambiando anche le relazioni tra nazioni e blocchi di potere. “… il solo modo di comprendere i cambiamenti geopolitici contemporanei è quello di mettere insieme quello che sta avvenendo nel mondo dell’informatica e ciò che sta avvenendo nel mondo delle telecomunicazioni, con ciò che sta avvenendo in ambito ecologico e ciò che sta avvenendo nella globalizzazione o in ambito demografico. Non c’è altro modo, oggi, per offrire un quadro complessivo della situazione”[9]. La geopolitica di ieri[10] trattava della geografia come elemento fondamentale per la possibilità di movimento degli eserciti e per le necessarie linee di rifornimento, per la possibilità di instaurare traffici commerciali via mare facilmente difendibili in modo semplice e poco costoso. Oggi, la geopolitica nell’era digitale tratta delle reti di telecomunicazione, dei cavi sottomarini, degli hub e dei landing point dove passa il traffico di internet, della manipolabilità degli elettori tramite i social. Si tratta di scenari in grado di spostare il baricentro delle sfere d’influenza e – come è normale che sia – anche di tanto business.

Ora, se guardiamo questo scenario dalla prospettiva del rischio cyber è semplice osservare che i principali effetti del big bang digitale in cui abbiamo vissuto i tempi più recenti sono:

- Incremento della superficie esposta a chi fosse intenzionato a realizzare cyber-attacchi con conseguente crescita a dismisura delle vulnerabilità potenzialmente sfruttabili e di conseguenza il rischio di impatti rilevanti.

- Cicli di vita delle tecnologie più corti e, quindi, tecnologie legacy che devono coesistere con quelle più recenti creando due problemi di natura opposta: sui sistemi più vecchi, ormai obsoleti, non è più conveniente investire ed è quindi molto difficile riuscire a sanare le vulnerabilità presenti; su quelli più recenti c’è un problema di maturità della tecnologia che spesso crea molti problemi di sicurezza.

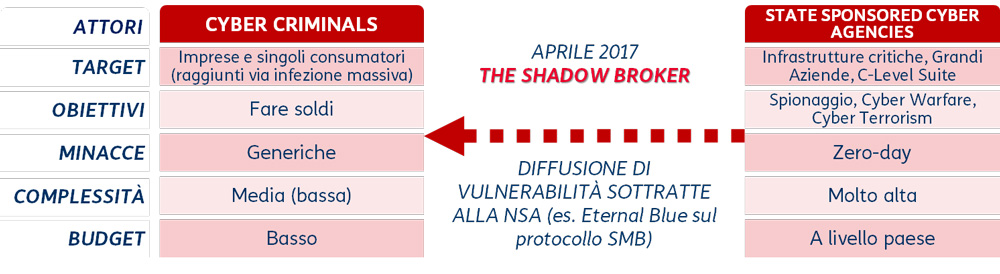

- Incremento delle complessità delle Le realtà che si muovono nel campo delle minacce, sono con qualche approssimazione classficabili in due macro gruppi: cyber criminalità comune e cyber criminalità organizzata. I primi sono interessati solo al ritorno economico delle operazioni che mettono in campo, usano cyber minacce generiche, di media complessità e bassi costi. I secondi, invece, sono spesso sponsorizzati da nazioni, hanno obiettivi più ambiziosi che non sono semplicemente legati al solo ritorno economico, usano minacce esclusive o costruite ad hoc, di complessità elevata e costi molto elevati. Ora, per molto tempo questi due mondi non si sono toccati ma, nel mese di aprile 2017 per una serie di vicissitudini[11], il gruppo hacker “The shadow broker” ha reso disponibili una serie di vulnerabilità prima sconosciute (0-day) sottratte alla NSA[12] tra le quali quella denominata “Eternal Blue” che sfrutta una debolezza del protocollo SMB di Microsoft. Nel successivo mese di Maggio, questo 0-day è stato utilizzato per realizzare la campagna di attacchi Wannacry di cui abbiamo già parlato. È come se un arsenale di armi nucleari fosse stato reso disponibile alla criminalità comune.

La derivata di tutti gli scenari descritti e di tutti i trend illustrati è un considerevole e costante incremento degli incidenti di sicurezza. Ovviamente, potremmo discutere a lungo su che cosa si intende per incidente di sicurezza, su quali sono i casi in cui è opportuno targare un problema come “incidente di sicurezza” e su come tipizzarlo allo scopo di costruire aggregazioni statistiche significative a livello paese. Rimane, però, il fatto che l’aumento degli incidenti di sicurezza è un elemento intuitivo, che tutti siamo disposti a dare per scontato. Ce ne rendiamo conto ancora poco, ma la rivoluzione digitale ci ha portato in dono una situazione che possiamo definire “la tempesta digitale”, uno scenario caratterizzato da attacchi informatici di differente intensità e gravità che si succedono rapidamente e fanno crescere la probabilità che si verifichi un evento catastrofico come un “Big One” o una “tempesta perfetta”, per restare nella metafora.

Diretta conseguenza di quanto detto fino ad ora è che nessuno e a nessun livello (stato, istituzione, ente o impresa) può esimersi dal valutare il rischio cyber in relazione alla propria attività, ambito di azione o business. Sia che si approcci il tema partendo dalla necessità di difesa delle operation o che si parta, invece, dalla protezione della privacy, il punto di arrivo è sempre lo stesso: analizzare la probabilità che un evento avverso crei un danno significativo e, di conseguenza, adottare le contromisure (azioni di mitigazione) opportune. L’analisi del rischio, che è al centro degli ultimi provvedimenti emanati a livello Europeo, ha come obiettivo principale quello di ridurre la superficie esposta ad un livello tollerabile, ovvero, capace di generare solo impatti trascurabili. Per fare ciò è necessario fotografare l’AS IS ed effettuare una gap analysis confrontandosi con le best practice e, se possibile, con i propri peer magari con l’ausilio di uno dei molti strumenti metodologici e Framework che ci aiutano a seguire tutti i passi correttamente e che addirittura ci suggeriscono le contromisure (anche tecniche) da adottare nelle diverse situazioni.

Ora, quali sono i principali trend che emergono dalla rivoluzione digitale che hanno un impatto significativo sul fenomeno cyber?

Il fattore umano

È certamente uno dei rischi principali ed è anche un paradosso. Da una lato la rivoluzione digitale ha in molti modi potenziato le nostre capacità: attraverso i social ci ha offerto la possibilità di intrattenere tantissime relazioni contemporaneamente, di dire sempre la nostra anche su temi che solo due decenni fa sarebbero rimasti al più relegati alla cerchia di amici più ristretta; da un altro lato, invece, ci ha regalato aspetti negativi come la polarizzazione delle opinioni, gli haters, i troll, le fake news, un contesto insomma ottimo per “distruggere” consenso ma per niente in grado di “costruirlo”. In questo mondo che viaggia alla velocità della luce (immaginatevi per un momento a bordo dell’Enterprise del capitano Kirk) questi super individui le cui capacità sono potenziate da Internet e dai social, sorprendentemente, si scoprono estremamente vulnerabili al social engineering/phishing che si conferma essere i canali più di frequente utilizzato in fase di innesco di attacchi anche complessi. L’obiettivo dei cyber criminali è sottrarre credenziali per l’accesso ai sistemi e/o indurre i target a scaricare software malevolo. Si tratta di un fatto cruciale: le credenziali sono la chiave che consente di accedere ai dati che sono la risorsa pregiata della digital economy, l’elemento da proteggere e da valorizzare al tempo stesso, il carburante che fa girare tutto.

Secondo il report 2018 dell’osservatorio Clusit[13], l’incremento degli attacchi compiuti con tecniche di Phishing / Social Engineering è enorme, la sanità è stato il settore più colpito (+102%), seguito dalla GDO (+70%) e, “solo” terzo, dal settore Finance / Banche (+64%).

Bisogna, quindi, proteggere i super individui digitali con rimedi che consistono principalmente nell’effettuare campagne di educazione affiancate a test «dal vivo» che sono fondamentali per misurare la bontà dei comportamenti. È utile, inoltre, adottare in modo ampio un secondo fattore di autenticazione ad esempio tramite una OTP (token a scadenza dopo # secondi) generata tramite un app sul proprio smartphone (es. Google Authenticator e MS Authenticator).

La Supply Chain

Sempre di più le aziende, così come le realtà istituzionali, si configurano come entità aperte; come accade in natura, esse sono al centro di una molteplicità di ecosistemi che le aiutano a condurre i propri processi di business e al contempo ad essere più resilienti ed adattarsi meglio ai cambiamenti del mercato. L’ecosistema dei partner è coinvolto in segmenti sempre più importanti dei processi di business: gestisce i dati dei nostri clienti ed ha credenziali di accesso ai nostri sistemi core; è su questo fronte che si gioca una buona parte della sicurezza del business. In quest’ottica, dunque, si capisce facilmente come sia importante includere l’intera filiera dei fornitori/partner all’interno del processo di ICT Risk Management. Per fare un esempio che può sembrare banale, ma in realtà non lo è affatto, facciamo riferimento ad una filiera particolarmente critica come quella dei device – PC, tablet, smartphone e modem – che sono i possibili punti d’ingresso degli hacker nelle organizzazioni. È indispensabile proteggere questi device in modo adeguato, in primis facendo in modo che il processo di acquisto di questi asset sia rigidamente controllato e strettamente connesso al processo di sicurezza allo scopo di evitare data breach e/o la creazione di gruppi di zombie eventualmente utilizzabili per realizzare attacchi. Continuando con gli esempi, una speciale attenzione va posta nelle filiere manifatturiere dove la componentistica da integrare nel prodotto finale è basata su tecnologia digitale. La stessa attenzione va posta ove ci sia la possibilità di alterare flussi di dati in ingresso ad applicazioni che sfruttano algoritmi di intelligenza artificiale (come ad esempio i sistemi che presiedono al funzionamento dei mercati finanziari) per fare in modo che l’algoritmo di AI prenda delle decisioni sbagliate perché basate su dati non attendibili. È per questi motivi, quindi, che chi in azienda si occupa della gestione della supply chain oltre all’attenzione a ridurre i costi, aumentare le performance, ridurre i rischi operativi, aumentare la flessibilità, si dovrà concentrare anche sulla valutazione e gestione del rischio cyber; visto che il mondo digitale è strettamente interconnesso è indispensabile che tutti gli elementi dell’ecosistema viaggino perfettamente allineati.

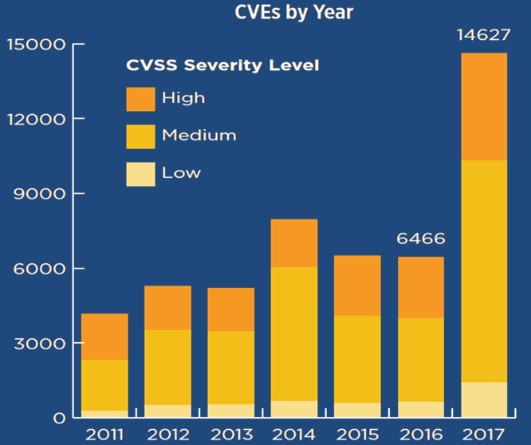

Utilizzo non governato del software Open Source

Tre dei dieci prodotti più vulnerabili sono open source.[14] Semplicemente consultando il “National Vulnerability Database” del NIST si vede che la distribuzione dei CVE[15] per gravità (CVSS)[16] si impenna nel 2017 con un considerevole incremento delle fasce medium e high. Da una ricerca della società BlackDuck[17] emerge che il 96% di un campione di applicazioni analizzato ha componenti open source e il 67% di queste ha vulnerabilità spesso note da anni. Il software open source, quindi, è ovunque e, in generale, è molto vulnerabile; molto spesso, poi, i committenti non sono nemmeno consapevoli di avere così tanto open source nei loro software. Il fatto è che spesso l’introduzione del sw open source risponde a logiche di puro saving, tra l’altro, introducendo un nuovo rischio potenziale legato al licensing che è comunque presente per le distribuzioni ufficiali del software open source. Una buona governance delle tecnologie e in particolare dell’utilizzo del software open source è una componente fondamentale di qualsiasi possibile approccio di sicurezza. È ovvio che non è possibile spostare all’indietro le lancette dell’orologio, così come non è possibile far finta di non vedere gli enormi vantaggi che il lavoro delle community ci può dare; rimane però il fatto che non possiamo pensare di continuare a pagare il prezzo di capex continuamente decrescenti con un incremento costante delle vulnerabilità e quindi del rischio. È un modo di procedere che non ci porterà niente di buono ed è un problema serio.

Complessità, obsolescenza, patching

Il costante aggiornamento degli strati del software di sistema sui quali le applicazioni basano il loro funzionamento, è condizione fondamentale per ridurre le vulnerabilità e, di conseguenza, la superficie esposta ad un potenziale attaccante. L’attività di aggiornamento di una release del software di sistema si chiama patching. Molto spesso, sia per l’obsolescenza dell’hw che non supporta le nuove release del software di sistema che per l’obsolescenza dell’applicazione che hanno bisogno di interventi spesso «importanti» per funzionare con le nuove release, l’attività di patching non può essere eseguita. Si generano, quindi, una serie di vincoli che indeboliscono considerevolmente, il sistema nel suo complesso. Se poi, come capita spesso, l’obsolescenza è collegata ad un’elevata complessità del landscape infrastrutturale: molti layer di rete, molti data center, moltissimi server, allora la soluzione del problema diventa esponenzialmente più complessa se non strutturalmente non possibile.

Come si può essere sicuri che le patch vengano applicata prima che la compliance lo richieda o prima che qualcuno tenti di sfruttarle? Un semplice calcolo[18][19] ci porta a scoprire che per essere confidenti al 95% di ciò è necessario che il tempo medio di applicazione delle patch sia 3 volte più veloce rispetto a quanto richiesto. Ad esempio, se il requisito di compliance dice che dovete applicare le patch ogni 12 mesi, allora per essere confidenti al 95% di raggiungere l’obiettivo dovete tarare il vostro processo in modo che sia in grado di concludere un giro completo di patch in media in 4 mesi. Se poi il team che si dedica a questa attività è impegnato al 70% (ipotesi ragionevole), allora la migliore performance del processo di patching deve essere 10 volte inferiore al tempo richiesto dalla compliance, nel caso dell’esempio precedente 1,2 mesi. Se ciò è vero, nel 95% dei casi il processo di patching si concluderà, come richiesto, entro i 12 mesi. Ora, credo sia facile comprendere che se la base installata è composta da qualche decina di migliaia di server, allora il problema del patching è strutturalmente non risolvibile. E quindi, quali soluzioni è possibile ipotizzare? Come prima cosa bisogna darsi degli obiettivi basati sulla priorità calcolata in base al rischio (sensibilità dei dati, esposizione verso internet etc.). Poi, bisogna eseguire il patching ove non ci siano problemi di obsolescenza o di costo/opportunità. Infine, dove non sia possibile o non conveniente applicare correttamente il patching, è possibile scegliere una strategia di virtual patching creando tramite un agent specializzato un ambiente protetto in cui l’applicazione / sistema può funzionare al sicuro dalle vulnerabilità esposte dallo stack software sottostante.

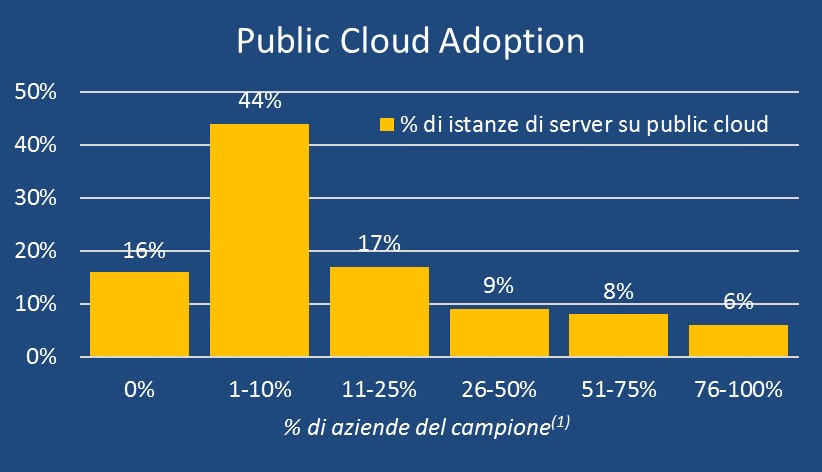

Transizione al cloud pubblico non governata

Flessibilità, Scalabilità, TCO più basso rispetto alle architetture on premise fanno si che l’84% delle aziende del campione[20] migrerà almeno il 10% delle istanze di server sul public cloud nei prossimi 3 anni o comunque lo raddoppierà. Skill shortage e mancanza di capacità di gestione dello shared responsibility model costituiscono i problemi principali. Cifratura dei tenant su public cloud (con chiavi in esclusivo possesso del cliente) e riconfigurazione dei sistemi IAM costituiscono i controlli di sicurezza da indirizzare in via prioritaria. Il rischio più rilevante, però, è una governance debole del processo di transizione al cloud pubblico.

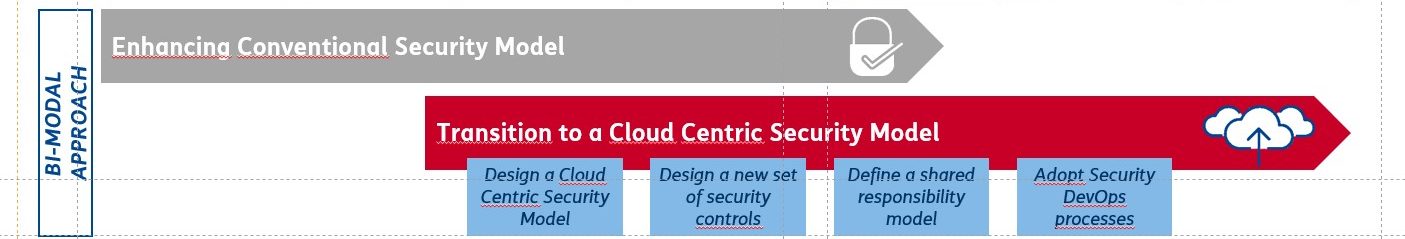

Specialmente nei casi in cui l’obsolescenza e la complessità infrastrutturale costituiscono un ostacolo insormontabile alla realizzazione dei controlli di sicurezza di base (vedi argomento precedente), l’adozione del cloud pubblico in modo ragionato e governato è una delle possibilità da considerare con attenzione, soprattutto riguardo ai controlli di sicurezza da attivare e alla condivisione delle responsabilità sul tema con il/i cloud service provider. È evidente che la migrazione verso il cloud pubblico di un numero di workload rilevanti è un processo che richiede tempo soprattutto per la definizione di rigorose matrici di compatibilità che ci devono garantire di poter sfruttare tutti i vantaggi del cloud eliminando il più possibile le vecchie legacy. Durante il periodo di transizione, quindi, chi si occupa di sicurezza dovrà continuare a mantenere e sviluppare l’infrastruttura di sicurezza convenzionale e al contempo preparare la transizione ad un modello di sicurezza cloud centrico. Un approccio bi-modale, quindi, che garantisca la coesistenza del vecchio con il nuovo per il periodo di tempo necessario.

È evidente, però, che il principale razionale del passaggio al cloud non è quello dell’efficienza se pur in ottica security; il tema principale riguarda l’adozione di nuove piattaforme e metodologie di sviluppo (DevOps) in grado di accorciare drasticamente i tempi di delivery garantiti dall’approccio tradizionale (waterfall) al prezzo di una profonda ridefinizione di strumenti, processi e ruoli che pone a chi si occupa di security la sfida di disegnare controlli di sicurezza che siano efficaci anche in questo nuovo scenario.

Conclusioni

Insomma, il contesto è complesso e in molti ambiti ci ritroviamo senza difese. Ci dobbiamo preparare al fatto che una fetta consistente del rischio cyber non possa essere mitigato, ma vada gestito con altre strategie (accettare, eliminare, trasferire). Se l’opzione di mitigazione diventata più difficile da attuare, anche il concetto di tolleranza al rischio va ridefinito. Potremmo essere obbligati a coesistere con un elevato livello di rischio anche se la nostra tolleranza al rischio è relativamente bassa e dunque per obbligo e non per scelta di business. È necessario che i Board siano consapevoli di questa situazione allo scopo di assumere le decisioni più opportune in relazione ai segmenti di business prioritari.

Sappiamo bene che il fatto di essere oggetto di un cyber attack non è questione di “se” ma solo di “quando”. Sappiamo anche che la “sicurezza totale” non è una categoria realizzabile e che i nostri avversari sono sconosciuti e godono di molti vantaggi strategici. Da soli ci possiamo solo muovere alla ceca con poca probabilità di successo. Assieme, però, possiamo recuperare molti punti di svantaggio ed arrivare ad avere la meglio sui nostri avversari.

Quello che serve, quindi, è una solida roadmap europea che sia parte di una “call to action” globale[21] rivolta ad istituzioni, imprese e industria specializzata per un impegno ad accettare la sfida del cyber risk (e vincerla). Non è certamente una sfida semplice da vincere ma, prendendo spunto dalle parole del Presidente JFK[22], una comunità accetta le sfide che ha di fronte proprio perché non sono semplici, perché ci danno l’occasione di mettere a frutto il meglio delle nostre capacità e del nostro impegno.

Note

[1] Il rischio sistemico è il rischio di “guasti in un intero sistema”, contrapposto al rischio di “guasti di singole parti e componenti”. I rischi sistemici sono caratterizzati da: a) eventi avversi che si combinano indirettamente per produrre grandi fallimenti; b) condivisione del rischio o contagio, poiché una evento avverso innesca una catena di altre “isteresi”, ovvero, di sistemi che non sono in grado di recuperare l’equilibrio dopo uno shock.

- Kaufman, G. G. e K. E. Scott. 2003. “Che cos’è il rischio sistemico e i regolatori di banca ritarda o contribuisce a farlo?” Independent Review 7 (3): 371-391. Vedi citazione a pag. 37.

- Goldin, I. e M. Mariathasan. The Butterfly Defect: come la globalizzazione crea rischi sistemici e cosa fare al riguardo. Princeton University Press, 2014.

[2] https://www.ictsecuritymagazine.com/articoli/la-cybersecurity-vista-dalla-prospettiva-di-un-telco-operator/

[3] Il rischio sistemico misura la probabilità che una situazione di tensione di una singola banca possa innescare instabilità nell’intero sistema finanziario (e viceversa); l’importanza sistemica fa riferimento all’impatto sul sistema finanziario del possibile fallimento di un intermediario bancario. Banca D’Italia “Working Paper N. 1153 – Un’analisi delle misure di rischio sistemico e di importanza sistemica durante la crisi finanziaria globale”.

[4] Direttiva Europea 104/08/CE: “Infrastruttura Critica è un elemento, un sistema o parte di questo, ubicato negli stati membri ed essenziale al mantenimento delle funzioni vitali della società, della salute, della sicurezza e del benessere economico e sociale dei cittadini, il cui danneggiamento o la cui distruzione avrebbe un impatto significativo.

[5] Aldo Mariani e Luisa Franchina: “Infrastrutture Critiche: interdipendenze e analisi degli effetti domino”

[6] In corso di emanazione.

[7] In elettronica e informatica è indicato come prima legge di Moore il seguente enunciato «La complessità di un microcircuito, misurata ad esempio tramite il numero di transistori per chip, raddoppia ogni 18 mesi (e quadruplica quindi ogni 3 anni)». https://it.wikipedia.org/wiki/Legge_di_Moore

[8] https://www.gartner.com/newsroom/id/3598919

[9] “Grazie per essere arrivato tardi – un ottimista nell’epoca delle accelerazioni”, Thomas L. Friedman – Mondadori, aprile 2017.

[10] “Le 10 mappe che spiegano il mondo”, Tim Marshall – Garzanti, giugno 2017.

[11] https://en.wikipedia.org/wiki/The_Shadow_Brokers

[12] https://it.wikipedia.org/wiki/National_Security_Agency

[13] https://clusit.it/rapporto-clusit/

[14] Skybox Security Vulnerability & Threat – Trend Report 2018

[15] Common Vulnerability & Exposures – https://nvd.nist.gov/vuln-metrics/cvss

[16] Common Vulnerabilities Scoring System – https://cve.mitre.org/

[17] BlackDuck – “2017 open source security & risk analysis”

[18] Thanks to Don TurnBlade, ISACA

Tr: the required time for a patch to be applied

P: the confidence that a patch will be supplied

Tc: Average time taken for patches to be applied: actual processing plus time waiting for a turn to be patched.

P = 1 – exp(-Tr/Tc); Solving for Tc: Tc = – Tr / ln(1 – P) à Suppose, P = 0.95 or 95% confident, then Tc = Tr / 2.996

U: Utilization or average staff work loading à Suppose U = 70%

Te: Rate of Best speed patching.

Tc = Te / (1-U); Solving for Te: Te = Tc * (1 – U) ; U = 0.7, Tc = Tr / 2.996 à Te = Tr * (1 – 0.7) / 2.996 = Tr / 9.986

[19] “How to measure anything in cybersecurity risk” – Douglas W. Hubbard & Richard Seiersen – Wiley 2016

[20] McKinsey 2018. “Making a secure transition to the public cloud”.

[21] Gus Hunt, Accenture – https://www.key4biz.it/cybertech-2018-gus-hunt-accenture-contro-il-cybercrime-serve-uno-sforzo-comune/232842/

[22] Discorso alla Rice University sull’impegno spaziale della nazione. Presidente John F. Kennedy Houston, Texas – 12 settembre 1962. “Abbiamo deciso di andare sulla luna in questo decennio e di impegnarci anche in altre imprese, non perché sono semplici, ma perché sono ardite, perché questo obiettivo ci permetterà di organizzare e di mettere alla prova il meglio delle nostre energie e delle nostre capacità, perché accettiamo di buon grado questa sfida, non abbiamo intenzione di rimandarla e siamo determinati a vincerla, insieme a tutte le altre.”

Articolo a cura di Marcello Fausti

Il Dott. Marcello Fausti è attualmente responsabile della CyberSecurity del Gruppo Italiaonline.

Nei 10 anni precedenti, è stato responsabile della IT Security di TIM con responsabilità della protezione delle infrastrutture critiche; dello sviluppo e gestione dei sistemi a supporto dell’Autorità Giudiziaria; della gestione del Security Operation Center, della gestione del processo di ICT Risk Management e dello sviluppo delle contromisure di sicurezza per la gestione operativa dei piani di sicurezza. È stato, inoltre, responsabile del Security Lab di TIM. In precedenza ha lavorato nel gruppo Olivetti come direttore marketing e business development di una società di system integration attiva sul mercato dei large account e come marketing manager della divisione PA della capogruppo.

È certificato CISM, PMP, COBIT, ITIL, ISO20000.