Deepfake vocali: il caso Crosetto svela la nuova frontiera del cyber-crimine in Italia

I deepfake vocali rappresentano oggi una delle minacce più insidiose nel panorama della sicurezza informatica italiana ed europea. Il caso che ha coinvolto il Ministro della Difesa Guido Crosetto nel febbraio 2025 non è stato soltanto un episodio di cronaca clamoroso: è stato un campanello d’allarme che ha risuonato nelle sale riunioni di ogni grande azienda e nei gabinetti di crisi delle istituzioni.

Per la prima volta in Italia, sofisticate tecnologie di clonazione vocale basate sull’intelligenza artificiale sono state impiegate con successo per truffare imprenditori di primissimo piano, sfruttando l’identità di una delle più alte cariche dello Stato. Un milione di euro sottratto con una semplice telefonata. Nessun malware, nessuna vulnerabilità tecnica: solo una voce artificiale così convincente da superare ogni barriera psicologica.

Questo articolo analizza in profondità l’anatomia dell’attacco, le sue implicazioni per la sicurezza nazionale, le lezioni operative per CISO e security architect, e le strategie di difesa che ogni organizzazione dovrebbe implementare prima che sia troppo tardi.

Cronaca di un attacco sofisticato

Lo schema operativo

La vicenda ha avuto inizio martedì 4 febbraio 2025, quando lo stesso Ministro Crosetto ha ricevuto una chiamata da un amico imprenditore che gli chiedeva spiegazioni su un presunto contatto della sua segreteria. L’assurdità della richiesta – ottenere un numero di cellulare che il Ministro già possedeva – ha rappresentato il primo indizio di un’operazione criminale in corso.

Nelle ore successive, lo schema si è rivelato in tutta la sua complessità. I truffatori avevano costruito un’infrastruttura di attacco multilivello:

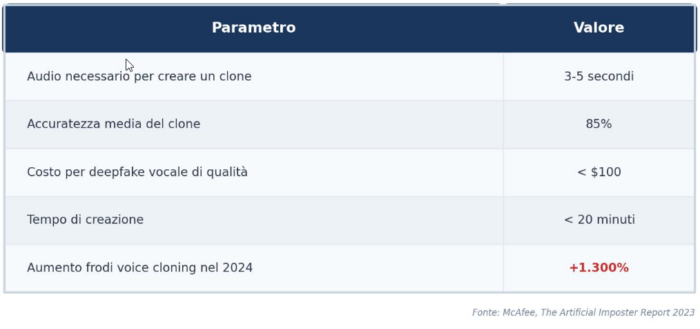

Fase 1 – Ricognizione: raccolta di campioni vocali del Ministro da interviste pubbliche, discorsi istituzionali e apparizioni mediatiche. Secondo il report The Artificial Imposter di McAfee, bastano tre secondi di audio per creare un clone vocale con l’85% di accuratezza.

Fase 2 – Pretexting: contatto iniziale attraverso presunti membri dello staff ministeriale, utilizzando numeri telefonici con prefisso romano e caller ID spoofing per simulare chiamate istituzionali.

Fase 3 – Engagement: conversazione diretta con la voce clonata del Ministro, completa dell’inflessione e del timbro caratteristici. Le vittime hanno riferito di aver riconosciuto immediatamente “la voce di Crosetto”.

Fase 4 – Manipolazione emotiva: la richiesta di fondi era legata alla liberazione di giornalisti italiani rapiti in Medio Oriente, con esplicito riferimento al caso Cecilia Sala – ancora fresco nella memoria collettiva dopo la sua detenzione in Iran.

Fase 5 – Estrazione: bonifici verso conti a Hong Kong, con la promessa di un successivo rimborso da parte della Banca d’Italia.

Le vittime eccellenti

L’elenco degli imprenditori contattati si legge come un who’s who dell’industria italiana: Massimo Moratti (ex presidente dell’Inter), Giorgio Armani, Marco Tronchetti Provera, Diego Della Valle, Patrizio Bertelli (Prada), le famiglie Caltagirone, Del Vecchio e Beretta. Almeno uno di loro ha effettuato un bonifico di circa un milione di euro prima di rendersi conto dell’inganno.

La scelta delle vittime non era casuale. Il targeting selettivo ha privilegiato soggetti con alta capacità economica, relazioni istituzionali consolidate e, soprattutto, una propensione psicologica a rispondere positivamente a richieste provenienti dalle più alte sfere dello Stato.

Il precedente Ferrari: l’intelligenza umana batte l’intelligenza artificiale

Un case study di resilienza

Sei mesi prima del caso Crosetto, nel luglio 2024, un tentativo analogo aveva preso di mira la Ferrari. Un dirigente della casa di Maranello aveva ricevuto messaggi WhatsApp apparentemente provenienti dall’amministratore delegato Benedetto Vigna, seguiti da una telefonata con una voce sorprendentemente fedele all’originale, completa dell’accento lucano caratteristico del CEO.

La narrazione costruita dai truffatori era raffinata: un’acquisizione riservata in corso, necessità di massima discrezione per questioni legate alla Cina, documenti di non divulgazione da firmare. Tutti elementi plausibili nel contesto di una multinazionale quotata.

Eppure, qualcosa non tornava. Il dirigente ha notato lievi toni metallici nella voce – quello che gli esperti chiamano artifacts della sintesi vocale – e ha deciso di applicare il più antico protocollo di autenticazione: una domanda personale.

“Scusa Benedetto, ma devo essere certo che sia tu. Qual è il libro che mi hai consigliato pochi giorni fa?”

La risposta corretta era Il Decalogo della Complessità di Alberto Felice De Toni. Il truffatore, ovviamente, non poteva saperlo. La chiamata si è interrotta istantaneamente.

Le lezioni per i professionisti della sicurezza

Il caso Ferrari, riportato da Bloomberg, offre insight operativi cruciali:

- La tecnologia non è ancora perfetta: nonostante i progressi impressionanti, i deepfake vocali presentano ancora artefatti rilevabili da un ascoltatore attento. Suoni metallici, pause innaturali, breathing patterns irregolari.

- L’out-of-band verification funziona: verificare l’identità attraverso canali alternativi o informazioni condivise rimane la difesa più efficace.

- La consapevolezza è il primo firewall: il dirigente Ferrari era chiaramente formato sui rischi del social engineering avanzato. La sua reazione è stata istintiva ma informata.

- Lo scetticismo sano non è paranoia: mettere in discussione anche comunicazioni apparentemente legittime non è mancanza di fiducia, è igiene operativa.

Il contesto tecnologico: la democratizzazione del voice cloning

Quanto è facile clonare una voce?

Le barriere all’ingresso per il voice cloning sono crollate drammaticamente. Secondo lo studio McAfee del 2023, un adulto su quattro ha già subito o conosce qualcuno che ha subito una truffa basata su clonazione vocale. I dati sono eloquenti:

La fonte del campione vocale può essere un messaggio WhatsApp, un video sui social media, un’intervista su YouTube, un podcast aziendale o persino un webinar corporate. Nessuno è immune dalla raccolta di dati biometrici vocali in un’epoca di comunicazione digitale pervasiva.

L’ecosistema degli strumenti

Mentre OpenAI ha limitato l’accesso pubblico a Voice Engine proprio per prevenire abusi, decine di alternative sono facilmente accessibili. Piattaforme come ElevenLabs, Resemble AI e numerosi strumenti open source consentono la creazione di cloni vocali con competenze tecniche minime. Le ricerche per “free voice cloning software” sono aumentate del 120% tra il 2023 e il 2024.

Il crimine organizzato ha rapidamente industrializzato queste capacità. Gruppi come UNC6040 (Europa dell’Est), BlackBasta (Russia), The Com (network globale) e SilverPhantom (America Latina) hanno integrato i deepfake vocali nei loro arsenali operativi.

Impatto economico: i numeri della minaccia

Statistiche globali

Le perdite finanziarie attribuibili a frodi deepfake-enabled hanno superato i 200 milioni di dollari nel solo primo trimestre 2025. Alcuni casi emblematici:

Arup (Hong Kong, febbraio 2024): 25 milioni di dollari sottratti attraverso una videoconferenza deepfake con CFO e dirigenti sintetici (approfondimento). Un singolo dipendente ha autorizzato 15 trasferimenti consecutivi.

UK Energy Firm (2019): 220.000 euro (243.000 dollari) persi dopo una chiamata con la voce clonata del CEO tedesco. Il caso pioneristico che ha anticipato l’ondata attuale.

Settore retail: alcuni grandi retailer riportano oltre 1.000 chiamate truffa AI-generated al giorno.

Proiezioni future

Secondo il report del Deloitte Center for Financial Services, le perdite globali da frodi IA-enabled passeranno da 12,3 miliardi di dollari nel 2023 a 40 miliardi entro il 2027, con un CAGR del 32%. Il Pindrop Voice Intelligence & Security Report 2025 evidenzia un incremento del +1.300% dei deepfake vocali nel corso del 2024 (da una media di un tentativo al mese a sette al giorno), con una proiezione di ulteriore crescita del +162% nel 2025.

Secondo il survey The Deepfake Trends 2024 di Regula, il 49% delle aziende intervistate ha già subito tentativi di frode attraverso deepfake audio o video. Il 70% degli adulti ammette di non essere in grado di distinguere una voce clonata da quella autentica.

Implicazioni per la sicurezza nazionale

Oltre la truffa finanziaria

Il caso Crosetto ha implicazioni che trascendono il danno economico immediato. Il fatto che sia stato preso di mira proprio il Ministro della Difesa solleva interrogativi inquietanti:

Scenario 1 – Falsi ordini militari: se un deepfake vocale può ingannare imprenditori esperti, cosa accadrebbe se un generale ricevesse un ordine falso attraverso una voce sintetica credibile? Gli errori strategici potrebbero avere conseguenze disastrose.

Scenario 2 – Crisi diplomatiche fabbricate: un deepfake video in cui un ministro insulta un capo di Stato straniero potrebbe precipitare relazioni internazionali prima che qualsiasi smentita possa essere diffusa.

Scenario 3 – Manipolazione dei mercati: un annuncio falso attribuito a figure istituzionali potrebbe muovere i mercati finanziari prima che la verifica sia possibile. Il settore crypto ha già registrato un aumento del 654% di incidenti deepfake nel 2024.

Scenario 4 – Destabilizzazione sociale: campagne di disinformazione orchestrate da attori statali ostili potrebbero utilizzare deepfake di figure pubbliche per seminare panico, influenzare elezioni o minare la fiducia nelle istituzioni.

La risposta istituzionale italiana

Il Ministro Crosetto, poche settimane prima della truffa, durante l’audizione alla Camera del 23 gennaio 2025, aveva presentato un Piano per dotare l’Italia di un contingente militare specializzato nella difesa del cyberspazio. La coincidenza temporale ha conferito ulteriore urgenza al dibattito.

Il Sottosegretario alla Difesa Matteo Perego di Cremnago ha sottolineato come la creazione di un’arma cyber con personale civile e militare, insieme a un quadro normativo che consenta di identificare, mitigare e contrastare le minacce cyber, rappresenti una scelta non più rinviabile.

Il quadro normativo: tra AI Act e legge italiana

La Legge 132/2025 sull’Intelligenza Artificiale

L’Italia ha risposto alla minaccia deepfake con un intervento normativo significativo. La Legge n. 132/2025, entrata in vigore il 10 ottobre 2025, introduce:

Nuovo reato di deepfake (art. 612-quater c.p.): l’illecita diffusione di contenuti generati o alterati tramite sistemi di intelligenza artificiale è punita con la reclusione da uno a cinque anni.

Aggravante IA trasversale (art. 61 c.p., n. 11-decies): l’impiego di sistemi di intelligenza artificiale costituisce circostanza aggravante per numerose fattispecie penali preesistenti, quando gli stessi abbiano costituito mezzo insidioso o ostacolato la difesa.

Obblighi di trasparenza: i provider di sistemi IA generativi devono garantire che i contenuti sintetici siano chiaramente identificabili.

Governance duale: AgID e ACN (Agenzia per la Cybersicurezza Nazionale) sono designate come autorità competenti rispettivamente per innovazione e cybersicurezza.

L’AI Act europeo

A livello comunitario, l’AI Act (Regolamento UE 2024/1689) definisce i deepfake all’articolo 3 e impone obblighi di marcatura per i contenuti sintetici. Tuttavia, l’enforcement rimane frammentato e la tecnologia evolve più rapidamente delle norme.

La Direttiva NIS2

La Direttiva NIS2, recepita in Italia con il D.Lgs. 138/2024, amplia significativamente il perimetro dei soggetti obbligati ad adottare misure di cybersicurezza stringenti. Le scadenze stabilite dall’ACN sono serrate:

- Gennaio 2026: obbligo di notifica incidenti significativi per i soggetti essenziali e importanti.

- Ottobre 2026: piena implementazione delle misure di sicurezza previste.

Le sanzioni possono raggiungere i 10 milioni di euro o il 2% del fatturato mondiale per i soggetti essenziali.

Strategie di difesa: un framework operativo

Per le organizzazioni

-

Protocolli di verifica multicanale

Implementare procedure che richiedano conferma attraverso canali alternativi per qualsiasi richiesta finanziaria significativa:

- Callback su numeri pre-verificati;

- Conferma via e-mail crittografata;

- Validazione attraverso codici condivisi offline;

- Autorizzazione multipersona per transazioni oltre soglie definite.

-

Formazione continua sulla security awareness

I programmi formativi devono evolversi per includere:

- Riconoscimento dei segnali di deepfake (artefatti audio, incongruenze comportamentali);

- Simulazioni di attacchi vishing avanzati;

- Aggiornamenti periodici sulle nuove tecniche di attacco;

- Esercitazioni pratiche con feedback immediato.

-

Implementazione tecnica

- Soluzioni di AI-powered fraud detection (es. Pindrop, Hiya AI Phone);

- Sistemi di autenticazione biometrica multifattoriale;

- Analisi comportamentale delle comunicazioni;

- Registrazione e analisi forense delle chiamate sensibili.

-

Policy e governance

- Definizione chiara delle autorità di approvazione finanziaria;

- Segregazione dei ruoli nei processi di pagamento;

- Audit trail completi per tutte le transazioni;

- Incident response plan specifico per attacchi deepfake.

Per i singoli professionisti

- Mai agire d’impulso: le richieste urgenti che bypassano le procedure standard sono red flag;

- Verificare sempre: una telefonata di conferma su un numero noto richiede 30 secondi;

- Limitare l’esposizione vocale: ridurre i campioni audio pubblicamente disponibili;

- Utilizzare safe word: concordare parole d’ordine o domande personali con colleghi e familiari;

- Segnalare i tentativi: ogni tentativo fallito fornisce intelligence utile.

Il futuro della minaccia: cosa aspettarsi

Trend emergenti

La traiettoria tecnologica è chiara. Gli esperti prevedono:

Sintesi in tempo reale: deepfake video in tempo reale indistinguibili durante videochiamate live. La tecnologia si sta avvicinando rapidamente a questa soglia.

Emotional AI: sistemi che non replicano solo voce e aspetto, ma anche risposte emotive e tratti di personalità, rendendo l’inganno ancora più convincente.

Automated scale: piattaforme IA che conducono simultaneamente migliaia di conversazioni deepfake personalizzate, basate su dati raccolti dai social media.

Cross-modal attacks: combinazione di audio, video e testo sintetici in attacchi multivettore coordinati.

La risposta difensiva

L’industria della sicurezza sta rispondendo con:

- Content provenance: standard come C2PA (Coalition for Content Provenance and Authenticity) per la firma crittografica dei media autentici;

- Deepfake detection AI: strumenti forensi come Deepfake-o-Meter che analizzano multiple modalità;

- Infrastructure-level protection: soluzioni integrate a livello di carrier telefonico per identificare caller ID falsificati;

- Regulatory enforcement: crescente pressione per responsabilizzare le piattaforme che distribuiscono strumenti di clonazione.

Deepfake vocali: la consapevolezza come prima linea di difesa

Il caso Crosetto rappresenta uno spartiacque nella storia della cybersecurity italiana. Ha dimostrato che nessuno – né il singolo cittadino né il grande imprenditore – è immune da attacchi che combinano sofisticazione tecnologica e manipolazione psicologica.

I deepfake vocali non sono più una minaccia futuristica: sono una realtà operativa che ogni organizzazione deve affrontare oggi. Il costo dell’inazione non si misura solo in termini finanziari, ma anche in reputazione, fiducia e, potenzialmente, sicurezza nazionale.

La difesa efficace richiede un approccio multilivello che integri tecnologia, processi e formazione. Ma soprattutto, richiede un cambio di mentalità: in un’era in cui qualsiasi voce può essere replicata artificialmente, la verifica non è più opzionale – è l’unica scelta responsabile.

Come ha dimostrato il dirigente Ferrari, a volte la difesa più efficace contro l’intelligenza artificiale rimane l’intelligenza umana: la capacità di dubitare, verificare e porre la domanda giusta al momento giusto.

Il caso Crosetto, con tutte le sue implicazioni, ci ricorda che nella cybersecurity del XXI secolo la prima linea di difesa non è un firewall, ma la consapevolezza. E questa, a differenza di una voce, non può essere clonata.