Risk assessment: la metamorfosi del rischio digitale nella sicurezza informatica

Nel panorama fluido della sicurezza digitale contemporanea, la valutazione del rischio emerge come architrave metodologica di qualsiasi strategia difensiva efficace. Questo processo, lungi dall’essere un mero esercizio tecnico, rappresenta l’intersezione tra analisi quantitativa, interpretazione qualitativa e capacità predittiva in un ecosistema dove la minaccia è perennemente mutevole.

L’ontologia del rischio digitale

Il rischio informatico si configura come una funzione complessa che correla la probabilità di un evento avverso con l’impatto potenziale che esso potrebbe generare. Questa dualità concettuale – probabilità e impatto – costituisce il nucleo epistemologico su cui si fonda ogni assessment strutturato. Non si tratta di una semplice equazione matematica, ma di un processo ermeneutico che richiede tanto rigore scientifico quanto intuizione strategica.

Le organizzazioni affrontano oggi un’estensione del perimetro di rischio che travalica i confini tradizionali dell’infrastruttura IT, abbracciando dimensioni come il cloud computing, l’Internet of Things e la crescente interrelazione con terze parti. Questo ampliamento della superficie d’attacco richiede un approccio olistico alla valutazione, capace di trascendere la frammentazione dipartimentale tipica delle strutture organizzative convenzionali.

Metodologie e framework di riferimento

L’ecosistema metodologico per la valutazione del rischio informatico presenta una pluralità di approcci, ciascuno con specifiche peculiarità epistemologiche: Il NIST Risk Management Framework rappresenta un paradigma procedurale che integra la gestione del rischio nel ciclo di vita dei sistemi informativi, articolandosi in sei fasi interconnesse: categorizzazione, selezione, implementazione, valutazione, autorizzazione e monitoraggio. La sua architettura concettuale favorisce l’integrazione con altri standard regolatori, costituendo un meta-modello di riferimento nella governance federale statunitense.

ISO/IEC 27005, incardinato nella famiglia di standard 27000, propone invece un approccio ciclico che enfatizza la continuità del processo valutativo, sottolineando l’importanza dell’iterazione come risposta alla natura dinamica delle minacce digitali. La sua adozione internazionale lo rende un linguaggio comune nella comunicazione inter-organizzativa del rischio.

FAIR (Factor Analysis of Information Risk) introduce una dimensione quantitativa più sofisticata, modellizzando il rischio attraverso distribuzioni probabilistiche che permettono una rappresentazione più granulare dell’incertezza intrinseca al dominio. Questa monetizzazione del rischio facilita il dialogo con i decisori esecutivi, trasformando l’assessment da esercizio tecnico a strumento di governance strategica.

La dialettica tra approcci quantitativi e qualitativi

La tensione metodologica tra quantificazione e qualificazione del rischio rappresenta un asse dialettico fondamentale nella disciplina. Gli approcci quantitativi, con la loro promessa di oggettività algoritmica, offrono una sintassi formale per descrivere la complessità del rischio, ma possono incorrere nella fallacia della precisione illusoria quando applicati a domini caratterizzati da incertezza profonda.

D’altro canto, le metodologie qualitative, basate su scale ordinali e giudizi esperti, garantiscono flessibilità interpretativa e adattabilità contestuale, ma rischiano di introdurre distorsioni cognitive e inconsistenze valutative. La frontiera più promettente risiede nell’integrazione sinergica di entrambe le prospettive, in un modello ibrido che sappia coniugare il rigore formale con la sensibilità contestuale.

La dimensione temporale: dal rischio statico all’assessment continuo

Il paradigma tradizionale della valutazione del rischio, strutturato su cicli periodici e revisioni programmate, mostra evidenti limiti in un contesto caratterizzato da minacce persistenti avanzate (APT) e vulnerabilità zero-day. La transizione verso modelli di Continuous Risk Assessment rappresenta una risposta evolutiva a questa accelerazione della dinamica avversariale.

Questo spostamento paradigmatico implica una riconcettualizzazione dell’infrastruttura di monitoraggio, l’integrazione di capacità analitiche in tempo reale e l’adozione di architetture responsive capaci di ricalibrare automaticamente i parametri di rischio in risposta a nuovi indicatori di compromissione.

La dimensione umana: oltre il determinismo tecnologico

Nonostante la sofisticazione algoritmica dei moderni strumenti di valutazione, il fattore umano permane come variabile critica nell’equazione del rischio. La sicurezza comportamentale (behavioral security) emerge come disciplina complementare, riconoscendo che molte compromissioni derivano da vulnerabilità cognitive piuttosto che da debolezze tecniche.

L’integrazione di metriche psicometriche nei modelli di rischio, la valutazione della maturità della cultura della sicurezza e l’analisi delle dinamiche socio-organizzative rappresentano frontiere di ricerca promettenti per una modellazione più realistica della superficie di vulnerabilità.

L’asimmetria informativa e il paradosso dell’incertezza

Un aspetto epistemologicamente rilevante della valutazione del rischio risiede nella fondamentale asimmetria informativa tra difensori e attaccanti. Mentre i primi operano in un regime di trasparenza obbligata, dovendo proteggere sistemi completamente mappati e documentati, i secondi beneficiano dell’opacità strategica, potendo selezionare vettori d’attacco imprevisti.

Questa asimmetria strutturale impone l’adozione di principi di difesa in profondità (defense-in-depth) e l’incorporazione sistematica dell’incertezza nei modelli predittivi. Paradossalmente, la consapevolezza dei limiti conoscitivi può rafforzare la resilienza difensiva, stimolando approcci più robusti e stratificati.

La sovereignizzazione dell’assessment: geopolitica della sicurezza digitale

L’evoluzione contemporanea della valutazione del rischio informatico non può prescindere dalla sua contestualizzazione geopolitica. Assistiamo ad una progressiva sovereignizzazione delle pratiche di sicurezza, con stati nazionali che sviluppano framework proprietari rispondenti a specifiche visioni strategiche e dottrine di sicurezza nazionale.

Questa frammentazione normativa genera un mosaico globale di standard eterogenei che pone sfide significative alle organizzazioni transnazionali, costrette a navigare una complessità regolamentare crescente. Il RegTech (Regulatory Technology) emerge come disciplina ancillare, tentando di automatizzare la compliance attraverso architetture adattive capaci di riconfigurare i modelli di rischio in funzione delle giurisdizioni rilevanti.

La tensione tra universalismo metodologico e particolarismo normativo costituisce un dilemma irrisolto che riflette più ampie contraddizioni nella governance digitale globale.

L’assessment nel paradigma Zero Trust: dalla perimetrazione alla verificabilità perpetua

L’obsolescenza del modello di sicurezza perimetrale tradizionale ha catalizzato l’ascesa dell’architettura Zero Trust, fondamentalmente riconfigurando le coordinate concettuali della valutazione del rischio. In questa cornice epistemica, l’assessment si trasfigura da esercizio discontinuo e localizzato a flusso valutativo ininterrotto che interroga costantemente la legittimità di ogni transazione digitale.

Il principio “never trust, always verify” comporta una granularizzazione senza precedenti del rischio, ora atomizzato al livello della singola interazione. Questa micronizzazione valutativa richiede infrastrutture analitiche capaci di operare a scale precedentemente inconcepibili, fondendosi con tecnologie emergenti come l’edge computing per minimizzare la latenza decisionale.

Tale paradigma dissolve la dicotomia tradizionale tra interno ed esterno, sostituendola con una topologia di fiducia condizionale perpetuamente rinegoziata, dove il rischio viene calcolato come funzione contestuale di molteplici vettori identitari, comportamentali e situazionali.

La convergenza delle superfici: IT, OT e rischio cibernetico-fisico

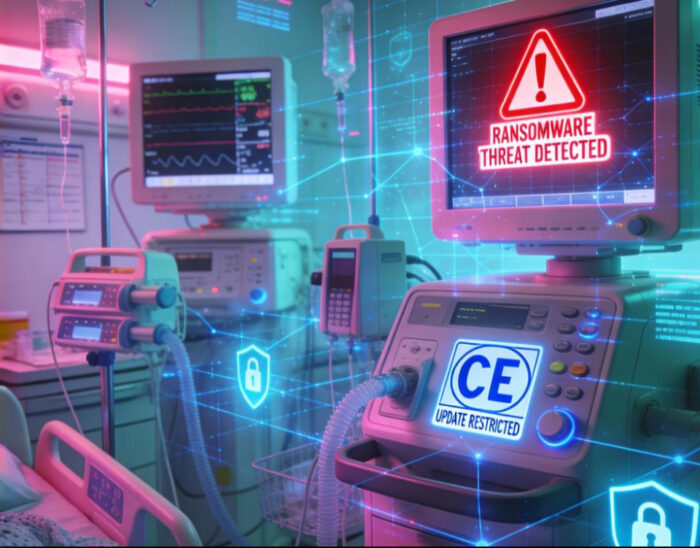

La progressiva dissoluzione dei confini tra tecnologie operazionali (OT) e infrastrutture informative (IT) ha generato una complessa superficie ibrida che richiede metodologie valutative capaci di trascendere le tradizionali categorizzazioni disciplinari. Nel contesto dell’Industria 4.0 e delle smart infrastructures, la valutazione del rischio deve necessariamente abbracciare la dimensione cibernetico-fisica (cyber-physical), riconoscendo le potenziali cascate di compromissione tra domini precedentemente disgiunti.

Questo amalgama tecnologico impone un ripensamento radicale dei modelli di impatto, ora costretti a contemplare scenari che travalicano la mera compromissione informativa per includere potenziali ripercussioni cinetiche. La crescente digitalizzazione di settori critici come energia, trasporti e sanità amplifica ulteriormente questa convergenza, trasformando vulnerabilità digitali in vettori di rischio esistenziale.

L’assessment in questi ecosistemi ibridi richiede competenze transdisciplinari e metodologie sintetiche che integrino domini epistemici storicamente separati, dalla sicurezza informatica all’ingegneria dei sistemi fisici, dall’analisi di affidabilità alla safety critica.

Il rischio algoritmico: l’intelligenza artificiale come soggetto e oggetto dell’assessment

L’intelligenza artificiale emerge contemporaneamente come soggetto e oggetto della valutazione del rischio, in una complessa dialettica riflessiva. Da un lato, i sistemi AI vengono impiegati per potenziare le capacità predittive e analitiche dell’assessment, promettendo elaborazione di pattern non lineari e correlazioni latenti invisibili alle metodologie tradizionali. Dall’altro, questi stessi sistemi rappresentano una nuova categoria di rischio che richiede framework valutativi dedicati.

Il rischio algoritmico presenta peculiarità ontologiche distintive: opacità decisionale, comportamenti emergenti non previsti in fase di design, vulnerabilità a manipolazioni avversariali e potenziale di amplificazione automatizzata di bias preesistenti. Queste caratteristiche sfidano i paradigmi tradizionali dell’assessment, progettati per sistemi deterministici con comportamenti ben definiti.

La valutazione del rischio AI-driven necessita di una riconcettualizzazione che integri principi di explainability, fairness e robustezza, riconoscendo la natura probabilistica e contestuale delle inferenze algoritmiche. Framework emergenti come AI Risk Management Framework del NIST rappresentano tentativi pionieristici di codificare questa nuova dimensione valutativa.

Parallelamente, l’impiego dell’AI nella difesa cibernetica introduce complessità di secondo ordine, con sistemi difensivi che potrebbero manifestare vulnerabilità emergenti o generare falsi positivi con impatti operativi significativi. Questa ricorsività del rischio richiede meta-modelli valutativi capaci di catturare dinamiche auto-referenziali.

La risk literacy come imperativo socio-tecnico

La crescente complessità della superficie di rischio digitale travalica le capacità interpretative di singoli esperti o dipartimenti isolati, richiedendo una diffusione capillare di competenze valutative attraverso l’intero tessuto organizzativo. La risk literacy emerge come meta-competenza cruciale, trascendendo le tradizionali categorizzazioni professionali.

Questa alfabetizzazione al rischio non si limita alla comprensione tecnica di vulnerabilità e minacce, ma abbraccia dimensioni cognitive ed epistemiche più profonde: consapevolezza dei bias decisionali, comprensione delle logiche probabilistiche, capacità di navigare contesti caratterizzati da incertezza profonda e ambiguità intrinseca.

Le organizzazioni all’avanguardia stanno riconcettualizzando i propri programmi formativi, integrando elementi di epistemologia applicata, teoria della complessità e pensiero sistemico accanto alle tradizionali competenze tecniche. Questa evoluzione riconosce che la resilienza digitale è fondamentalmente un fenomeno socio-tecnico che emerge dall’interazione tra sistemi tecnologici e reti cognitive umane.

La supply chain del rischio: ecosistemi vulnerabili e dipendenze transitive

L’interconnessione sistemica delle infrastrutture digitali contemporanee ha generato cascate di dipendenza che amplificano e ridistribuiscono il rischio attraverso network di relazioni commerciali, tecnologiche e operative. L’assessment tradizionale, focalizzato su perimetri organizzativi ben definiti, si rivela inadeguato di fronte alla natura transitiva delle vulnerabilità in ecosistemi digitali stratificati.

Eventi recenti come la compromissione SolarWinds o l’exploit di Log4j hanno drammaticamente evidenziato come vulnerabilità localizzate possano propagarsi attraverso catene di dipendenza, generando superfici di attacco emergenti non rilevabili attraverso analisi concentrate su singoli nodi dell’ecosistema.

Metodologie evolute di Third Party Risk Management (TPRM) tentano di modellizzare queste dipendenze transitive attraverso rappresentazioni topologiche che mappano non solo relazioni dirette ma anche catene di fornitura di secondo e terzo livello. Questo approccio richiede capacità analitiche sofisticate e accesso a metadati distribuiti, spesso ostacolato da asimmetrie informative e resistenze organizzative alla condivisione di informazioni sensibili.

La Trust Federation emerge come paradigma complementare, tentando di bilanciare la necessità di trasparenza con legittime preoccupazioni di riservatezza attraverso architetture informative che permettano verifiche attestabili senza completa divulgazione. Blockchain e tecnologie di zero-knowledge proof offrono promettenti substrati tecnologici per questi modelli federati di risk assessment.

Conclusioni: verso una metascienza del rischio digitale

La valutazione del rischio nella sicurezza digitale trascende ormai i confini di una mera pratica tecnica per configurarsi come disciplina epistemica autonoma, con propri paradigmi, metodologie e frontiere di ricerca. La sua evoluzione futura richiederà un’integrazione sempre più profonda con domini adiacenti come l’intelligenza artificiale, la teoria della complessità e le scienze comportamentali.

In un’epoca caratterizzata da quella che Ulrich Beck definiva “società del rischio”, l’assessment digitale assume valenze che travalicano le mere considerazioni tecniche per innestarsi in più ampie dinamiche sociali, economiche e politiche. La crescente digitalizzazione dell’esistenza trasforma la sicurezza informatica da dominio specialistico a infrastruttura critica della civiltà contemporanea.

La sfida centrale risiede nel sviluppare arsenali metodologici che bilancino determinismo analitico e comprensione dell’incertezza radicale, quantificazione algoritmica e sensibilità contestuale, tecnicità procedurale e consapevolezza delle implicazioni etiche. Solo attraverso questa sintesi transdisciplinare la valutazione del rischio potrà emergere come autentico strumento di resilienza digitale in un ecosistema caratterizzato da complessità irriducibile e cambiamento accelerato.

Il vero obiettivo non è l’eliminazione dell’incertezza – aspirazione illusoria in un dominio intrinsecamente complesso – ma la sua gestione informata attraverso modelli concettuali e operativi che bilancino rigore analitico e pragmatismo decisionale. In ultima analisi, la valutazione del rischio digitale rappresenta un esercizio di navigazione epistemica tra conoscibilità e indeterminazione, in un territorio dove la mappa non è mai perfettamente sovrapponibile al territorio.

Bibliografia

- NIST. (2022). “Risk Management Framework for Information Systems and Organizations” (NIST SP 800-37 Rev. 2). https://csrc.nist.gov/publications/detail/sp/800-37/rev-2/final

- International Organization for Standardization. (2018). “ISO/IEC 27005:2018 Information technology — Security techniques — Information security risk management”. https://www.iso.org/standard/75281.html

- Hubbard, D. W., & Seiersen, R. (2016). “How to Measure Anything in Cybersecurity Risk”. Wiley.

- FAIR Institute. (2021). “Factor Analysis of Information Risk (FAIR) Framework”. https://www.fairinstitute.org/what-is-fair

- European Union Agency for Cybersecurity (ENISA). (2024). “Threat Landscape 2024”. https://www.enisa.europa.eu/publications/enisa-threat-landscape-2024

- Lallie, H. S., et al. (2023). “The Evolution of Cyber-Physical Threats in Critical Infrastructure: A Systematic Review”. Journal of Network and Computer Applications, Vol. 203.

- Ponemon Institute. (2024). “Cost of a Data Breach Report 2024”. IBM Security.

- World Economic Forum. (2025). “Global Risks Report 2025”. https://reports.weforum.org/docs/WEF_Global_Risks_Report_2025.pdfhttps://www3.weforum.org/docs/WEF_Global_Risks_Report_2024.pdf

- NIST. (2023). “Artificial Intelligence Risk Management Framework” (AI RMF 1.0). https://www.nist.gov/itl/ai-risk-management-framework

- Beck, U. (1992). “Risk Society: Towards a New Modernity”. SAGE Publications.

- Cohen, F. (2023). “The Zero Trust Risk Assessment Model: A Formal Approach”. Journal of Cybersecurity, Vol. 9, Issue 2.

- Schneier, B. (2023). “A Hacker’s Mind: How the Powerful Bend Society’s Rules, and How to Bend them Back”. W. W. Norton & Company.

- MITRE. (2024). “System of Trust Framework, SoT” https://sot.mitre.org/

framework/system_of_trust.html - European Commission. (2023). “Cyber Resilience Act”. https://digital-strategy.ec.europa.eu/en/library/cyber-resilience-act

- Kahneman, D., Sibony, O., & Sunstein, C. R. (2021). “Noise: A Flaw in Human Judgment”. Little, Brown Spark.