Securing Intelligence at the Edge: cybersecurity e standard per il continuum Edge-to-Cloud nell’era dell’IA

L’intervento di Dario Sabella al 23° Forum ICT Security esplora le sfide della sicurezza informatica nell’epoca dell’intelligenza artificiale distribuita, tracciando un percorso tra standard internazionali, tecnologie emergenti e nuovi paradigmi architetturali.

L’evoluzione tecnologica degli ultimi anni ha portato a una trasformazione radicale delle infrastrutture digitali. La convergenza tra edge computing, reti 5G e intelligenza artificiale sta ridisegnando i confini tradizionali del cloud, creando nuove opportunità ma anche sfide inedite sul fronte della cybersecurity. È questo il tema al centro dell’intervento di Dario Sabella, CEO di Next G Cloud e Vice President di xFlow Research, nonché Chairman del gruppo ETSI MEC (Multi-access Edge Computing), presentato al Forum ICT Security 2025.

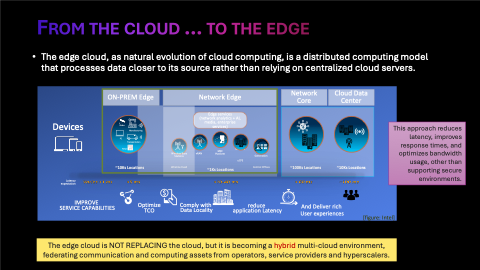

L’edge computing: un’evoluzione naturale del cloud

L’intervento si apre con una domanda apparentemente semplice: cos’è l’edge computing e dove si trova? Il relatore richiama una definizione forse semplicistica ma efficace, di quando era giovane studente 25 anni fa, attribuita a un suo professore del Politecnico di Torino: «Cos’è il cloud? È il computer di un altro!». Per cui l’edge cloud, in sostanza, rappresenta quel cosiddetto “computer di un altro”, ma posizionato più vicino all’utente finale, rispetto al cloud.

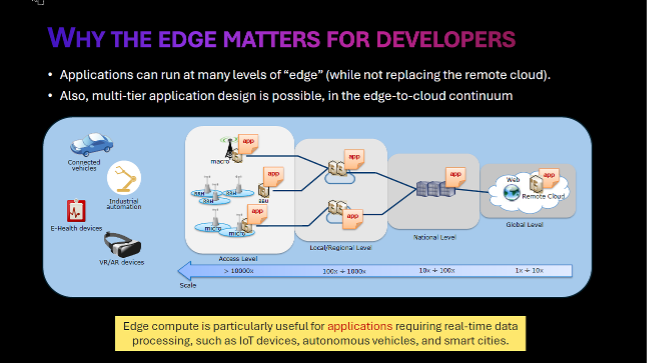

La localizzazione dell’edge non è però univoca: può essere regionale, nel data center più prossimo, nell’infrastruttura di rete dell’operatore mobile, on-premise nell’azienda dell’utente, o addirittura nel dispositivo stesso. «Se siete confusi su dove sia l’edge computing è normale», spiega Sabella, «non si deve per forza definire dove sia e quanto sia “profondo” l’edge, perché tale deployment deve essere flessibile e “opportunistico” in base alla convenienza di business».

Questa flessibilità porta con sé un trade-off fondamentale: maggiore prossimità significa minore latenza e migliori performance, ma richiede una distribuzione più capillare dei server con conseguente aumento dei costi di deployment. La scelta dipende quindi dalla criticità dell’applicazione: se per alcune può essere sufficiente un server distante centinaia di chilometri, per applicazioni di robotica industriale con requisiti di latenza nell’ordine dei 15 millisecondi per frame, la prossimità diventa imprescindibile.

L’intelligenza artificiale si sposta verso l’edge

Una delle trasformazioni più significative in atto riguarda la progressiva migrazione dell’AI dal cloud centralizzato verso l’edge. Attualmente, l’utilizzo dell’intelligenza artificiale si basa prevalentemente su grandi piattaforme cloud pubbliche, ma questa centralizzazione presenta diverse criticità: i dati appartengono a terzi, i costi possono essere elevati, e la governance dei dati risulta complessa.

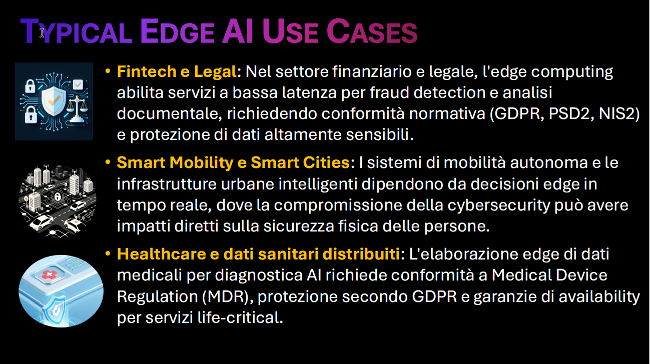

L’edge AI rappresenta un’opzione che promette maggiore controllo sui dati, costi potenzialmente inferiori grazie a un minor consumo energetico, e una sovranità digitale più completa. Gli ambiti applicativi sono molteplici: dallo smart building, dove sensori distribuiti gestiscono ottimizzazioni termiche mantenendo la privacy degli utenti, al settore finanziario, dove banche diverse possono collaborare sul rilevamento di frodi senza esporre i propri dati sensibili.

Nel settore fintech e legale, l’edge computing abilita servizi a bassa latenza per fraud detection e analisi documentale, richiedendo conformità normativa a GDPR, PSD2 e NIS2. Per smart mobility e smart city, i sistemi di mobilità autonoma dipendono da decisioni edge in tempo reale, dove compromissioni della cybersecurity possono avere impatti diretti sulla sicurezza fisica delle persone. Nel settore sanitario, l’elaborazione edge di dati medicali per diagnostica AI richiede conformità alla Medical Device Regulation e garanzie di availability per servizi life-critical.

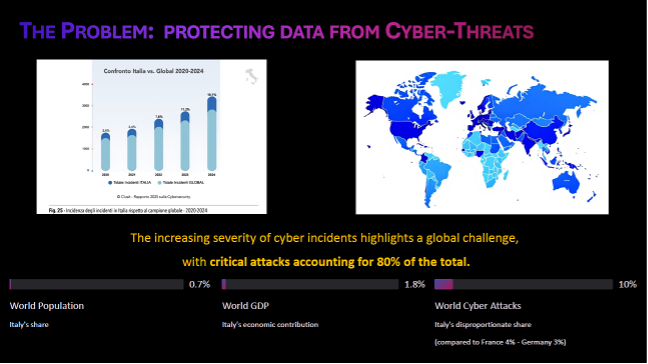

Il problema della cybersecurity: l’Italia sovraesposta

L’intervento porta l’attenzione su un dato allarmante tratto dal Rapporto Clusit 2024: l’Italia subisce il 10% degli attacchi cyber globali, pur rappresentando solo lo 0,7% della popolazione mondiale e l’1,8% del PIL globale. Un dato clamoroso, ancor più se paragonato a Francia (4%) e Germania (3%), e che rivela una significativa sovraesposizione del sistema paese.

La spiegazione è probabilmente strutturale: il tessuto economico italiano è composto per almeno il 95% da piccole e medie imprese (dati ISTAT), spesso non sufficientemente consapevoli o attrezzate per fronteggiare le minacce cyber. «Questa è una realtà, ed è da un lato sicuramente un’opportunità per le aziende che lavorano nella sicurezza, ma è altresì importante per le aziende porsi questo problema in anticipo prima che ci siano dei problemi», sottolinea il relatore.

La sicurezza nel continuum edge-to-cloud

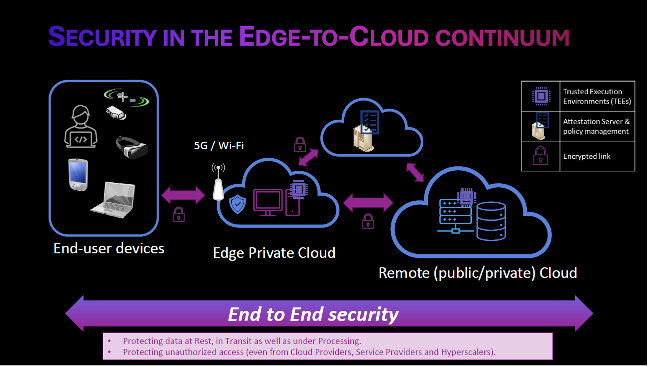

La complessità degli ambienti edge-to-cloud introduce sfide di sicurezza multidimensionali che vanno oltre la semplice protezione perimetrale. I sistemi moderni coinvolgono molteplici attori nella catena del valore, ciascuno con le proprie policy di sicurezza, e devono gestire problematiche di trust tra domini diversi.

La domanda fondamentale che emerge è: posso fidarmi di qualunque AI? Da dove vengono i dati per il training? Come viene gestita la data governance? Come gestire eventuali problemi per garantire la compliance? Questi interrogativi sono particolarmente critici nei mercati regolamentati come fintech, sanità e mobilità.

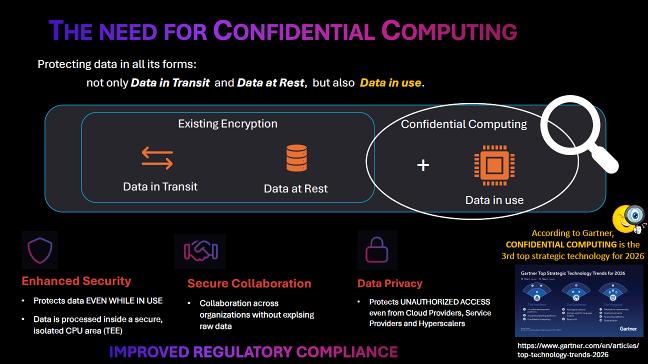

La protezione dei dati deve essere garantita in tutte le sue forme: a riposo (backup e storage criptati), in transito (HTTPS e protocolli sicuri), ma anche durante l’utilizzo (TEE – Trusted Execution Environments). Ed è proprio quest’ultimo aspetto a rappresentare la frontiera emergente della sicurezza.

Confidential Computing: proteggere i dati durante l’elaborazione

Il Confidential Computing emerge come tecnologia chiave per la protezione dei dati in uso, mediante TEE (le cosiddette “enclave” software). Secondo Gartner, rappresenta la terza tecnologia strategica nei trend del 2026. Il principio è semplice ma rivoluzionario: le applicazioni girano in un’area della memoria cifrata che non può essere decifrata da nessuno, nemmeno dal proprietario dell’infrastruttura o dall’hyperscaler.

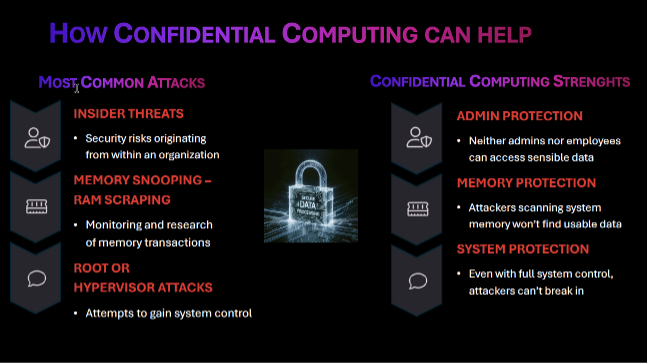

Questa protezione risponde a tre categorie principali di minacce: gli insider threat, ovvero rischi originati dall’interno dell’organizzazione; il memory snooping e RAM scraping, tecniche di monitoraggio delle transazioni di memoria; e gli attacchi a livello root o hypervisor, tentativi di ottenere il controllo del sistema.

Il Confidential Computing offre protezione a livello amministrativo (né admin né dipendenti possono accedere ai dati sensibili), protezione della memoria (gli attaccanti che scansionano la memoria non trovano dati utilizzabili) e protezione di sistema (anche con controllo completo del sistema, gli attaccanti non possono violare l’enclave sicura).

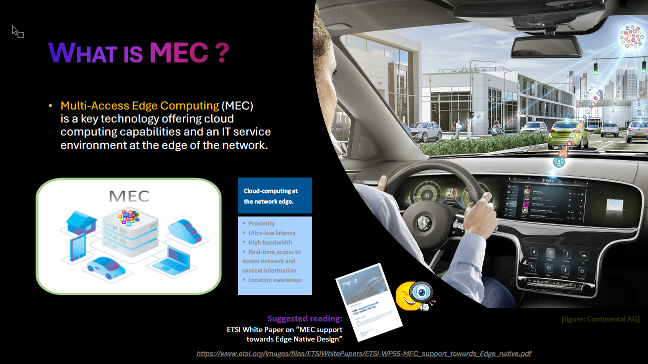

ETSI MEC: lo standard per l’edge computing

La standardizzazione gioca un ruolo cruciale in questo scenario di eterogeneità tecnologica. Il gruppo ETSI Multi-access Edge Computing, di cui Sabella è Chairman dal 2021, conta oltre 200 membri tra grandi corporation, PMI, governi, università e centri di ricerca, e lavora alla definizione di standards che garantiscano l’interoperabilità in un ecosistema così complesso.

Il Multi-access Edge Computing offre capacità di cloud computing e un ambiente di servizi IT ai margini della rete, garantendo prossimità, ultra-bassa latenza, alta banda e consapevolezza della localizzazione. L’architettura MEC è access-agnostic, funzionando indifferentemente su connettività 5G, Wi-Fi o rete fissa.

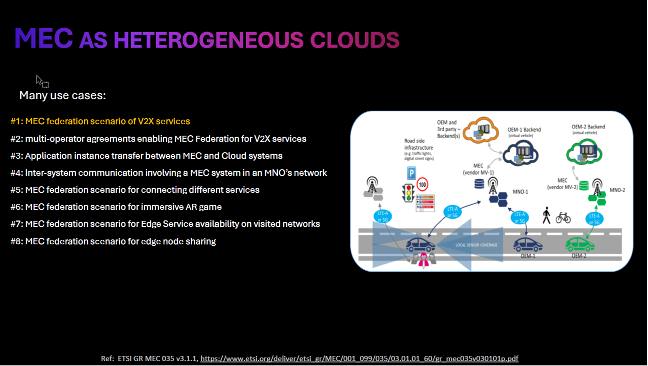

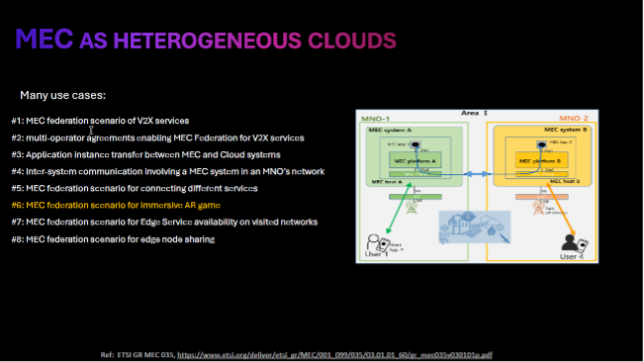

L’esempio delle smart city illustra efficacemente la complessità del problema: automobili di marche diverse, con SIM di operatori diversi, che devono comunicare con infrastrutture cloud di provider diversi. «Il mondo è per sua natura eterogeneo», osserva il relatore, «l’unica soluzione che garantisce interoperabilità è quella dello standard, perché consente di mettere d’accordo tutte le tecnologie e tutti gli stakeholder nella catena del valore».

Anche il gaming immersivo costituisce un caso d’uso emblematico: giocatori con connettività di operatori diversi che vogliono interagire in una stanza virtuale condivisa richiedono la federazione di infrastrutture edge diverse per garantire la bassa latenza necessaria.

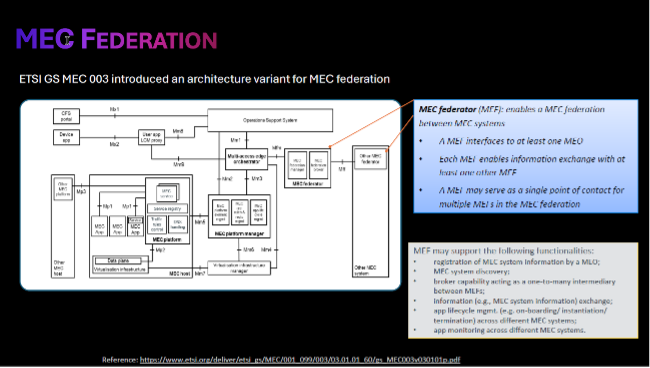

La federazione MEC: far dialogare sistemi diversi

Per rispondere a questa complessità, lo standard ETSI MEC (in collaborazione con GSMA OPG e 3GPP SA6) ha introdotto il concetto di federazione, che consente a sistemi MEC diversi di comunicare e collaborare. Il MEC Federator (MEF) abilita lo scambio di informazioni tra sistemi, la scoperta di risorse, la gestione del ciclo di vita delle applicazioni attraverso domini diversi.

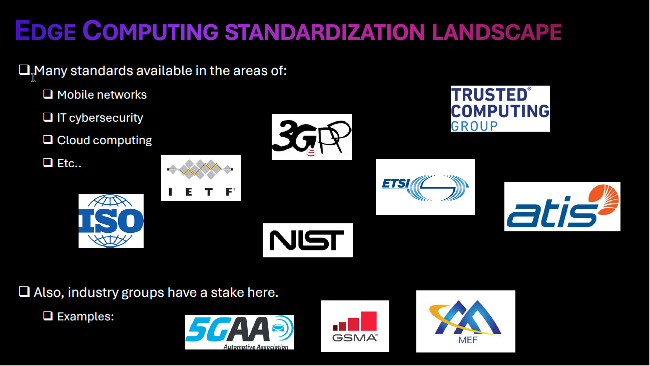

Standard e regolamentazione: la cassetta degli attrezzi

Un aspetto fondamentale dell’intervento riguarda il “reality check” sugli strumenti disponibili per la sicurezza nell’edge computing. L’analisi condotta nel white paper ETSI sulla sicurezza MEC, di cui Dario Sabella è stato uno degli autori principali, ha mappato il panorama degli standard pertinenti, coinvolgendo esperti di diversi organismi: ETSI, 3GPP, TCG, IETF e altri.

«Strumenti ce ne sono», afferma il relatore, «non è solo un problema tecnico, è anche un problema di utilizzo degli standard internazionali e di allineamento della industry. Non bisogna andare a reinventare la ruota».

L’urgenza è dettata anche dall’imminente entrata in vigore del Cyber Resilience Act europeo, con finalizzazione degli standards prevista per fine 2026, che impatterà l’80% dei prodotti connessi prodotti dalle PMI europee. Gli standard in via di finalizzazione diventeranno presto norma europea, rendendo la compliance un requisito business-critical per la commercializzazione dei prodotti.

La call to action: partecipare alla standardizzazione

Le conclusioni dell’intervento assumono la forma di un invito all’azione rivolto alla platea di professionisti della sicurezza: «La sicurezza quindi non è solo un problema tecnico da risolvere a posteriori, ma una proprietà sistemica da progettare all’inizio con un approccio end-to-end. Solo attraverso standards armonizzati con la cooperazione multi-stakeholder e una visione olistica della sicurezza potremo trasformare la promessa dell’intelligenza distribuita in una realtà affidabile e resiliente».

L’esortazione finale è chiara: invece di subire passivamente la standardizzazione, le aziende dovrebbero partecipare attivamente ai gruppi di lavoro che definiscono le regole del gioco. «Alzate la voce e magari partecipate a questi gruppi di standard che definiscono quello che poi diventerà mandatorio per tutti noi, per la compliance, per i nostri prodotti, le nostre soluzioni, i nostri servizi».

In un’epoca in cui l’intelligenza artificiale si sta distribuendo capillarmente verso l’edge della rete, la sicurezza non può più essere un ripensamento ma deve diventare parte integrante della progettazione. E in questo processo, la partecipazione italiana alla definizione degli standard internazionali rappresenta non solo un’opportunità, ma una necessità strategica.

Guarda il vedo completo dell’intervento “Securing Intelligence at the Edge: sfide, soluzioni e standard di cybersecurity per il Continuum Edge-to-Cloud nell’era dell’IA” di Dario Sabella, CEO di Next G Cloud e Vice President di xFlow Research, nonché Chairman del gruppo ETSI MEC (Multi-access Edge Computing), tenutosi durante Forum ICT Security 2025. Trovi qui le slide dell’intervento.

Dario Sabella works with xFlow Research as Vice President, Technology and Standards, leading the team’s involvement in ETSI, both on standardization and open-source activities, and guiding the strategy to expand in other areas, also for features evolution and prioritization in the company. Since 2025, he is also CEO of the Italian company Next G Cloud, focused on Cloud Managed Services and Edge Cybersecurity solutions. Serving since 2021 as Chairman of the ETSI MEC (Multi-access Edge Computing), an international stand body with 180+ members and participants from industry, research and government agencies. In his career, Dario was previously with Intel Corporation for about 8 years as Senior Manager Standards and Research, driving new technologies and edge cloud innovation, and earlier he worked for 16+ years in TIM (Telecom Italia group), as responsible in various research, experimental and operational activities on cellular technologies. IEEE senior member, prolific author of several publications (80+) and patents (50+) in the field of communications, energy efficiency and edge computing. Member of the European Task Forces on Cybersecurity and 6G. Member of the Editorial Board of MIT Technology Review Italia.