Machine Learning e cybersecurity: potenzialità e limiti nell’individuazione delle minacce

Intervento di Giorgio Giacinto al 23° Forum ICT Security – “Il Machine Learning aiuta a individuare i componenti malevoli di una minaccia?”

Il machine learning rappresenta oggi uno strumento imprescindibile nella lotta contro le minacce informatiche, ma la sua efficacia dipende da una progettazione accurata e dalla consapevolezza dei suoi limiti intrinseci. È questo il messaggio centrale emerso dall’intervento del Professor Giorgio Giacinto, ordinario di Ingegneria Informatica presso l’Università di Cagliari, durante il 23° Forum ICT Security tenutosi a Roma il 19 e 20 novembre 2025.

Lo speaker ha aperto la sua relazione contestualizzando il tema all’interno del panorama della ricerca italiana in cybersicurezza, citando il progetto SERICS (Security and Rights in the Cyberspace), un partenariato esteso finanziato dal PNRR che ha coinvolto l’intero sistema universitario nazionale. L’iniziativa, nata in seno al Cybersecurity National Lab del CINI, ha dato vita a 27 progetti di ricerca, cui si aggiungono altri 54 finanziati attraverso bandi a cascata, con l’assunzione di 134 nuovi ricercatori e un investimento complessivo di 113 milioni di euro.

Dall’interpretazione dei sensi umani alla cybersecurity

L’esperto ha ricordato come l’intelligenza artificiale abbia mosso i primi passi nell’interpretazione dei sensi umani: immagini, video, suoni. La sfida attuale consiste nel trasferire questa conoscenza, maturata in un contesto “umano”, verso un mondo completamente artificiale come quello informatico. I fattori chiave di questo sviluppo sono stati molteplici: modelli sempre più sofisticati capaci di simulare alcuni aspetti specifici del ragionamento umano, l’accumulo di enormi quantità di dati, le tecnologie IoT e la crescente disponibilità di risorse computazionali.

Applicando queste tecniche alla cybersecurity, il relatore ha evidenziato come gli attacchi stiano diventando sempre più sofisticati per diverse ragioni: sono realizzati con componenti diverse, ciascuna delle quali presa singolarmente non appare malevola; vengono eseguiti in più fasi; assomigliano sempre più ad attività legittime; sfruttano vulnerabilità del software non immediatamente emergenti. Ha citato come esempio recente le vulnerabilità scoperte in applicazioni come WhatsApp, dove un eseguibile malevolo era stato nascosto all’interno di un’immagine contenuta in un file zip.

L’analisi delle applicazioni Android: un caso di studio illuminante

Particolarmente interessante è stato l’approfondimento sulle tecniche di analisi del malware per applicazioni Android. L’approccio adottato dal gruppo di ricerca dell’Università di Cagliari non si è limitato a far apprendere al sistema l’applicazione nella sua interezza, ma ha proceduto scomponendola in componenti elementari: da un lato il codice, dall’altro le risorse associate, come le immagini potenzialmente utilizzate per nascondere contenuti malevoli.

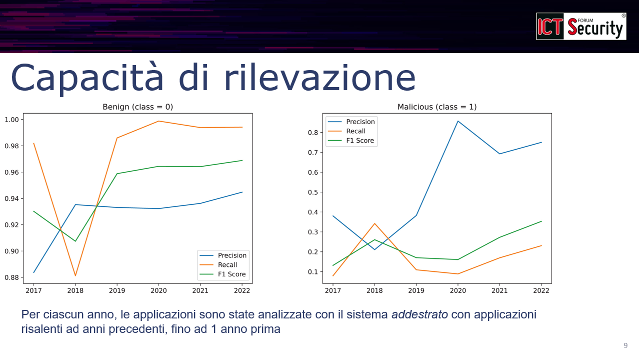

Un esperimento particolarmente significativo ha riguardato la rappresentazione semplificata delle applicazioni attraverso la sequenza delle chiamate a funzioni critiche, ovvero quelle che il sistema Android stesso definisce come sensibili (accesso alla rete, al Bluetooth, alla localizzazione). L’obiettivo non era tanto dimostrare se un’applicazione fosse malevola o meno, quanto verificare la possibilità di spiegare all’esperto umano quali componenti rendessero sospetta un’applicazione.

I risultati hanno messo in luce un fenomeno cruciale: nel 2018 si è verificato un crollo significativo nelle prestazioni del sistema di rilevamento. La causa? Android aveva modificato in modo sostanziale il paradigma di programmazione delle applicazioni, rendendo obsoleto l’addestramento precedente del modello. Questo episodio dimostra plasticamente come i sistemi di machine learning dipendano strettamente dai dati storici su cui sono stati addestrati.

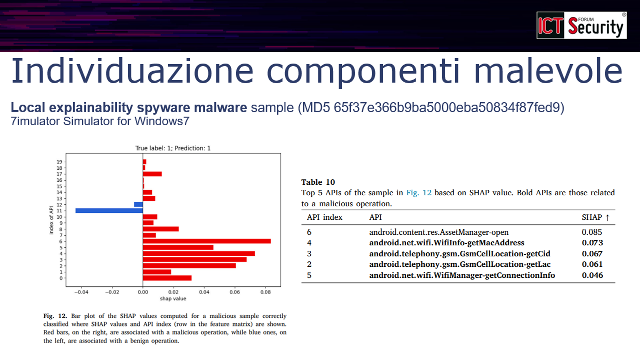

L’aspetto più innovativo di questo approccio risiede nella capacità di fornire spiegazioni. Analizzando uno spyware, il sistema è stato in grado di indicare quali funzioni — legate ad esempio alla localizzazione GPS e alle connessioni WiFi — contribuissero maggiormente alla classificazione come malevolo. Confrontando questo risultato con l’analisi di un’applicazione legittima, dove tutte le caratteristiche puntavano verso la classificazione benigna, emerge il valore di questi strumenti per il professionista della sicurezza: non solo un verdetto, ma una spiegazione delle ragioni che lo sostengono.

I Large Language Model entrano in gioco

L’intervento ha poi esplorato le frontiere più recenti della ricerca, con l’utilizzo dei Large Language Model per l’analisi dinamica delle applicazioni. A differenza dell’analisi statica, che esamina il codice senza eseguirlo, l’analisi dinamica richiede di far funzionare l’applicazione in un ambiente controllato, simulando le interazioni di un utente reale.

Il sistema sviluppato combina un modello visuale (VLM), capace di interpretare ciò che appare sullo schermo, con un LLM che analizza il testo presente. Questa combinazione, integrata con l’analisi del codice dell’applicazione, permette di governare automaticamente una sequenza di interazioni — click, inserimenti, navigazione — che coprono in modo più completo i possibili comportamenti dell’applicazione, registrando le attività svolte per individuare eventuali comportamenti malevoli.

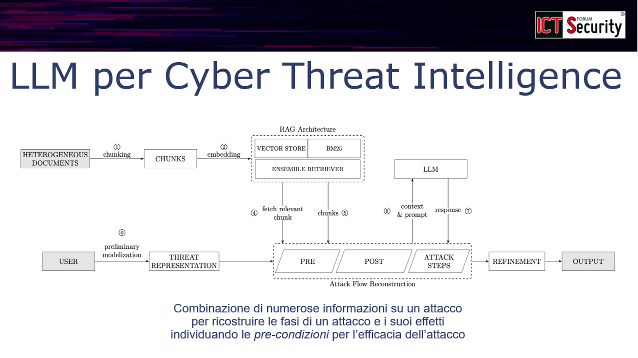

Un ulteriore ambito di applicazione riguarda la Cyber Threat Intelligence. I rapporti sulle minacce informatiche comprendono documenti di natura eterogenea: da quelli strutturati per la comunicazione machine-to-machine (indicatori di compromissione) a report testuali destinati agli esperti umani. L’idea del gruppo di ricerca è di suddividere questi documenti in piccole unità concettuali, più facilmente elaborabili dai motori di intelligenza artificiale, per sintetizzare le precondizioni che rendono possibile un attacco e le postcondizioni che ne segnalano l’avvenuta esecuzione. L’obiettivo finale è disporre di un sistema capace di simulare gli effetti di un attacco sulla propria infrastruttura aziendale, anticipandone le conseguenze.

L’IA come arma a doppio taglio

Lo speaker non ha mancato di sottolineare come l’intelligenza artificiale sia uno strumento nelle mani di entrambe le parti. Anche gli attaccanti la utilizzano per sviluppare i propri attacchi: non tanto per creare malware da zero — poiché l’IA si basa sulla conoscenza passata e non può inventare il futuro — quanto per accelerare significativamente la fase di sviluppo e test delle singole componenti. Esistono già rapporti, tra cui uno di Google, che documentano tentativi di utilizzare gli LLM per creare codice malevolo, aggirando le protezioni dei sistemi.

Ma la stessa strategia può essere impiegata a scopo difensivo: interrogare sistematicamente questi modelli per individuare possibili vettori di attacco e verificare costantemente la propria postura di sicurezza.

Le insidie dell’apprendimento automatico

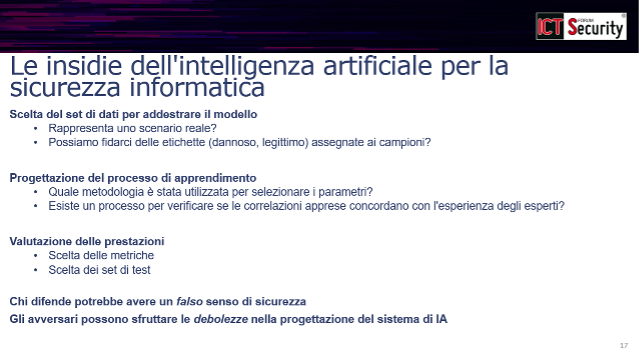

Una parte sostanziale dell’intervento è stata dedicata alle vulnerabilità intrinseche dei sistemi di machine learning. Il relatore ha identificato tre snodi critici nella catena dell’apprendimento automatico: l’acquisizione dei dati, la loro rappresentazione e il meccanismo di ottimizzazione.

Sul primo aspetto, la domanda fondamentale riguarda l’affidabilità delle fonti e di chi “etichetta” i dati, distinguendo ciò che è malevolo da ciò che è legittimo. Se qualcuno manipola le etichette, l’intero sistema viene compromesso. Sulla rappresentazione, l’esperto ha ricordato che questi strumenti lavorano su dati numerici: è cruciale che la rappresentazione numerica rifletta fedelmente le somiglianze e le differenze del mondo reale. Infine, il meccanismo di ottimizzazione — la funzione matematica che separa “legittimo” e “malevolo” — dipende dalla definizione stessa di “ottimo”, che non è univoca.

Le domande che ogni professionista dovrebbe porsi sono dunque: il dataset di addestramento rappresenta uno scenario reale? Le etichette sono affidabili? Le correlazioni individuate dal sistema concordano con l’esperienza degli esperti? Quali metriche vengono utilizzate per valutare le prestazioni? Un falso senso di sicurezza può aprire la strada agli avversari.

Adversarial Machine Learning: quando l’IA viene attaccata

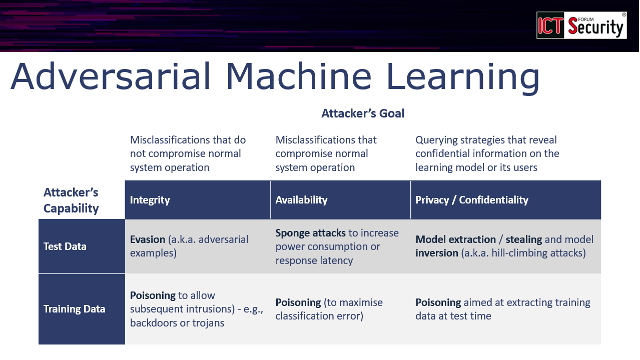

Il gruppo di ricerca dell’Università di Cagliari si occupa da oltre un decennio di Adversarial Machine Learning, ovvero lo studio delle debolezze dei sistemi di intelligenza artificiale inquadrate nella classica triade della cybersecurity: integrità, disponibilità e riservatezza.

Gli attacchi più tipici sono di due tipi. Gli attacchi di evasione mirano a creare campioni malevoli che attraversano la superficie di decisione del sistema, apparendo come benigni. Ancora più insidiosi sono gli attacchi di poisoning (avvelenamento), che mirano a inquinare i dati di addestramento per deviare il processo di apprendimento e introdurre backdoor sfruttabili successivamente.

Il relatore ha fatto notare come la comunità scientifica, non disponendo di risorse infinite, e avendo necessità di produrre risultati replicabili, spesso utilizzi dataset condivisi gratuitamente. Proprio in questi archivi un attaccante potrebbe inserire dati manipolati che compromettono silenziosamente i modelli addestrati.

MITRE ha sistematizzato queste tipologie di attacco nella matrice ATLAS (Adversarial Threat Landscape for Artificial-Intelligence Systems), mappando tecniche e tattiche nelle diverse fasi di un attacco: ricognizione, sviluppo delle risorse, accesso iniziale e così via.

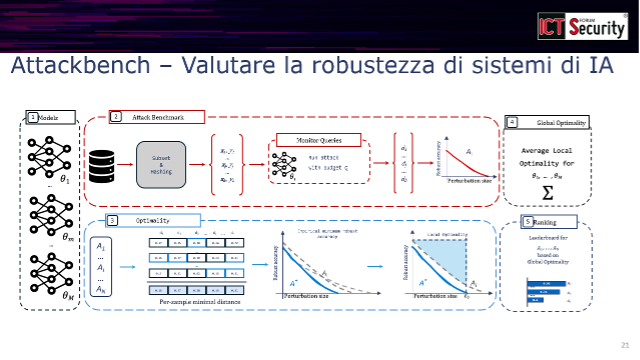

AttackBench: uno strumento per la verifica della robustezza

Nell’ambito del progetto SERICS, il laboratorio dell’Università di Cagliari ha sviluppato AttackBench, uno strumento automatico che consente a chi sviluppa sistemi di intelligenza artificiale di verificarne la robustezza rispetto agli attacchi noti. Il sistema sottopone il modello a diverse tipologie di attacco e restituisce indicazioni sulla necessità di interventi correttivi.

Conclusioni

L’intelligenza artificiale si conferma uno strumento potente, capace di elaborare rapidamente grandi quantità di dati eterogenei provenienti da sistemi diversi. Ma la stessa potenza è a disposizione degli attaccanti. L’efficacia della difesa, ha concluso il Professor Giacinto, dipende dalla conoscenza approfondita sia dei meccanismi di apprendimento automatico sia delle tecniche di attacco. Solo questa duplice competenza consente di sviluppare strumenti di difesa realmente efficaci e non soltanto apparentemente tali.

Guarda il video dell’intervento completo:

Giorgio Giacinto è professore di Ingegneria Informatica presso l'Università di Cagliari, dove è coordinatore del corso di Laurea Magistrale in Computer Engineering, Cybersecurity and Artificial Intelligence. L’attività di ricerca, svolta nell’ambito di progetti finanziati a livello locale, nazionale e Europeo, è principalmente focalizzata su tecniche di machine learning per la cybersicurezza. E’ componente del collegio dei docenti del Dottorato in ingegneria Elettronica e Informatica dell’Università di Cagliari e del Dottorato di Interesse nazionale in Cybersicurezza, coordinato da IMT Lucca. Ha pubblicato circa 200 articoli in conferenze e riviste internazionali. All'interno del consorzio CINI è uno dei vice direttori del Cybersecurity National Lab e un componente del comitato di gestione dell'Artificial Intelligence & Intelligent Systems Lab. E’ componente della delegazione italiana del MUR nel Comitato di Programma di Horizon Europe, Cluster III “Civil Security for Society”. E’ guest professor presso la Lulea University of Technology, Svezia, all’interno del gruppo di ricerca Pervasive and Mobile Computing. E’ fellow della IAPR (International Association for Pattern Recognition) per le attività di ricerca in sicurezza informatica ed è senior member della IEEE Computer Society e dell'ACM.