Dal quantum computing alla crittografia del futuro: la roadmap verso la sicurezza post-quantum

La transizione verso nuovi standard crittografici è urgente: entro il 2030 le infrastrutture critiche dovranno essere protette dagli attacchi dei computer quantistici. Al Forum ICT Security 2025, Marco Baldi illustra stato dell’arte, sfide tecnologiche e il contributo della ricerca italiana agli algoritmi di nuova generazione

La corsa verso il quantum computing sta accelerando in modo esponenziale, e con essa l’urgenza di ripensare completamente la sicurezza delle nostre infrastrutture digitali. Al 23° Forum ICT Security, svoltosi a Roma il 19 e 20 novembre 2025, il professor Marco Baldi, docente di Telecomunicazioni presso il Dipartimento di Ingegneria dell’Informazione dell’Università Politecnica delle Marche, ha tracciato un quadro dettagliato e allarmante delle sfide che attendono il mondo della cybersecurity con il suo intervento “Tecnologie quantistiche per la sicurezza ICT e transizione alla crittografia post-quantum“.

I progressi della scienza dell’informazione quantistica stanno infatti rendendo possibili applicazioni che fino a pochi anni fa erano soltanto teoriche. Ma con queste opportunità arrivano anche nuovi, gravissimi rischi: un attaccante dotato di un computer quantistico sufficientemente potente sarà in grado di compromettere la maggior parte dei sistemi crittografici su cui oggi si basa la sicurezza di Internet, delle transazioni bancarie, delle comunicazioni governative e di tutte le nostre infrastrutture digitali.

Due facce della rivoluzione quantistica

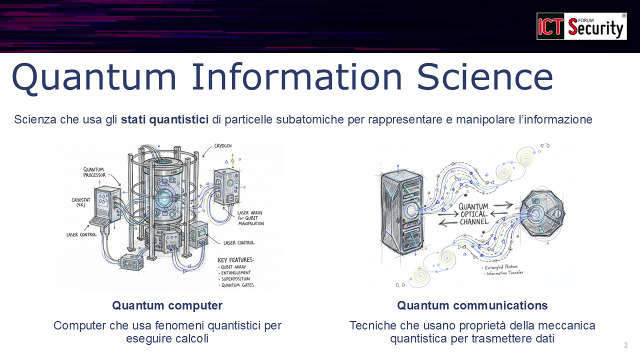

Il relatore ha esordito con una distinzione fondamentale, spesso confusa nel dibattito pubblico e mediatico. «È molto utile dividere le due grandi famiglie di tecnologie quantistiche che oggi abbiamo a disposizione, anche per evitare di cadere nel minestrone quantum in cui qualche volta ci ritroviamo», ha spiegato Baldi.

La prima famiglia è quella del quantum computing: computer che utilizzano fenomeni della meccanica quantistica, come la sovrapposizione quantistica, per eseguire calcoli. Il concetto chiave è il quantum bit, o qubit, che a differenza del bit classico può esistere in uno stato di sovrapposizione quantistica. Questo consente «una sorta di parallelismo intrinseco che accelera notevolmente alcuni calcoli», aprendo possibilità di calcolo impossibili per i computer tradizionali.

La seconda famiglia, molto distinta, è quella delle quantum communications: tecniche che utilizzano proprietà della meccanica quantistica per trasmettere informazioni con garanzie di sicurezza fisica. L’esempio più noto è la Quantum Key Distribution (QKD), che sfrutta il teorema di non clonazione: qualsiasi tentativo di intercettazione perturba il fenomeno quantistico stesso, rendendo l’attacco teoricamente rilevabile

L’escalation tecnologica: da D-Wave a IBM Nighthawk

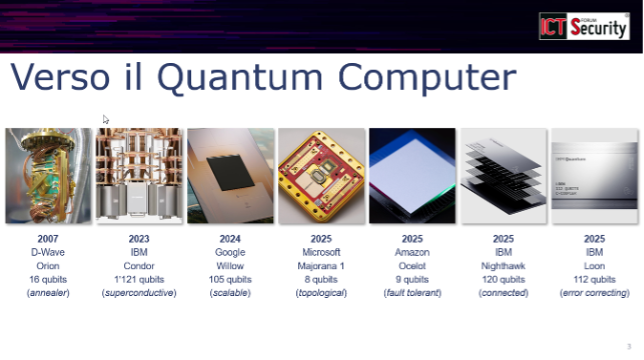

Lo sviluppo dei computer quantistici è passato dalla teoria alla pratica con un’accelerazione impressionante negli ultimi due decenni. Nel 2007 l’azienda canadese D-Wave presentò il primo processore quantistico basato su quantum annealing, una tecnica che sfrutta fenomeni quantistici meno generali della sovrapposizione quantistica ma che ha comunque consentito di raggiungere migliaia di qubit basati su annealing.

Nel frattempo, IBM ha guidato la corsa verso processori basati su sovrapposizione quantistica, il fenomeno più generale, arrivando nel 2023 con il chip Condor a superare la soglia dei 1.000 qubit fisici. Ma l’esperto ha sottolineato un aspetto cruciale spesso trascurato: «Quei qubit sono qubit fisici e per realizzare un qubit logico servono addirittura centinaia di quei qubit fisici, per cui questo è un traguardo importante ma che purtroppo si presta male alla scalabilità».

Ed è proprio sulla scalabilità che si è concentrata la competizione dal 2023 in poi. Il problema fondamentale è la rumorosità dei qubit, che limita drasticamente la possibilità di aumentare il numero di qubit logici effettivamente utilizzabili. Google nel 2024 ha presentato il processore Willow con 105 qubit: apparentemente un passo indietro dai numeri di IBM, ma in realtà un salto in avanti qualitativo verso sistemi scalabili.

Il 2025 è stato definito dal relatore «un anno fantastico» per questa tecnologia. Microsoft ha introdotto Majorana One con apparentemente solo 8 qubit, ma organizzati in una struttura topologica innovativa che si presta alla scalabilità. Amazon è entrata in gioco con Ocelot, 9 qubit fault tolerant, cioè tolleranti agli errori e alla rumorosità.

Di pochi giorni fa, ha ricordato Baldi, l’annuncio di IBM che è tornata protagonista con due processori rivoluzionari: Nighthawk, con 120 qubit interconnessi tra loro in una struttura di distributed computing quantistico, e Loon, con 112 qubit che incorporano capacità di correzione degli errori. Entrambi progettati specificamente per la scalabilità.

«Quello che era un concetto teorico abbastanza lontano da noi sta diventando sempre più concreto e, come vedete, c’è un’accelerazione negli ultimi anni verso la costruzione di computer quantistici sempre più grandi e sempre più scalabili», ha avvertito il professore.

L’altra faccia: le comunicazioni quantistiche

Sul versante difensivo, le tecnologie di quantum communications offrono la possibilità di trasmissioni punto-punto con garanzie matematico-fisiche di confidenzialità. La Quantum Key Distribution esegue «la trasmissione punto-punto su link ottico in fibra o spazio libero di un’informazione segreta codificata in stati quantistici».

Il teorema di non clonazione garantisce che «se un attaccante tentasse di fare un’intercettazione, nell’eseguire la misura andrebbe a perturbare il fenomeno quantistico e quindi verrebbe deteriorata l’informazione stessa». Questo fornisce una garanzia matematico-fisica di non intercettabilità che va oltre la sicurezza computazionale tradizionale.

Le applicazioni: opportunità e minacce

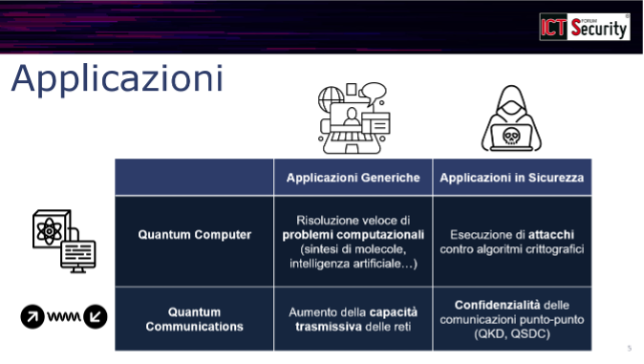

Il quantum computer, ha spiegato l’esperto, avrà applicazioni generiche nel mondo ICT: accelererà la sintesi di molecole, l’addestramento di grandi reti neurali, la soluzione di problemi di ottimizzazione complessi. Le quantum communications aumenteranno la capacità trasmissiva delle reti, con prospettive verso un quantum Internet.

Ma è sul fronte della sicurezza che l’impatto sarà più drammatico. «Il quantum computer, ahimè, ha una forte applicazione in sicurezza dal punto di vista crittoanalitico», ha avvertito il relatore. «Un attaccante dotato di un quantum computer può sovvertire la sicurezza di molti degli algoritmi crittografici asimmetrici che noi oggi utilizziamo».

Le quantum communications, invece, hanno un’applicazione difensiva, garantendo confidenzialità delle comunicazioni punto-punto attraverso tecniche come la Quantum Key Distribution o le Quantum Secure Direct Communications.

La bomba a orologeria: l’impatto sulla crittografia attuale

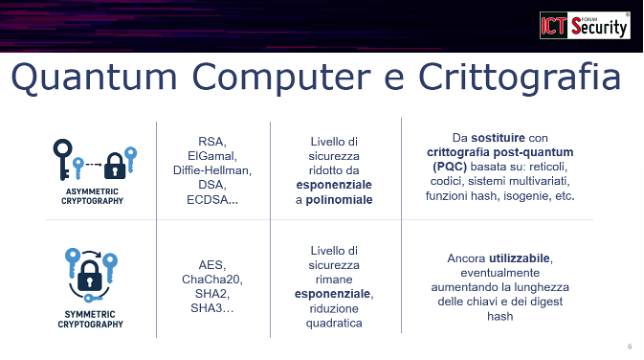

L’impatto del quantum computing sulla crittografia è profondamente asimmetrico. Il professor Baldi ha illustrato come sia necessario distinguere tra due grandi famiglie di cifrari:

I cifrari asimmetrici – quelli che utilizziamo per lo scambio automatico di chiavi, la cifratura asimmetrica, la firma digitale (RSA, ElGamal, DSA, ECDSA, Diffie-Hellman, curve ellittiche) – subiranno un impatto «drammatico». La complessità della soluzione dei problemi matematici su cui si basa la loro sicurezza viene ridotta da esponenziale a polinomiale nella lunghezza dell’input. In termini pratici: «Noi dobbiamo abbandonare gli attuali cifrari asimmetrici che sono vulnerabili al quantum computer».

I cifrari simmetrici – quelli usati per la bulk encryption con chiave precondivisa, come AES, ChaCha20, e le funzioni hash SHA-2, SHA-3 – subiscono un impatto «molto più contenuto». Il livello di sicurezza rimane esponenziale, pur subendo una riduzione quadratica. «Possiamo ancora utilizzare AES, ad esempio, oppure SHA-3, eventualmente adattando la lunghezza delle chiavi e la lunghezza dei digest», ha rassicurato l’esperto.

La risposta: la crittografia post-quantum

La soluzione esiste ed è già in fase avanzata di standardizzazione. La crittografia post-quantum (PQC) utilizza sistemi che non si basano più sui problemi matematici vulnerabili ai computer quantistici, ma su altri problemi: reticoli, codici correttori di errori, sistemi multivariati, isogenie, funzioni hash.

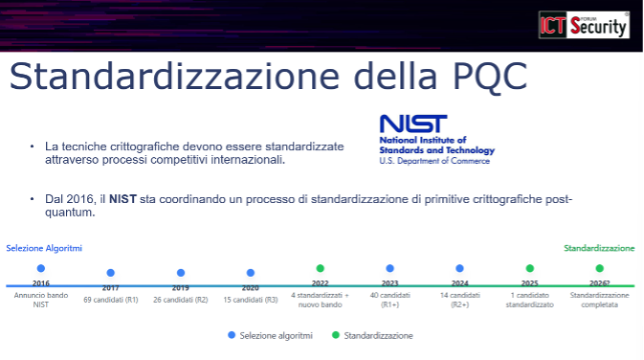

«Le tecniche crittografiche devono essere standardizzate attraverso processi competitivi internazionali», ha sottolineato Baldi. Il NIST (National Institute of Standards and Technology) americano coordina dal 2016 il più importante processo di standardizzazione di primitive crittografiche post-quantum.

Il percorso è stato rigoroso: nel 2017 furono presentati 69 candidati, ridotti a 26 nel 2019, 15 nel 2020, fino a quattro candidati standardizzati nel 2022. Nel frattempo, nel 2022 si decise di riaprire un ulteriore bando per aumentare la diversità negli algoritmi di firma digitale: 40 nuovi candidati raccolti nel 2023, ridotti a 14 nel 2024.

A marzo 2025 è stato aggiunto un algoritmo a quelli standardizzati, e per il 2026 si attende la conclusione del secondo processo di standardizzazione. Gli algoritmi finora standardizzati sono:

- Due algoritmi per lo scambio di chiave (che sostituiranno Diffie-Hellman): ML-KEM e HQC-KEM (quest’ultimo aggiunto a marzo 2025)

- Tre algoritmi per la firma digitale: ML-DSA, FN-DSA e SLH-DSA

Il contributo italiano: LEDAcrypt, CROSS e LESS

Con evidente orgoglio, il professor Baldi ha presentato tre algoritmi che vedono protagonista la ricerca italiana, tutti appartenenti alla famiglia dei sistemi post-quantum basati su codici correttori di errori.

LEDAcrypt (Low-dEnsity parity-check coDe-bAsed cryptographic systems) fornisce una famiglia di algoritmi per lo scambio di chiave e la cifratura asimmetrica. Si basa su un framework introdotto nel 1978 da Robert McEliece, «sostituendo le famiglie di codici con codici più moderni che si chiamano LDPC e MDPC, si ottengono sistemi molto compatti e molto veloci». Sebbene non sia stato standardizzato per questioni parametriche, «la versione 3 è sicura, compatta e veloce».

CROSS (Code and Restricted Object Signature Scheme) e LESS (Linear Equivalence Signature Scheme) sono due algoritmi di firma digitale tuttora in competizione, «gli unici due che sono stati ammessi al secondo round della gara attuale nella famiglia degli algoritmi basati su codici».

CROSS si basa sul problema di decodifica ristretta, «è molto veloce e ottiene delle firme ragionevolmente compatte». LESS si basa sul problema di equivalenza tra codici, «è ragionevolmente veloce ma le firme sono molto compatte».

«Spesso si parla di sovranità digitale, qualche volta in crittografia si parla anche del sospetto di backdoor», ha commentato Baldi. «Ecco, questi sono algoritmi il cui progetto è nato da spunto di ricercatori italiani».

Il dibattito: PQC o QKD?

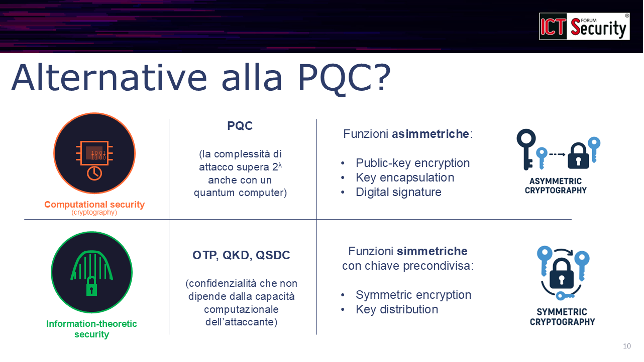

Una domanda legittima che il relatore ha affrontato: esistono alternative alla crittografia post-quantum? La risposta è articolata e richiede di comprendere due paradigmi distinti di sicurezza.

La crittografia post-quantum rientra nel paradigma della sicurezza computazionale (computational security): si richiede che la complessità di un attacco superi un certo valore (2^λ, dove λ è il livello di sicurezza in bit) anche per un attaccante dotato di quantum computer.

Esiste però un altro paradigma, quello della sicurezza information-theoretic, cui rispondono tecniche come il One-Time Pad (usato durante la Seconda Guerra Mondiale per le comunicazioni tra Roosevelt e Churchill), la Quantum Key Distribution e le Quantum Secure Direct Communications. In questo caso «la confidenzialità non dipende dalla capacità computazionale di un attaccante, perché si dimostra in modo matematico».

Il problema, ha spiegato l’esperto, è che questi due paradigmi offrono funzionalità diverse:

- La PQC fornisce funzioni asimmetriche: cifratura asimmetrica, scambio automatico di chiavi, firma digitale

- Le tecniche di sicurezza information-theoretic producono nativamente solo funzioni simmetriche basate su chiave precondivisa: cifratura simmetrica, distribuzione di chiave simmetrica

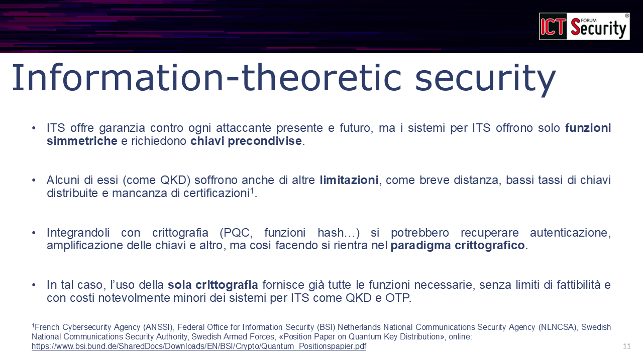

«Allora potremmo chiederci: usiamo information-theoretic security?», ha proseguito Baldi. «Da una parte è vero che offre una garanzia indipendente dalla capacità di calcolo dell’attaccante. Però i sistemi per information-theoretic security offrono solo funzioni simmetriche, che sono quelle meno impattate dal quantum computer, e richiedono delle chiavi precondivise manualmente».

Inoltre, alcuni sistemi come la QKD hanno limitazioni tecniche significative: breve distanza, limitato tasso di chiavi distribuite, mancanza di certificazioni. Il relatore ha citato position paper congiunti rilasciati dalle agenzie di sicurezza nazionali tedesca (BSI), francese (ANSSI), svedese e olandese che «descrivono molto dettagliatamente le limitazioni a cui va incontro la Quantum Key Distribution».

Si potrebbe pensare di adottare un approccio misto, mescolando QKD con PQC e funzioni hash per superare questi limiti e recuperare l’autenticazione automatica. «Però se noi facciamo così, ritorniamo nel paradigma della computational security, che è quello crittografico», ha obiettato il professore. «E allora non ha molto senso questo mescolamento, perché rimanendo nel paradigma crittografico, la sola crittografia post-quantum ci offre già tutte le funzioni necessarie senza limiti di fattibilità, con costi oltretutto notevolmente più bassi».

PQC o QKD: applicabilità a confronto

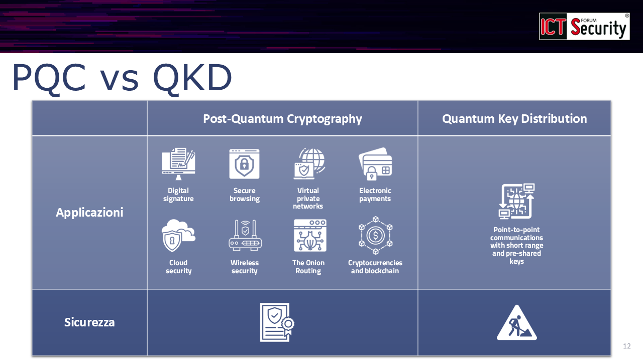

La slide di confronto presentata dal relatore è stata inequivocabile. «Innanzitutto non è giusto contrapporli, perché PQC ci dà funzioni asimmetriche e QKD ci dà solo funzioni simmetriche», ha premesso.

Ma guardando all’applicabilità:

La PQC può essere applicata in tutti gli scenari in cui oggi usiamo crittografia:

- Firma digitale

- Navigazione web sicura

- Reti private virtuali aziendali

- Pagamenti elettronici

- Sicurezza del cloud

- Sicurezza wireless

- Paradigmi futuri e avanzati come The Onion Routing (TOR), blockchain e criptovalute

Esistono già standard ed esistono certificazioni per la PQC.

La QKD, invece, è una tecnologia che «può essere di interesse perché ci dà una confidenzialità matematicamente dimostrabile, ma in alcuni casi di nicchia»:

- Comunicazioni punto-punto su breve distanza

- Con chiavi precondivise

- Senza, per il momento, certificazioni di sicurezza e standard consolidati

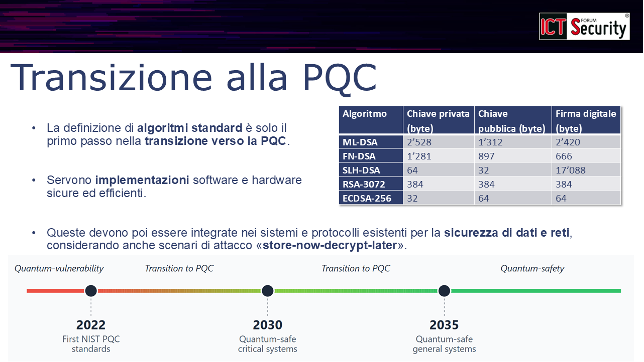

Le sfide della transizione: non basta lo standard

«Attrezziamoci per andare verso la transizione alla post-quantum cryptography», ha esortato Baldi. Ma ha anche avvertito che la standardizzazione degli algoritmi «è il primo passaggio fondamentale per avere una crittografia interoperabile, ma non è l’ultimo passaggio».

Le sfide sono molteplici:

1. Implementazioni sicure ed efficienti

Gli algoritmi devono essere implementati in hardware e software in modo non solo efficiente, ma anche sicuro. «Ci sono attacchi come i side-channel attacks che riguardano non tanto gli algoritmi ma le loro implementazioni», ha spiegato. «È necessario che le implementazioni hardware e software che noi andiamo a utilizzare siano sicure anche contro side-channel attacks, oltre che certificate».

2. Integrazione nei sistemi esistenti

Anche disponendo di algoritmi standard e implementazioni sicure, resta il problema di «prendere questi algoritmi e inserirli nei sistemi che utilizziamo». E qui emerge un problema concreto: le dimensioni delle chiavi e delle firme.

Il relatore ha mostrato una tabella di confronto tra sistemi di firma digitale che ha reso evidente la sfida: ECDSA (basato su curve ellittiche, quantum-vulnerable) ha chiavi e firme piccolissime. I sistemi post-quantum standardizzati – ML-DSA, FN-DSA, SLH-DSA – hanno chiavi pubbliche, chiavi private e firme con dimensioni «che non sono nemmeno lontanamente paragonabili» con quelle dei sistemi classici.

«Bisognerà andare a integrare e studiare come integrare queste nuove primitive crittografiche nei protocolli e nei sistemi che utilizziamo tutti i giorni per la sicurezza dei dati e delle reti», ha sottolineato.

3. L’urgenza: gli attacchi “store-now-decrypt-later”

L’aspetto forse più inquietante riguarda la dimensione temporale della minaccia. «Esistono attacchi di tipo store-now-decrypt-later», ha avvertito l’esperto. «I dati che io scambio oggi sulla mia rete potrebbero essere memorizzati oggi, con il cifrario che io sto usando oggi, per essere attaccati da un attaccante domani, quando l’attaccante avrà il quantum computer».

In altre parole, un attaccante può intercettare e archiviare oggi comunicazioni cifrate con algoritmi classici, in attesa di disporre domani di un quantum computer per decifrarle. Questo vale per dati sensibili, segreti industriali, comunicazioni governative, informazioni mediche: tutto ciò che deve rimanere confidenziale non solo oggi, ma anche tra 5, 10, 15 anni.

«Quindi non è una transizione che possiamo ritardare», ha ammonito Baldi.

La roadmap: dal 2016 al 2035

«Non a caso, sia a livello nazionale che internazionale si stanno delineando delle timeline per la transizione alla crittografia post-quantum», ha concluso il relatore presentando le scadenze che attendono governi, aziende e organizzazioni.

La situazione di partenza è chiara: «Veniamo da un mondo in cui la crittografia è quantum-vulnerable. Quella che stiamo usando oggi per connetterci a Internet è quantum-vulnerable».

La roadmap delineata prevede:

- 2016: il NIST inizia il processo di standardizzazione

- 2022: primi algoritmi standardizzati

- 2030: deadline per la transizione delle infrastrutture critiche. «È comunemente accettato che bisognerà essere riusciti a eseguire la transizione almeno delle infrastrutture critiche» entro questa data

- 2035: completamento della transizione di tutte le infrastrutture digitali

L’obiettivo dichiarato è raggiungere entro il 2035 la cosiddetta quantum safety: «Essere resilienti anche nei confronti di attaccanti dotati di un quantum computer».

Il supporto della ricerca italiana

Prima di concludere, il professor Baldi ha voluto riconoscere il supporto di alcuni progetti di ricerca che sostengono l’attività italiana nella crittografia post-quantum:

- Il programma PE SERICS (SEcurity and RIghts in the CyberSpace), finanziato dal Ministero dell’Università e della Ricerca nell’ambito del PNRR (Piano Nazionale di Ripresa e Resilienza) – Missione 4, componente 2, investimento 1.3 – finanziato dall’Unione Europea – NextGenerationEU

- Il progetto QSAFEIT (Quantum-safe cryptographic tools for the protection of national data and information technology assets), finanziato dal Ministero dell’Università e della Ricerca nell’ambito del Fondo Italiano per le Scienze Applicate (FISA) 2022

Un segnale chiaro che l’Italia sta investendo nella ricerca di frontiera su tecnologie che saranno decisive per la sicurezza nazionale e la sovranità digitale nel prossimo decennio.

Conclusioni

La sfida è lanciata: la transizione alla crittografia post-quantum non è più un’opzione, ma una necessità urgente. Con computer quantistici sempre più potenti all’orizzonte e la minaccia concreta degli attacchi store-now-decrypt-later, governi, aziende e organizzazioni hanno meno di cinque anni per proteggere le proprie infrastrutture critiche. La ricerca italiana, con algoritmi come LEDAcrypt, CROSS e LESS, sta contribuendo attivamente a costruire le difese crittografiche del futuro. Ma come ha avvertito il professor Baldi: il tempo stringe, e ciò che proteggiamo oggi determinerà la sicurezza delle nostre informazioni per i decenni a venire.

Guarda il video dell’intervento completo:

Marco Baldi è professore associato in Telecomunicazioni presso il Dipartimento di Ingegneria dell’Informazione dell’Università Politecnica delle Marche, dove partecipa al Centro di Ricerca e Servizio per la Privacy e la Cybersecurity (CRiSPY). È membro del comitato di gestione del Laboratorio Nazionale di Cybersecurity del CINI e ne coordina il nodo locale presso l’Università Politecnica delle Marche. È socio fondatore e membro del comitato scientifico dell’Associazione Nazionale di crittologia De Componendis Cifris. Svolge attività didattica, di ricerca e progettuale nell’area dell’affidabilità e della sicurezza delle comunicazioni, ed in particolare della crittografia post-quantum. È coautore di oltre 200 articoli scientifici apparsi in riviste, capitoli di libri e atti di conferenze internazionali, un libro e quattro brevetti. È membro di CINI, CNIT, GTTI, IEEE Communications Society, IEEE Information Theory Society e membro senior di IEEE. È stato vicepresidente per il periodo 2021-2023 ed è presidente per il periodo 2024-2025 del capitolo italiano della IEEE Information Theory Society. È coordinatore o membro dei gruppi di lavoro di progetti di ricerca nazionali ed internazionali commissionati da enti pubblici e privati. È co-organizzatore e membro del comitato tecnico di programma di conferenze e workshop internazionali nell’ambito dell’affidabilità e della sicurezza delle comunicazioni. Fa parte del gruppo proponente degli schemi crittografici LEDAcrypt, LESS e CROSS, che hanno partecipato o stanno partecipando al processo di standardizzazione internazionale di schemi crittografici post-quantum coordinato dal NIST. È membro del Quantum Technologies Coordination Group nominato dal Presidente del Consiglio dei Ministri su indicazione del Sottosegretario alla Presidenza del Consiglio con delega all’innovazione tecnologica.