La Governance dell’AI attraverso le norme ISO

Premessa

L’Intelligenza Artificiale (il cui acronimo è IA in italiano e AI in inglese) è una disciplina appartenente al mondo dell’informatica conosciuta tra gli addetti ai lavori da molto tempo. Il termine è stato coniato nel 1956, ma solo negli ultimi anni si è diffuso in maniera massiva grazie all’avanzare dell’innovazione tecnologica nei diversi campi. A differenza degli anni ’50, l’Intelligenza Artificiale al giorno d’oggi può sfruttare la potenza di calcolo quasi illimitata del cloud, così come gli ancora più elevati livelli di efficienza e velocità di calcolo dei Super Computer e/o la condivisione in reti di computer.

Aggiungendo a tutto ciò il costo decrescente dello storage, l’aumento esponenziale dei volumi di dati che si possono usare per addestrare le IA, e la comparsa di piattaforme e framework open source, si ottiene una combinazione straordinariamente potente di tecnologie e capacità.

Tutto questo contribuisce a far diventare l’Intelligenza Artificiale un campo predominante nella realtà di oggigiorno.

Cos’è l’Intelligenza Artificiale?

È difficile definire l’Intelligenza Artificiale, perché a seconda del contesto o delle persone essa può assumere significati diversi.

Non esiste una definizione unica e unanimemente accettata di “intelligenza artificiale”.

Una delle tante definizioni dice che: l’Intelligenza Artificiale è un insieme di tecnologie differenti che interagiscono per consentire a dispositivi e/o apparecchiature di percepire, comprendere, agire e apprendere con livelli di intelligenza simili a quelli umani.

Pertanto tecnologie come il machine learning e l’elaborazione del linguaggio naturale rientrano tutte nell’ambito dell’Intelligenza Artificiale. Ciascuna di esse si sta evolvendo lungo il proprio percorso e, quando applicate in combinazione con dati, analytics e automazione, possono aiutare le aziende a raggiungere i propri obiettivi, sia che si tratti di migliorare il servizio dei clienti o di ottimizzare la supply chain.

L’intelligenza artificiale in generale è più simile a ciò che si vede nei film di fantascienza, dove apparecchiature dotate di “sensi” emulano l’intelligenza umana, pensando in modo strategico, astratto e creativo, con la capacità di gestire una serie di compiti complessi. Sebbene le macchine possano svolgere alcune attività meglio degli esseri umani (per esempio l’elaborazione dei dati), questa visione pienamente realizzata dell’Intelligenza Artificiale generale nella realtà non esiste ancora. Ecco perché la collaborazione uomo-macchina è cruciale nel mondo di oggi, ne consegue pertanto che l’Intelligenza Artificiale rimane un’estensione delle capacità umane, non un sostituto.

È del 21 aprile 2021 la presentazione, da parte della Commissione europea, di una proposta di regolamento UE sull’Intelligenza artificiale che, di fatto, istituisce un quadro di riferimento volto a normare il mercato dell’Unione Europea su questa attuale e delicata materia. Con la proposta “Regolamento del Parlamento europeo e del Consiglio che stabilisce norme armonizzate in materia di intelligenza artificiale e che modifica alcuni atti legislativi dell’Unione” la Commissione europea punta l’attenzione sull’interrelazione tra l’utilizzo di strumenti di IA nella nostra realtà quotidiana e tutela dei dati personali, sottolineando i limiti da dover imporre per assicurare un corretto uso di grandi quantitativi di informazioni (per lo più dati personali) quale premessa necessaria per un tale inevitabile processo di sviluppo.

Questi gli obiettivi che chiaramente emergono dalla Proposta di Regolamento UE sull’Intelligenza artificiale:

- assicurare che i sistemi di IA immessi sul mercato dell’Unione Europea e utilizzati siano sicuri e rispettino la normativa vigente in materia di diritti fondamentali e i valori dell’Unione;

- assicurare la certezza del diritto per facilitare gli investimenti e l’innovazione nell’IA;

- migliorare la governance e l’applicazione effettiva della normativa esistente in materia di diritti fondamentali e requisiti di sicurezza applicabili ai sistemi di IA;

- facilitare lo sviluppo di un mercato unico per applicazioni di IA lecite, sicure e affidabili nonché prevenire la frammentazione del mercato

Anche l’International Organization for Standardization (più conosciuta come ISO) tramite il comitato ISO/IEC JTC 1/SC 42 Artificial Intelligence, non da meno ha in cantiere una nuova norma la ISO/IEC 42001 Information Technology – Artificial intelligence – Management system un nuovo Sistema di Gestione sull’Intelligenza Artificiale.

Governance dell’IA

La proposta di Regolamento da parte della UE sull’Intelligenza Artificiale del 21 aprile 2021 e la draft opinion del 02 marzo 2022, introducono in maniera molto forte i concetti di rischio, di sistema e di governance.

Il sistema AI è quindi considerato attraverso un approccio olistico ed integrato.

Alcuni degli articoli presenti, che vengono anche richiamati negli allegati VI e VII, introducono in maniera chiara il concetto di sistema e del suo controllo.

L’art. 9 (con gli artt. 11 e 13) pone il focus su un sistema di gestione dei rischi, in particolare riportando l’attenzione sugli incidenti (art- 62). Tale sistema di gestione richiama sia modelli che metodologie note, che contemplano il concetto di sistema, e che possono in qualche modo essere d’aiuto integrandosi con altri framework sono ad esempio: la ISO 31000, il CSF NIST e il NIST 800-53, la ISO 27005 e la ISO 22301 della continuità operativa.

La gestione dei rischi diventa quindi una forzante per guidare il sistema AI, attraverso metodologie e prassi consolidate.

L’art. 12 richiama alcuni concetti fondamentali della ISO 27001 e del CSF NIST cioè la registrazione e la gestione degli eventi (log) che permettono il monitoraggio, la gestione del loro ciclo di vita dei rischi e la gestione della tracciabilità.

L’art. 15 tratta gli argomenti tipici della cybersecurity, della security by design comprese ad esempio: le metriche, la resilienza, la gestione dei back up.

L’art 17, invece richiama proprio il concetto di Sistema di Gestione della Qualità. Nel documento Opinion Draft viene richiesta la cancellazione dell’obbligatorietà per le società che trattano AI di dover possedere un sistema certificato di Qualità. (“Richiedere ad ogni fornitore di stabilire un sistema di gestione della qualità per un sistema ad alto rischio è sproporzionato e ingiustificato. Creerebbe enormi costi e oneri amministrativi. Allo stesso tempo, non ha valore aggiunto in quanto la maggior parte dei suoi elementi sono già o possono almeno essere inclusi nella valutazione del rischio di cui all’articolo 9. Inoltre, molti sistemi di intelligenza artificiale rientrano già nei sistemi di gestione della qualità esistente, come quelli definiti dalla ISO 9001. Se l’UE vuole promuovere l’innovazione nell’IA, in particolare da parte delle PMI e delle start-up europee, non deve sovraccaricarli di obblighi inutili”).

Se è pur vero che l’implementazione di un sistema di gestione della Qualità comporta degli oneri, è anche vero che può portare (se fatto bene) enormi benefici sia all’organizzazione che agli utenti/Clienti.

Non solo proprio collegandosi agli allegati, è fondamentale introdurre il concetto di controllo e misura (assessment) richiamato dalla norma ISO 19011 e dal controllo di conformità della ISO 37301 (artt. 19 e 43).

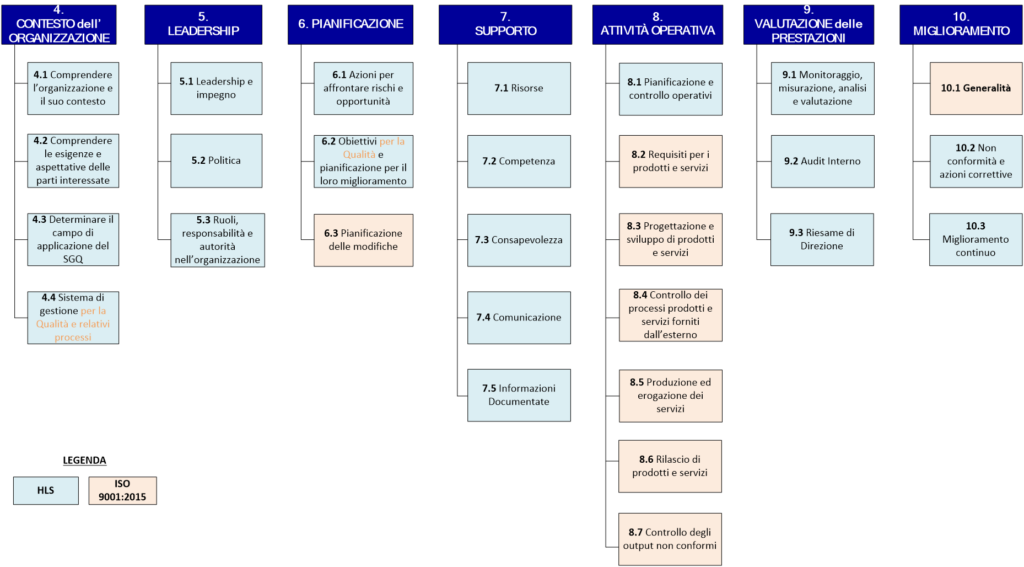

La norma che definisce un sistema di gestione per la qualità (ISO 9001) è la norma che ha guidato l’introduzione della struttura HLS (Hight Level Structure) comune a tutte le norme ISO certificabili compresa la norma ISO 27001.

Essa è suddivisa in 7 capitoli dove sono presenti i requisiti che il sistema deve soddisfare.

Viene riportata nella figura sottostante l’HLS della norma ISO 9001. (Fonte: I quaderni della Qualità «Struttura di Alto Livello e ISO 9001:2015» – UNI 2015)

Tale suddivisione: 4 Contesto, 5 Leadership, 6 Pianificazione, 7 Supporto, 8 Attività Operative, 9 Monitoraggio e 10 Miglioramento (attraverso il concetto di Azioni Correttive dell’art. 21), permette il soddisfacimento dei requisiti elencati nell’art. 17, quali ad esempio: la redazione e diffusione delle Policy, delle procedure la realizzazione di test e di assessment, la gestione degli incidenti, la gestione delle risorse, la gestione della comunicazione, il ciclo di vita dei dati.

Per semplicità riportiamo alcune considerazioni sui 7 capitoli individuati sopra.

Contesto: riguarda la conoscenza organizzativa e si suddivide in contesto esterno ed interno. In particolare per il contesto esterno: l’organizzazione deve individuare i fattori che influenzano il sistema di gestione, i requisiti (cosa vogliono) le parti interessate, i clienti, i fornitori, il contesto fisico e ambientale, quello sociale, quello normativo e quello tecnologico. Per il contesto interno abbiamo: l’organizzazione, le risorse, i processi, la governance, il contesto fisico e quello logico (infrastrutture).

Leadership: l’organizzazione deve impegnarsi a dimostrare la sua leadership attraverso la governance, la redazione di policy, la sensibilizzazione delle persone, la definizione organizzativa (ruoli e responsabilità), l’attribuzione delle risorse e promuovendo il miglioramento continuo.

Pianificazione: il capitolo relativo alla pianificazione si suddivide in due parti. La prima è dedicata all’analisi dei rischi, quindi alla metodologia dei rischi, all’individuazione e al trattamento. La seconda invece richiede la definizione precisa degli obiettivi organizzativi e specifici.

Supporto: per poter seguire le policy declinate prima, raggiungere gli obiettivi è necessario che l’organizzazione definisca e attribuisca le corrette risorse. Questo implica non solo le risorse economiche, finanziarie, strutturali ma anche le risorse umane attraverso la competenza (formazione), la consapevolezza dei rischi e delle attività. Essendo un sistema di gestione ecco che la parte relativa alla gestione documentale è fondamentale anche in ottica di accountability, inoltre è opportuno definire un processo di comunicazione relativo a tutti gli items di sistema: obiettivi, documenti, politiche, indicatori, dati, etc.

Attività operative: questo è il capitolo più “libero” della norma, in quanto si riferisce proprio alle attività/processi tipici dell’organizzazione. Le attività devono essere quindi pianificate e controllate, riprende l’analisi dei rischi ripotandola ai singoli processi, introduce gli indicatori e le attività di dettaglio (progettazione, erogazione del servizio e realizzazione prodotto, i controlli, il post vendita).

Valutazione delle prestazioni: qui vengono definiti i sistemi di misura (chi, come, quando, con cosa, valutazione) sui processi e sui prodotti/servizi e sul sistema di gestione attraverso gli audit interni ed il riesame della direzione.

Miglioramento: nell’ultimo capito si affrontano le tematiche relative alle non conformità del sistema, all’implementazione delle eventuali azioni correttive ed al processo del miglioramento continuo che deve essere integrato in ogni attività aziendale.

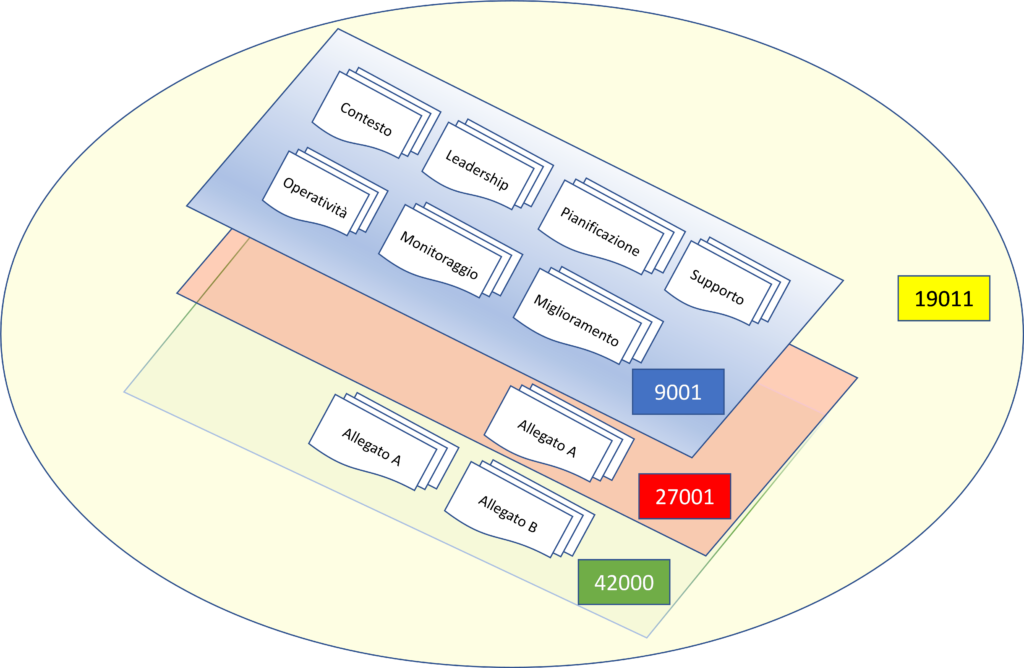

In quest’ottica della struttura HLS si inserisce anche la norma ISO 42000 dedicata alla governance dell’Intelligenza Artificiale della quale riportiamo l’HLS.

4 Contesto dell’organizzazione

4.1 Comprendere l’organizzazione e il suo contesto

4.2 Comprendere le esigenze e le aspettative delle parti interessate

4.3 Determinazione dell’ambito di applicazione del sistema di gestione dell’IA

4.4 Sistema di gestione AI

5 Leadership

5.1 Leadership e impegno

5.2 Politica

5.3 Ruoli, responsabilità e autorità

6 Pianificazione

6.1 Azioni per affrontare rischi e opportunità

6.1.1 Generalità

6.1.2 Valutazione del rischio dell’IA

6.1.3 Trattamento del rischio di IA

6.1.4 Valutazione d’impatto del sistema di IA

6.2 Obiettivi dell’IA e pianificazione per raggiungerli

6.3 Pianificazione delle modifiche

7 Supporto

7.1 Risorse

7.2 Competenza

7.3 Consapevolezza

7.4 Comunicazione

7.5 Informazioni documentate

7.5.1 Generalità

7.5.2 Creazione e aggiornamento di informazioni documentate

7.5.3 Controllo delle informazioni documentate

8 Funzionamento

8.1 Pianificazione e controllo operativo

9 Valutazione delle prestazioni

9.1 Monitoraggio, misurazione, analisi e valutazione

9.2 Audit interno

9.2.1 Generalità

9.2.2 Programma di audit interno

9.3 Riesame della direzione

9.3.1 Generalità

9.3.2 Input di revisione della direzione

9.3.3 Risultati del riesame della direzione

10 Miglioramento

10.1 Miglioramento continuo

10.2 Non conformità e azioni correttive

La norma si compone di un corpo centrale (HLS) e due appendici. La prima riguarda una serie di controlli/contromisure dedicate, ma non esaustive, all’IA. Questi controlli hanno la stessa forma e ispirazione della ISO 27001. I controlli vengono elencati riportando l’obiettivo generale, il controllo dedicato ed una linea guida all’implementazione dello stesso.

La seconda appendice tratta invece i possibili obiettivi, nella gestione dei rischi, organizzativi legati all’IA

Riportiamo l’elenco dei controlli relativi all’Allegato A:

A.1 Generalità

A.2 Politiche per IA

A.2.1 Generale

Obiettivo: Fornire direzione di gestione e supporto per l’IA in conformità con i requisiti aziendali e requisiti legali applicabili (ad es. legislazione e contratti).

A.2.2 Politica IA

Controllo: La politica di IA stabilita in base ai requisiti della Clausola 5.2 dovrebbe guidare l’organizzazione approccio alla gestione dei propri obiettivi legati all’IA.

A.2.3 Allineamento con altre politiche organizzative

Controllo: L’organizzazione dovrebbe determinare dove altre politiche possono essere influenzate o applicate al suo ruolo con rispetto ai sistemi di intelligenza artificiale.

A.2.4 Riesame della politica in materia di IA

Controllo: La politica in materia di IA dovrebbe essere riesaminata a intervalli pianificati o se si verificano cambiamenti significativi per garantire la sua idoneità, adeguatezza ed efficacia continue.

A.3 Organizzazione interna

Obiettivo: Creare il quadro di gestione attraverso il quale i controlli per l’IA possono essere istituiti e resi operativi.

A.3.1 Generale

Obiettivo: Creare il quadro di gestione attraverso il quale i controlli per l’IA possono essere istituiti e operazione in un’organizzazione.

A.3.2 AI ruoli e responsabilità

Controllo: I ruoli e le responsabilità per l’IA dovrebbero essere definiti e assegnati in base alle esigenze dell’organizzazione.

A.3.3 Sistema di comunicazione

Controllo: L’organizzazione dovrebbe definire e mettere in atto un processo per riportare le segnalazioni ed il ruolo dell’organizzazione rispetto a un sistema di intelligenza artificiale durante tutto il suo ciclo di vita.

A.4 Risorse per AI

A.4.1 Generale

Obiettivo: Garantire che l’organizzazione tenga conto delle risorse (inclusi componenti e risorse) del sistema AI al fine di comprendere e affrontare appieno rischi e impatti.

A.4.2 Documentazione delle risorse

Controllo: L’organizzazione dovrebbe identificare e documentare tutte le risorse pertinenti necessarie per il ciclo di vita del sistema e delle sue fasi di IA e altre attività correlate all’IA rilevanti per l’organizzazione.

A.4.3 Risorse di dati

Controllo: Come parte dell’identificazione delle risorse, l’organizzazione dovrebbe documentare le informazioni sui tipi di dati risorse utilizzate per il sistema di intelligenza artificiale.

A.4.4 Risorse di strumenti

Controllo: Come parte dell’identificazione delle risorse, l’organizzazione dovrebbe documentare le informazioni sui tipi di risorse di computing utilizzate per il sistema di intelligenza artificiale.

A.4.5 Risorse di sistema e di calcolo

Controllo: Come parte dell’identificazione delle risorse, l’organizzazione dovrebbe documentare le informazioni sui tipi di risorse del sistema utilizzate per il sistema di intelligenza artificiale (dove e quali).

A.4.6 Risorse umane

Controllo: Nell’ambito dell’identificazione delle risorse, l’organizzazione dovrebbe documentare le informazioni sui tipi di risorse umane utilizzate per il sistema di intelligenza artificiale.

A.5 Valutazione degli impatti dei sistemi di IA

A.5.1 Generale

Obiettivo: Valutare gli impatti del sistema per le parti interessate del sistema di intelligenza artificiale durante tutto il suo ciclo di vita.

A.5.2 Processo di valutazione d’impatto del sistema IA

Controllo: L’organizzazione dovrebbe attuare, ove necessario, un processo di valutazione d’impatto (vedi GDPR) del sistema.

A.5.3 Documentazione delle valutazioni d’impatto dei sistemi di IA

Controllo: L’organizzazione dovrebbe documentare i risultati delle valutazioni d’impatto del sistema di IA e conservare i risultati per un periodo di definizioni.

A.5.4 Valutazione dell’impatto su individui e gruppi di individui

Controllo: L’organizzazione dovrebbe valutare e documentare i potenziali impatti dei sistemi di IA su individui o gruppi di individui durante tutto il ciclo di vita del sistema (ad esempio: parzialità ed equità; trasparenza e spiegabilità; privacy; sicurezza e salute; finanza; Diritti umani).

A.5.5 Valutazione degli impatti sociali

Controllo: L’organizzazione dovrebbe valutare e documentare i potenziali impatti sociali connessi al suo utilizzo, fornitura e sviluppo di sistemi di IA (ad esempio: l’ambiente (anche attraverso l’impatto sul consumo energetico e sull’efficienza energetica); l’economia; processi democratici; salute e sicurezza della società in generale; norme, tradizioni, cultura e valori).

A.5.6 Valutazione delle opportunità

Controllo: L’organizzazione dovrebbe contemplare e documentare le opportunità derivanti dall’utilizzo dei sistemi AI durante tutto il loro ciclo di vita.

A.6 Ciclo di vita dello sviluppo del sistema IA

A.6.1 Guida alla gestione per lo sviluppo di sistemi di IA

Obiettivo: Garantire che l’organizzazione implementi processi e obiettivi per la progettazione responsabile e sviluppo di sistemi di IA.

A.6.1.1 Obiettivi per lo sviluppo responsabile del sistema di IA

Controllo: L’organizzazione dovrebbe identificare e documentare gli obiettivi per guidare lo sviluppo di un’IA responsabile e integrare tali obiettivi in tutte le fasi del ciclo di vita dello sviluppo (ad esempio: equità; responsabilità; trasparenza; affidabilità; sicurezza; privacy e sicurezza; accessibilità, etc.).

A.6.1.2 Processi per lo sviluppo responsabile della progettazione di sistemi di IA

Controllo: L’organizzazione deve definire, documentare e implementare i passaggi necessari per l’applicazione, provisioning e sviluppo di sistemi di IA attraverso il loro ciclo di vita (ad esempio: fasi del ciclo di vita del processo di sviluppo; requisiti di prova; requisiti in materia di controllo umano; in quali fasi dovrebbero essere effettuate le valutazioni d’impatto; formazione delle aspettative e delle norme in materia di dati (ad esempio quali dati possono essere utilizzati, fornitori di dati approvati e etichettatura); competenze richieste o formazione per gli sviluppatori di sistemi di IA o entrambi; criteri di rilascio; le approvazioni e le approvazioni necessarie nelle varie fasi; controllo delle modifiche; coinvolgimento delle parti interessate).

A.6.2 Fasi di sviluppo del sistema IA

Obiettivo: Definire le regole e i requisiti per ogni fase o fase del processo di sviluppo del sistema di intelligenza artificiale.

A.6.2.1 Requisiti e specifiche di sistema IA

Controllo: L’organizzazione deve specificare e documentare i requisiti per i nuovi sistemi di intelligenza artificiale o i miglioramenti per sistemi esistenti.

A.6.2.2 Progettazione e sviluppo di sistemi di IA

Controllo: L’organizzazione deve documentare la progettazione e lo sviluppo del sistema di intelligenza artificiale in base all’organizzazione obiettivi, requisiti documentati e criteri di specificazione (ad esempio: approccio all’apprendimento automatico (supervisionato o non supervisionato); algoritmi utilizzati; come verrà addestrato il modello e con quali dati; valutazione e perfezionamento dei modelli; componenti hardware e software; codice; etc.).

A.6.2.3 Verifica e convalida del sistema IA

Controllo: L’organizzazione dovrebbe definire e documentare le misure di verifica e convalida per il sistema di IA e specificare i criteri per il loro utilizzo (ad esempio: metodologie e strumenti di prova; dati di convalida della selezione e dati di prova; requisiti dei criteri di rilascio).

A.6.2.4 Distribuzione del sistema IA

Controllo: L’organizzazione deve documentare un piano di distribuzione, inclusi i componenti che verranno distribuiti in quali ambienti e garantire che tutti i requisiti siano soddisfatti prima della distribuzione.

A.6.2.5 Funzionamento e monitoraggio del sistema IA

Controllo: L’organizzazione dovrebbe definire e documentare gli elementi necessari per il funzionamento in corso del sistema IA. Come minimo questo dovrebbe includere il monitoraggio del sistema e delle prestazioni, riparazioni, aggiornamenti e supporti.

A.7 Dati per sistemi di IA

Obiettivo: Garantire che l’organizzazione comprenda il ruolo e l’impatto dei dati nei sistemi di intelligenza artificiale nell’applicazione e lo sviluppo, la fornitura o l’uso di sistemi di intelligenza artificiale durante il loro cicli di vita.

A.7.1 Generale

A.7.2 Dati per lo sviluppo e il miglioramento del sistema IA

Controllo: L’organizzazione dovrebbe definire, documentare e implementare processi di gestione dei dati relativi allo sviluppo di sistemi di IA (ad esempio: implicazioni per la vita privata e la sicurezza dovute all’uso di dati, alcuni dei quali possono essere di natura sensibile; minacce alla sicurezza e alla protezione che possono derivare dallo sviluppo di sistemi di IA dipendenti dai dati; aspetti di trasparenza e spiegabilità, compresa la provenienza dei dati e la capacità di fornire una spiegazione di come i dati vengono utilizzati per determinare l’output di un sistema di intelligenza artificiale se il sistema richiede trasparenza e spiegabilità; rappresentatività dei dati di formazione rispetto al dominio operativo di utilizzo; l’esattezza e l’integrità dei dati).

A.7.3 Acquisizione dei dati

Controllo: L’organizzazione dovrebbe determinare e documentare i dettagli sull’acquisizione e la selezione dei dati utilizzati nei sistemi di intelligenza artificiale (ad esempio: categorie di dati necessari per il sistema di IA; quantità di dati necessari; fonti di dati (tipo: dati interni, acquistati, condivisi, aperti); caratteristiche della fonte di dati (statica, trasmessa, raccolta, generati automaticamente); dati demografici e caratteristiche dell’interessato; trattamento preventivo dei dati (usi precedenti, conformità alla privacy e sicurezza requisiti); provenienza dei dati).

A.7.4 Qualità dei dati per i sistemi di IA

Controllo: L’organizzazione deve definire e documentare i requisiti per la qualità dei dati (definizione: il grado in cui il le caratteristiche dei dati soddisfano le esigenze dichiarate e implicite quando vengono utilizzate in condizioni specificate).

A.7.5 Provenienza dei dati

Controllo: L’organizzazione dovrebbe definire e documentare un processo per verificare e registrare la provenienza di dati utilizzati nei suoi sistemi di intelligenza artificiale durante i cicli di vita dei dati e del sistema di intelligenza artificiale.

A.7.6 Pretrattamento dei dati

Controllo: L’organizzazione dovrebbe definire e documentare le proprie esigenze e approcci alla pre-elaborazione dei dati (ad esempio: esplorazione statistica dei dati (distribuzione, media, mediana, deviazione standard, intervallo); pulizia (cioè correzione delle voci, gestione delle voci mancanti); imputazione (ossia metodi di compilazione delle voci mancanti); normalizzazione; ridimensionamento; etichettatura della/e variabile/e bersaglio/i; codifica (ad esempio conversione di variabili categoriche in numeri)).

A.8 Informazioni per gli utenti dei sistemi di IA

A.8.1Generale

Obiettivo: Garantire che gli utenti del sistema di intelligenza artificiale dispongano delle informazioni necessarie per comprendere e valutare i loro rischi e impatti (potenziali danni e benefici).

A.8.2 Documentazione di sistema per gli utenti

Controllo: L’organizzazione deve determinare e fornire la documentazione necessaria agli utenti del sistema.

A.8.3 Comprensione delle informazioni fornite

Controllo: Le informazioni fornite agli utenti del sistema di IA dovrebbero essere chiare e comprensibili, anche per i non utenti tecnici.

A.8.4 Relazione esterna

Controllo: L’organizzazione deve fornire funzionalità per la segnalazione degli impatti negativi del sistema.

A.9 Utilizzo di sistemi di IA

A.9.1 Generale

Obiettivo: Garantire che l’organizzazione utilizzi l’intelligenza artificiale in modo responsabile e secondo le politiche organizzative.

A.9.2 Processi per un uso responsabile dell’IA

Controllo: L’organizzazione dovrebbe definire e documentare i processi dell’uso responsabile dei sistemi di intelligenza artificiale (esempio: approvazioni richieste; costi, anche per il monitoraggio e la manutenzione continui; requisiti di approvvigionamento approvati; requisiti legali applicabili all’organizzazione).

A.9.3 Obiettivi per un uso responsabile dell’IA

Controllo: L’organizzazione dovrebbe identificare e documentare gli obiettivi per guidare l’uso responsabile dei sistemi di intelligenza artificiale (ad esempio: equità; responsabilità; trasparenza; affidabilità; sicurezza; privacy e sicurezza; accessibilità, etc.).

A.10 Rapporti tra terze parti

A.10.1 Generalità

Obiettivo: Garantire che, quando terze parti sono coinvolte in qualsiasi fase del ciclo di vita del sistema di intelligenza artificiale, l’organizzazione comprende le proprie responsabilità e rimane responsabile di queste, pur essendo in grado di valutare e mitigare il rischio di fare affidamento su terzi per le responsabilità loro assegnate.

A.10.2 Attribuzione delle responsabilità

Controllo: L’organizzazione dovrebbe garantire che le responsabilità all’interno del ciclo di vita del proprio sistema di intelligenza artificiale siano assegnate tra l’organizzazione, i suoi partner, fornitori, clienti e terze parti.

A.10.3 Fornitori

Controllo: L’organizzazione dovrebbe garantire che i suoi fornitori si impegnino ad attuare i controlli appropriati del presente allegato.

A.11 Sicurezza delle informazioni

A.11.1 Generale

Obiettivo: Garantire che i sistemi di intelligenza artificiale siano sicuri e utilizzati in modo sicuro.

A.11.2 Politica di sicurezza delle informazioni

Controllo: I criteri di sicurezza delle informazioni dell’organizzazione devono considerare le esigenze di sicurezza delle informazioni di Sistemi di IA durante l’intero ciclo di vita del sistema di IA in quanto rilevanti per il loro ruolo e in conformità con queste politiche.

A.11.3 Misure di sicurezza delle informazioni

Controllo: Dovrebbero essere definite nuove misure di sicurezza delle informazioni e le misure esistenti dovrebbero essere adattate come necessario per affrontare le minacce alla sicurezza delle informazioni specifiche dell’IA.

Riportiamo anche l’Allegato B con i possibili obiettivi organizzativi, legati all’IA, nella gestione dei rischi:

B.1 Generalità

Il presente allegato delinea i potenziali obiettivi organizzativi che possono essere presi in considerazione dall’organizzazione quando gestione dei rischi. Il presente allegato non intende essere esaustivo o applicabile a tutte le organizzazioni. Le l’organizzazione dovrebbe determinare gli obiettivi che sono rilevanti per loro. Informazioni più dettagliate su questi obiettivi e la loro relazione con la gestione del rischio possono essere trovati in ISO/IEC CD 23894. La valutazione dei sistemi di IA, inizialmente, regolarmente e quando giustificata, fornisce prove per la valutazione di un sistema IA sistema contro obiettivo organizzativo.

B.2 Correttezza

L’applicazione inappropriata di sistemi di IA per il processo decisionale automatizzato può essere ingiusta per specifici persone o gruppi di persone.

B.3 Sicurezza

Nel contesto dell’IA e in particolare per quanto riguarda i sistemi di IA basati su approcci ML, diverse nuove i problemi di sicurezza dovrebbero essere considerati al di là dei classici problemi di sicurezza delle informazioni e del sistema.

B.4 Safety

La sicurezza si riferisce all’aspettativa che un sistema non conduca, in condizioni definite, a uno stato in cui

la vita umana, la salute, la proprietà o l’ambiente sono in pericolo.

B.5 Tutela della privacy

L’uso improprio o la divulgazione di dati personali e sensibili (ad es. cartelle cliniche) può avere effetti dannosi su interessati. Pertanto, la protezione della privacy è diventata una delle principali preoccupazioni nell’analisi dei big data e nell’intelligenza artificiale.

B.6 Robustezza

Nell’IA, le proprietà di robustezza dimostrano la capacità (o l’incapacità) del sistema di avere comparabili prestazioni su nuovi dati come sui dati su cui è stato addestrato o sui dati delle operazioni tipiche.

B.7 Trasparenza e spiegabilità

La trasparenza si riferisce sia alle caratteristiche di un’organizzazione che gestisce sistemi di IA sia a quelle dei sistemi stessi. La spiegabilità si riferisce alle spiegazioni dei processi rilevanti per lo sviluppo, implementazione e utilizzo di un sistema di IA.

Come si può notare la ISO 42000, permette di implementare un sistema di gestione relativo alla governance dell’intelligenza artificiale comprendendo e riassumendo altre norme ISO di settore quali Qualità, Sicurezza delle Informazioni e Continuità Operativa.

L’applicazione della ISO 42000 aiuta quindi l’organizzazione a gestire e a controllare i dati (secondo IDC nel 2018 sono stati gestiti 18 zettabyte che potranno diventare 175 nel 2025), i processi sia interni che esterni relativi all’erogazione di un servizio o alla realizzazione di un prodotto AI garantendone anche l’accountability e la conformità.

Inoltre un’applicazione rigorosa del sistema permette il controllo, attraverso degli indicatori specifici, dei principi di AI:

- Dignità e supervisione umana;

- Robustezza e sicurezza;

- Privacy e governance dei dati;

- Trasparenza;

- Diversità, non discriminazione ed equità;

- Benessere sociale e ambientale;

- Accountability.

e dei processi, dei flussi, il ciclo di vita, la correttezza dei dati, l’analisi dei bias, ruoli e responsabilità, etc.

Permette anche dei controlli/contromisure relative ai rischi AI:

- Perdita di autonomia personale

- Responsabilità per i danni causati dai sistemi di IA

- Rischio di errori e manipolazione dell’IA

- Manipolazione, sorveglianza e comportamento illecito

- Perdita della privacy

- Mancanza di trasparenza dell’IA

- Perdita degli aspetti umani nelle relazioni sociali e mancanza di protezione della vita umana e della dignità umana

- Restrizione della pluralità delle opinioni e della concorrenza

- Perdita dei posti di lavoro

Conclusioni

L’interesse dimostrato sia con la proposta di Regolamento da parte della UE che della predisposizione di una norma da parte dell’ISO per proporre dei requisiti per l’evoluzione dell’Intelligenza Artificiale sta a dimostrare una vera e propria attenzione per questa disciplina.

Per quanto ogni giorno milioni di persone tentino fiduciosamente di svelare i numerosi segreti che l’Intelligenza Artificiale nasconde, non si è ancora in grado di affermare con certezza quale sia il futuro che ci attende: alla luce delle conoscenze attuali, l’Intelligenza Artificiale potrebbe rivelarsi la più importante disciplina/tecnologia mai creata, ma, allo stesso modo, potrebbe rappresentare di contro una delle gravi minacce che l’umanità abbia finora conosciuto.

Articolo a cura di Stefano Gorla e Attilio Rampazzo