Cognitive Security (COGSEC)

La disinformazione è una delle questioni più critiche del nostro tempo: riguarda l’influenza online e offline su scala globale, colpendo sia i singoli individui sia le masse. Le operazioni nell’ambiente dell’informazione sono condotte nell’ambito della sicurezza cognitiva (COGSEC).

Attraverso Internet e i social media la manipolazione della nostra percezione del mondo avviene su scale di tempo, spazio e intenzionalità prima inimmaginabili: questa è la fonte di una delle più grandi vulnerabilità che dobbiamo imparare a gestire.

La COGSEC è la disciplina che si occupa dello studio dei pericoli sociologici e politici legati all’esposizione di massivi flussi di informazioni dissonanti, che possono contribuire all’aumento di atteggiamenti ostili nelle popolazioni, al declino della coesione sociale, della fiducia istituzionale, a ridurre l’efficacia della produzione della ricerca scientifica e l’affidabilità delle fonti in generale; a tale scopo studia il comportamento degli utenti e i modelli di diffusione o interazione con i contenuti ingannevoli.

Sebbene emerga dall’ingegneria sociale e dalle discussioni sull’inganno sociale nello spazio della sicurezza informatica, se ne distingue sotto diversi aspetti.

La COGSEC non va confusa con la Cognitive Cyber Security, che invece si occupa dell’applicazione delle tecnologie e dei metodi delle scienze cognitive – tra le quali il cognitive computing – per la protezione dello spazio cibernetico, attraverso l’applicazione di tecnologie di Intelligenza Artificiale modellate sui processi del pensiero umano al fine di rilevare le minacce alla sicurezza dei sistemi informatici.

Mentre l’attenzione della sicurezza informatica è rivolta all’influenza di pochi individui, focalizzandosi sull’inganno come mezzo per compromettere i sistemi informatici, la COGSEC si concentra sullo sfruttamento dei pregiudizi cognitivi in grandi gruppi pubblici, quindi sull’influenza sociale come fine.

LO SCENARIO GENERALE

“L’obiettività è un mito che ci viene proposto e imposto”, affermava qualche anno fa Dmitry Konstantinovich Kiselyov, presentatore televisivo e propagandista russo, noto come “il portavoce di Putin” nonché a capo di Rossiya Segodnya, un gruppo mediatico controllato dallo Stato.

La Russia, come altri Stati-nazione, sfrutta queste vulnerabilità per la produzione e la diffusione dell’informazione, per sviluppare quella che è stata definita “guerra cognitiva”.

Contenuti ingannevoli, fuorvianti, falsificati o fabbricati ad arte vengono regolarmente creati e diffusi online con l’intento di creare confusione e ampliare le divisioni politiche-sociali, o di commettere crimini.

L’elaborazione delle informazioni, con l’evolversi della tecnologia, è diventata sempre più sofisticata: abbiamo già assistito al passaggio dal predominio del testo a quello delle immagini e dei video e, negli ultimi tempi, stiamo assistendo all’arrivo di un’informazione multimediale “sintetica” grazie all’utilizzo di tecnologie come quella dei deepfake. Nell’ambito della COGSEC, gli attacchi basati su deepfake sono diventati tra le principali e più pericolose minacce da affrontare nell’attuale contesto storico e ancor più nel prossimo futuro.

Il risvolto psicologico è proprio il mancato riconoscimento tra ciò che è vero e ciò che è falso; i deepfake si possono definire come “true lies” (“bugie vere”), in grado di mettere in crisi la fiducia verso l’Altro e contestualmente aumentare la frammentarietà del Sé.

Allo stesso tempo il costo della tecnologia è in costante calo, il che consente a più attori di entrare in scena. La capacità di influenzare le menti è stata “democratizzata”, poiché qualsiasi individuo o gruppo può comunicare e influenzare un gran numero di persone online (si pensi ad es. agli “influencer” sui social media).

L’associazione tra tecnologie della comunicazione ed elaborazione dell’informazione ci sta rendendo più connessi, più orientati ai dati e più curiosi, determinando una nuova era nella storia dell’interazione umana.

Un altro aspetto chiave di questo fenomeno è la capacità di elaborazione della nostra mente attraverso queste tecnologie, che è sempre più bidirezionale. Mentre le persone ricevono informazioni allo stesso tempo trasmettono, spesso inconsapevolmente, dati: quali informazioni leggiamo, quanto tempo dedichiamo a un post, il nostro livello di interazione, tutte informazioni che permettono ad algoritmi software di identificare e descrivere gran parte della nostra personalità, abitudini, relazioni, amicizie, religione, cultura e vizi.

La guerra cognitiva non colpisce corpi fisici ma le menti esposte a queste tipologie di attacco, cercando di distruggere i nemici dall’interno verso l’esterno oltre che di costringere il nemico a fare la volontà dell’attaccante, renderlo incapace di resistere, scoraggiarlo o sviarlo dai suoi reali obiettivi.

La Guerra cognitiva odierna è in parte l’evoluzione delle operazioni psicologiche (PsyOps) della Guerra Fredda. Come nelle attività di PsyOps “classica”, si identificano tre tipologie principali di informazioni:

- Informazioni bianche (White Product): informazioni ufficiali identificabili in termini di provenienza e fonte certa (ad es. un documento pubblicato da un ente governativo su canali ufficiali);

- Informazioni grigie (Gray Product): informazioni di provenienza ambigua (ad es. un documento apparentemente ufficiale ma pubblicato da fonti non ufficiali);

- Informazioni nere (Black Product): informazioni ufficiali o che devono sembrare provenire da fonti ostili, nemiche.

Rispetto però alle operazioni di guerra psicologica che utilizzano tutte e tre le tipologie di informazioni, la guerra cognitiva utilizza quasi esclusivamente informazioni grigie, in quanto l’ambiguità permette un’estrema efficienza, mentre le informazioni di tipo bianco e nero sono troppo trasparenti e rischiose per influenzare l’opinione pubblica.

Inoltre le PsyOps raramente hanno avuto a che fare con ampie fasce di pubblico, essendo piuttosto mirate a aspecifici target.

Se infine confrontiamo la guerra cognitiva con le altre tipologie di combattimento, non cinetiche, che utilizzano le informazioni, possiamo notare un’elevata interazione della guerra cognitiva in tutti gli ambiti operativi (Tab. 1).

CLASSIFICAZIONE DEGLI ATTACCHI

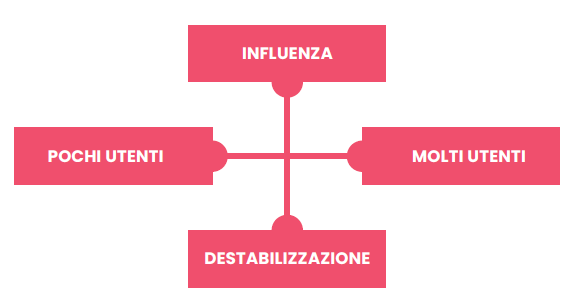

Uno dei primi aspetti che la Cognitive Security deve gestire, per poter avviare strategie e tattiche di difesa, è la classificazione degli attacchi. In particolare si deve tener conto degli eventi e collocarli in specifici ambiti di accadimento, in modo da disporre non solo della tipologia di evento ma anche dell’impatto in grado di generare. In Fig. 1 si riporta un grafico formato da una coppia di assi in base ai quali gli attacchi possono essere classificati.

Il primo obiettivo di una guerra cognitiva è destabilizzare le popolazioni bersaglio. La destabilizzazione avviene interrompendo il corretto funzionamento dell’organizzazione del governo del Paese, ad es. rimarcando preesistenti divisioni all’interno di gruppi nella popolazione, delegittimando il governo o la leadership politica, rallentando la produttività chiave della nazione, confondendo una popolazione su cosa sia giusto e di chi possa fidarsi, facendola così concentrare sui problemi interni anziché su obiettivi comuni/esteri.

Il secondo obiettivo fondamentale è influenzare le popolazioni bersaglio, manipolando l’interpretazione e la comprensione di fatti ed eventi al fine di guidare le azioni del bersaglio nel modo desiderato dall’autore dell’attacco. L’obiettivo di influenzare è diverso dall’obiettivo di destabilizzare: l’intento finale, in questo caso, è che un target abbia la stessa mentalità e opinione su un determinato pensiero, fatto o evento. Non esistono limiti a questa capacità di influenza: gli attaccanti possono spingersi fino al cambiamento radicale di pensiero di una popolazione, o di parte di essa, anche verso idee radicate e fondamentali con cui è cresciuta. Per raggiungere un pubblico più vasto l’attaccante può utilizzare come vettori personaggi famosi, politici o accademici, promuovendo ideologie estremiste, dissenso, delegittimando elezioni, governi, etc.

Se la guerra cognitiva, nella sua attuale forma, è già di per sé pericolosa, nel prossimo futuro le sue capacità offensive saranno sempre maggiori e il suo potenziale crescerà in maniera esponenziale con le tecnologie; si pensi ad es. alla guerra cognitiva nel metaverso, sublimazione virtuale del pensiero e della vita reale delle persone. Altre discipline – come la psicologia, la sociologia e le neuroscienze – sono agli albori di fronte a questa nuova problematica da comprendere e gestire. La velocità della tecnologia e la sua rapida evoluzione applicativa dimostrano capacità di adattamento e mutazione estremamente rapide. La massiccia presenza di dati comportamentali resi disponibili dall’avvento dei social media ha consentito ai ricercatori di fare progressi significativi nella comprensione delle dinamiche delle grandi masse di popolazione online.

Tuttavia, man mano che gli scienziati approfondiscono la conoscenza dell’evoluzione umana nelle sue interazioni, comportamenti e capacità di pensiero, paradossalmente diventiamo sempre più vulnerabili a coloro che cercano di sfruttare queste intuizioni e conoscenze per sviluppare nuove azioni di attacco.

Una delle maggiori differenze tra la guerra cognitiva e le altre forme di guerra non cinetica è che, mentre gli altri attacchi richiedono un’azione pro-attiva verso un nemico (pensiamo a un attacco cyber di tipo DDOS oppure all’invio di un’email di phishing), la guerra cognitiva può elaborare attacchi in cui le vittime si imbattono anche casualmente nelle minacce, ad es. tramite innocui post o tweet casuali, che attirano l’utente spingendolo a cercare attivamente informazioni che affermano le convinzioni che si vogliono trasmettere, in maniera molto simile alle tecniche di marketing push e pull. Con l’avvento dell’Intelligenza Artificiale vengono utilizzati algoritmi in grado di catturare la nostra attenzione e guidarci verso l’obiettivo desiderato dal nemico, che è in grado di creare narrazioni e storie utilizzando i dati forniti dagli stessi utenti a loro insaputa.

COGNITIVE SECURITY VS CYBER CRIME

La natura sempre più organizzata e “professionale” del crimine informatico vede la cognitive security in prima linea nel contrasto agli attacchi cognitivi dei cyber criminali.

Da sempre il raggiro e l’inganno sono alla base di truffe e reati economici nel cyber spazio; negli ultimi anni l’utilizzo avanzato della disinformazione ne ha aumentato esponenzialmente l’impatto.

Il Framing Bias, che sfrutta i bias cognitivi (meccanismi spesso inconsci della mente umana, attraverso i quali creiamo distorsioni nelle valutazioni di fatti e avvenimenti), è uno dei vettori più comunemente sfruttati ad es. nelle truffe BEC (Business Email Compromise). Esso si riscontra laddove un individuo prende una decisione a causa del modo in cui le informazioni vengono presentate, piuttosto che esaminare i fatti o attenersi a procedure e processi noti: ad esempio la pressione psicologica di ricevere un’email dall’amministratore della propria azienda, nella quale si viene esortati a svolgere un “compito urgente”, a causa della paura di disattendere la richiesta ed eventualmente ricevere una nota di demerito o addirittura il licenziamento, potrebbe sostituire il pensiero analitico e by-passare i processi di sicurezza di gestione dei flussi aziendali.

La Cognitive Security deve così sviluppare difese per attacchi basati anche su strumenti legati alla psicologia e alle neuroscienze. È necessario comprendere i pregiudizi cognitivi e utilizzare la consapevolezza della sicurezza per coltivare una cultura della fiducia: non lasciare che i preconcetti – o quello che si vorrebbe accadesse – offuschino il giudizio del momento, la riflessione e l’analisi obiettiva è la principale linea di difesa contro i cyber criminali.

Da anni si parla infatti di “Human Firewall”, cioè degli utenti come miglior strumento di difesa. Fornire ai dipendenti di un’organizzazione la formazione continua e la conoscenza degli strumenti e degli ambienti informatici in cui sono quotidianamente “immersi” rappresenta la baseline di sicurezza primaria. Dare alle persone l’istruzione necessaria a comprendere e combattere i propri pregiudizi significa proteggere le organizzazioni, ridurre significativamente i rischi e promuovere una cultura della fiducia nei rapporti e nei processi operativi.

La diffusione della disinformazione, delle fake news e il fenomeno dell’illetteratismo – meglio conosciuto come analfabetismo funzionale – sono vettori di attacco cognitivi estremamente potenti, soprattutto nell’ambito digitale.

Sempre più spesso si riscontrano attacchi di ingegneria sociale personalizzati che sfruttano i pregiudizi cognitivi delle vittime. Negli ultimi attacchi di social engineering registrati e nello specifico nel phishing (mirati a rubare credenziali, esfiltrare dati, installare ransomware etc.) si nota appunto un’elevata personalizzazione e qualità del vettore di attacco cognitivo, di solito tesa a sfruttare specifici bias fondati su alcune “scorciatoie mentali” che gli esseri umani eseguono inconsciamente quando interpretano le informazioni: semplificare l’elaborazione delle informazioni per accelerare il processo decisionale. I criminali informatici manipolano i pensieri e le azioni di un destinatario per convincere quella persona ad avere comportamenti rischiosi, come ad esempio fare click su un link che in condizioni normali non aprirebbero, o inserire informazioni riservate su un sito Web per velocizzare una “pressante” richiesta da parte di un superiore.

Un aspetto interessante da evidenziare negli attacchi cognitivi è che nella maggior parte dei casi è proprio l’utente che li innesca: quindi, sebbene siano sempre più disponibili sul mercato tecnologie (soprattutto basate sull’A.I.) per individuare attacchi cognitivi, attualmente l’unica difesa che la cognitive security può adottare efficacemente per questo tipo di attacco è la formazione continua, fino al “nagging” degli utenti.

Va infine evidenziato che la formazione alla sicurezza su questa tipologia di minacce deve essere specifica: i tradizionali programmi di formazione, infatti, raramente tengono conto del ruolo svolto dai pregiudizi cognitivi in queste situazioni e, soprattutto, in genere non considerano i ruoli delle persone e il loro comportamento passato. Un recente studio commissionato da Elevate Security sui tradizionali corsi di sensibilizzazione ai rischi informatici ha addirittura evidenziato come, se sulla tematica specifica si svolgono quasi esclusivamente attività di phishing simulator, all’aumentare delle simulazioni e delle mere verifiche la formazione possa addirittura risultare controproducente, facendo sì che le persone facciano click sui collegamenti malevoli più spesso rispetto a persone con poca o nessuna formazione.

LA COGNITIVE SECURITY E IL CICLO DELL’INTELLIGENCE

Tra tutte le metodologie di difesa in ambito cyber la Cognitive Security è sicuramente la più affine all’utilizzo del trattamento delle informazioni attraverso il cosiddetto “ciclo dell’intelligence”, un processo di analisi in varie fasi finalizzato a rappresentare e trasformare i dati “grezzi” raccolti in un contesto analitico e/o scenario con possibili svolgimenti e accadimenti.

Le principali macro-fasi del ciclo dell’intelligence sono:

- Pianificazione – rappresenta l’indice dell’intera attività: obiettivi dell’analisi, identificazione dei dati necessari, metodologie e strumenti di raccolta, risorse da impiegare per l’analisi, consumatore finale dell’elaborazione. È di fatto un aspetto che riguarda l’inizio e la fine del ciclo: l’inizio perché comporta l’elaborazione di specifici requisiti di raccolta e la fine perché l’intelligenza finita, l’elaborato che supporta le decisioni, può generare a sua volta nuovi requisiti.

- Raccolta – indica appunto la raccolta delle informazioni grezze (OSINT, CLOSINT ecc.) necessarie per produrre l’elaborato finale.

- Elaborazione – racchiude le attività di scrematura, riduzione e conversione della grande quantità di informazioni raccolte in moduli di base utilizzabili dagli analisti.

- Analisi e produzione – converte le informazioni di base elaborate in informazioni complete realizzate attraverso l’integrazione, la valutazione e l’analisi di tutti i dati disponibili.

- Diffusione – l’ultimo passaggio, che può ri-alimentare il primo, è la distribuzione dell’intelligence finita ai consumatori finali, ovvero i decisori i cui bisogni hanno reso l’analisi necessaria.

La Cognitive Security opera attraverso queste fasi: la sua policy d’azione viene implementata sulla pianificazione delle necessità di sicurezza dell’organizzazione, è in grado di acquisire e raccogliere informazioni potenzialmente pericolose, elabora queste informazioni sulla base delle vulnerabilità note e le minacce individuate, analizza e produce regole e processi di sicurezza per la difesa, diffondendo e mettendo a disposizione dell’utente finale la conoscenza e gli strumenti necessari per poter prendere una decisione: ad esempio, banalmente, se cliccare o meno su un link.

Negli ultimi anni si sta sviluppando, all’interno del modello di Cognitive Security, un ulteriore modulo di contro-intelligence, cioè un processo pro-attivo rivolto al contrasto dello spionaggio, della criminalità organizzata e del terrorismo in ambito cyber: un processo di raccolta e analisi dei dati basato sulla deception technology. Utilizzando questa tecnologia si cerca di attirare la potenziale minaccia in un ambiente artefatto, simile a un ambiente reale, dove poter studiare i vettori di attacco, stimolare l’agente ostile a esporsi ed eventualmente testare il potenziale di minaccia senza provocare alcun danno reale. I risultati vanno a integrare gli altri dati acquisiti nella fase di raccolta. Inoltre questo modulo, attirando gli agenti ostili in mondi artefatti e controllati, ne rallenta le attività sui target reali, impegnandone le risorse su obiettivi fittizi e a volte riuscendo addirittura ad annullare un attacco.

IMPLEMENTAZIONE DELLA COGNITIVE SECURITY

Di fatto la COGSEC è quindi l’insieme delle tecniche e delle metodologie di difesa dagli attacchi di ingegneria sociale, dalle manipolazioni – intenzionali e non – della cognizione e capacità sensoriale degli utenti. Tecniche e tecnologie di sicurezza cognitiva mirano a rafforzare gli individui e le popolazioni contro queste influenze nocive e a rendere inefficaci gli influencer dannosi.

Tentare di influenzare il pubblico non è certo una novità. Politici, lobbies, leader di mercato e altri soggetti hanno da sempre usato retorica, propaganda e messaggi per manipolare l’opinione pubblica. Ciò che è nuovo sono gli strumenti oggi a loro disposizione: la capacità di diffusione e la trasmissione h24 di notizie consentono flussi costanti di informazioni, che a loro volta rendono più facile che mai influenzare la mente umana.

Le democrazie occidentali risultano più esposte a questo tipo di attacchi; grazie infatti alla libertà di informazione gli attacchi cognitivi vengono effettuati più facilmente, a differenza di quanto avviene in Stati autoritari (come Cina, Russia e, molto più drasticamente, Corea del Nord) in cui si applicano restrizioni, divieti e censura generale nei confronti di Internet e delle piattaforme social. Inoltre le democrazie occidentali sono carenti nella loro comprensione della guerra cognitiva e, spesso, anche meno preparate ad affrontare tale minaccia in rapida evoluzione.

In termini generali, sviluppare una difesa basata sulla sicurezza cognitiva prevede tre elementi fondamentali:

- aumentare la resilienza cognitiva contro l’influenza dannosa, che include la coltivazione del pensiero critico e dell’alfabetizzazione mediatica attraverso l’istruzione, nonché lo sviluppo di strumenti in grado di fornire identificazione e difesa in tempo reale per le persone e le organizzazioni che incontrano sforzi di influenza sofisticati. Queste tecnologie devono funzionare sulla medesima scala e alla stessa velocità di Internet, ad esempio consentendo l’identificazione automatizzata di deepfake e altri media manipolati;

- raggiungere un’ampia consapevolezza della situazione, che include il rapido rilevamento e caratterizzazione delle campagne di influenza dannosa nonché la previsione di assistenti personali virtuali che aiutino gli individui e le organizzazioni a identificare le fonti e gli obiettivi dei contenuti ingannevoli;

- creare capacità di coinvolgimento cognitivo accurate e solide per contrastare l’influenza dannosa, come quella diffusa online da agenti o bot basati su software.

Contrariamente alla sicurezza informatica che enfatizza la protezione di dispositivi, computer, reti e altre macchine, la sicurezza cognitiva si concentra sulla protezione dell’essere umano: obiettivo che richiede un approccio socio-tecnico capace di integrare una serie di discipline tra cui scienze sociali/comportamentali, Intelligenza Artificiale, scienza dei dati e informatica avanzata. Questo approccio implica non solo l’integrazione olistica di strumenti, modelli e set di dati ma anche la traduzione delle esigenze di sicurezza cognitiva in problemi che possano essere affrontati in collaborazione da governi, industrie e mondo accademico. Rispondere a questa esigenza è un importante banco di prova per la sicurezza cognitiva, soprattutto in termini di sicurezza nazionale.

Per cambiare le sorti di una guerra cognitiva è necessario, quindi, lavorare a vari livelli per definire e misurare le minacce, valutare le vulnerabilità e svolgere attività di formazione volta alla mitigazione e alla risposta verso campagne di attacco cognitivo.

La sicurezza cognitiva deve poter affrontare domande chiave, quali: “Come proteggiamo le popolazioni da campagne di disinformazione e disinformazione su larga scala?”, “Come misuriamo l’efficacia delle tecniche e delle tecnologie di sicurezza cognitiva?”. Affrontare le questioni etiche, legali e sociali è fondamentale per lo sviluppo di tecniche e tecnologie di sicurezza cognitiva. Le linee di difesa della sicurezza cognitiva devono fornire la ragionevole certezza che eventi, fatti e pensieri delle persone non siano influenzati da agenti esterni con intenzioni dannose comunicate online e/o offline.

Riferimenti

Backes, Oliver and Andrew Swab. “Cognitive Warfare: The Russian Threat to Election Integrity in the Baltic States.” Paper, Belfer Center for Science and International Affairs, Harvard Kennedy School, November 2019.

Articolo a cura di Francesco Arruzzoli

Con oltre 25 anni di esperienza nell’ambito della sicurezza delle informazioni Francesco Arruzzoli è Senior Cyber Security Threat Intelligence Architect presso la Winitalia srl di cui è cofondatore. Si occupa di progettare infrastrutture e soluzioni per la Cyber Security di aziende ed enti governativi. In passato ha lavorato per multinazionali, aziende della sanità italiana, enti governativi e militari. Esperto di Cyber Intelligence e contromisure digitali svolge inoltre attività di docenza presso alcune università italiane.