Deepfake e Intelligenza Artificiale: tra rischi di sicurezza e vantaggi

La diffusione di attacchi e di minacce le quali utilizzano come vettore il deepfake e la manipolazione delle informazioni rappresentano sfide significative per la sicurezza e l’integrità delle informazioni. I contesti in cui è opportuno porre attenzione sono plurimi, vedasi l’ambito politico, aziendale e sociale e pertanto, nel mare magnum delle molteplici minacce che permeano il panorama del mondo cibernetico, tali attacchi richiedono l’impiego di tecniche e strumenti difensivi che si dimostrino non solo efficienti, ma altresì altamente rapidi nella loro evoluzione.

Definizione e Funzionamento dei Deepfake

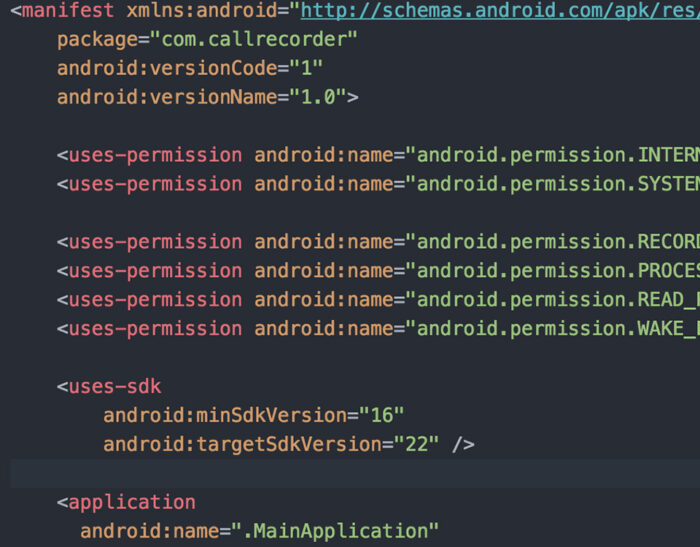

I deepfake sono contenuti multimediali manipolati, spesso video, che utilizzano la tecnologia dell’intelligenza artificiale (IA) per creare immagini realistiche di persone o situazioni che in realtà non sono accadute. Vengono quindi sviluppati attraverso tecniche per la sintesi dell’immagine umana basata sull’intelligenza artificiale, usata per combinare e sovrapporre immagini e video esistenti con video o immagini originali, tramite un procedimento di apprendimento automatico, conosciuto come rete antagonista generativa (comunemente nota come GAN (dall’inglese “Generative Adversarial Network”). Le reti GAN sono composte da due componenti principali, i quali lavorano in maniera antagonista: il generatore e il discriminatore.

- Generatore (Generator): Il generatore in una rete GAN ha il compito di creare dati artificiali che dovrebbero sembrare il più possibile simili ai dati di addestramento reali. Ad esempio, nel contesto dei deepfake, il generatore potrebbe produrre immagini o audio che sembrano provenire da una persona specifica, anche se sono in realtà completamente sintetiche.

- Discriminatore (Discriminator): Il discriminatore, d’altra parte, è un modello di apprendimento che cerca di distinguere tra dati reali e dati generati dal generatore. Nel contesto dei deepfake, il discriminatore valuta se un’immagine o un audio è autentico o se è il risultato della generazione del generatore. Il suo obiettivo è migliorare nel riconoscere la differenza tra dati reali e dati sintetici.

In sostanza quindi, il processo di addestramento di una rete GAN è basato su una competizione continua tra il generatore e il discriminatore. Il generatore cerca di migliorare costantemente la sua capacità di generare dati falsi che sembrano reali, mentre il discriminatore cerca di diventare sempre più abile nel distinguere tra dati reali e generati. Questo ciclo di retroazione continua fa sì che entrambi i componenti della rete migliorino nel corso del tempo.

Impieghi e Rischi dei Deepfake

Tale tecnologia, quindi, può essere adoperata per la creazione di notizie fasulle, la disseminazione di informazioni ingannevoli e l’organizzazione di truffe, dando luogo a comportamenti quali il cyberbullismo o altri reati informatici di varia natura. Allo stesso modo, può essere utilizzata a fini satirici.

L’affermazione “Se non vedo non credo”, come proferito da san Tommaso Apostolo in merito alla risurrezione di Gesù, precedentemente contestata dai suoi apostoli, risulta ora obsoleta e, persino pericolosa. L’avvento della tecnologia deepfake sta alterando profondamente le dinamiche, esigendo dagli utenti della Rete una vigilanza sempre più acuta sulla genuinità dei contenuti da loro fruiti.

D’altronde è sufficiente vedere gli esempi riportati nel link di seguito: https://www.creativebloq.com/features/deepfake-examples per rendersi conto del grado di pericolosità che un’azione così mistificatoria e anche apparentemente satirica può provocare. Danni a persone e cose, azioni e reazioni sono solo alcune delle conseguenze plausibili che questa affascinante e pericolosa tecnologia può generare. Per comprendere al meglio quindi il processo che si cela dietro la creazione dei deepfake è opportuno sciogliere l’argomento nei suoi passaggi chiave:

- Raccolta dei dati: Per creare un deepfake audio convincente, è necessario raccogliere un ampio set di dati vocali dalla persona di destinazione. Questi dati possono essere estratti da interviste, discorsi pubblici, podcast o altri contenuti vocali disponibili.

- elaborazione dei dati: I dati vocali raccolti vengono elaborati per estrarre le caratteristiche significative della voce, come il tono, la modulazione, il ritmo e altri tratti distintivi.

- Addestramento del modello: Un modello di apprendimento profondo, come una rete neurale, viene addestrato utilizzando il set di dati vocali della persona di destinazione. Durante l’addestramento, la rete impara a riconoscere e riprodurre le caratteristiche vocali specifiche della persona.

- Generazione del deepfake audio: Una volta addestrato il modello, è possibile utilizzarlo per generare nuovi segmenti vocali. Questi segmenti possono essere basati su script specifici o generati in modo più libero, a seconda degli obiettivi dell’utilizzatore del deepfake audio.

- Ottimizzazione: Il risultato del deepfake audio può essere ottimizzato per renderlo più realistico e convincente. Questo potrebbe coinvolgere l’aggiunta di rumori ambientali, la regolazione di parametri specifici o altre tecniche di perfezionamento.

- Distribuzione o utilizzo: Una volta creato il deepfake audio, può essere distribuito o utilizzato per vari scopi, che vanno dall’intrattenimento alla manipolazione di informazioni.

“Come mai potrebbero vivere i ciarlatani e gl’imbroglioni, se non gettassero l’amo all’ingenua turba con qualche scrignetto o qualche borsa piena di denaro sonante? Come i pesci si prendono coll’esca, così gli uomini non si potrebbero gabbare, se non si desse loro qualche speranza da mordere”. (Petronio Arbitro).

Le Tipologie di Deepfake

Esistono diverse tipologie di deepfake, e la tecnologia continua a evolversi. Alcune delle principali categorie di deepfake includono:

Face swaps: In questa categoria, il viso di una persona di origine (source) viene sovrapposto su una persona destinataria (target). Questa pratica è comunemente utilizzata per creare contenuti ironici sui social media, spesso facendo uso dei volti di celebrità. Le tecnologie attuali, come le reti neurali profonde (Deep Neural Network – DNN), sono impiegate per questo scopo, anche se le prime forme di face swap risalgono agli anni ’90 con l’uso di software come Adobe Photoshop.

Lip-syncing: In questa tipologia, un video viene modificato per far sembrare che la persona destinataria pronunci frasi fittizie. Questo processo coinvolge l’utilizzo della voce registrata da una o più fonti, sincronizzata con un altro video per renderlo autentico. Un esempio iniziale di questa tecnica è stato Face2Face, un modello creato da ricercatori di Stanford nel 2017, che fa uso delle Reti Neurali Ricorrenti (Recurrent Neural Networks – RNN).

Puppet-master: Questo tipo di deepfake coinvolge l’imposizione dell’aspetto di una persona destinataria (puppet) su un’altra persona che compie azioni. Una metodologia comune per creare questo tipo di deepfake utilizza le reti generative avversarie (GAN), in cui un “generatore” di dati falsi sfida un “discriminatore” il cui compito è distinguere tra dati reali e falsi. L’efficacia di questo modello dipende dalla capacità del generatore di “ingannare” il discriminatore.

Impatti dei Deepfake sulla Società: Riflessioni e Conseguenze

Abbiamo capito quindi quali sono le enormi potenzialità di questo strumento. Ora è opportuno fare un ragionamento relativo ai possibili ambiti che possono risentire dell’alterazione della realtà causata dallo sfruttamento di potenti tool tecnologici uniti alla fantasia umana.

Implicazioni politiche: La diffusione di deepfake e la manipolazione delle informazioni possono portare gravi conseguenze nel contesto politico. Può diventare difficile distinguere la realtà dalla finzione, e questo potrebbe influenzare l’opinione pubblica, le elezioni e la stabilità politica. Basti pensare al simulato episodio in cui Renzi, apparentemente presente, manifestava il suo dissenso attraverso un gesto volgare verso Mattarella durante una trasmissione satirica come “Striscia la Notizia”.

Come spesso accade, è stato necessario un programma di satira per porre l’attenzione su una questione estremamente seria. Non si trattava né di un imitatore né di un sosia; questa volta, la tecnologia si è rivelata l’ultima frontiera della manipolazione. Non solo è in grado di acquisire i tratti di un volto e sovrapporlo a chiunque altro ma può anche catturare l’autentico timbro della tua voce, rimodulandolo per far pronunciare parole che non sono mai state dette. Quindi, eventuali implicazioni di natura politica potrebbero riverberarsi sulla stabilità nazionale.

Politici e leader possono diventare bersagli di deepfake, con la creazione di contenuti falsi atti a danneggiare la loro reputazione o influenzano l’immagine pubblica. Questo potrebbe avere conseguenze sulla loro carriera politica e sulla stabilità delle istituzioni. La manipolazione di discorsi e dichiarazioni di leader politici, può alimentare confusione o portare a malintesi diplomatici con gravi conseguenze gravi relazioni internazionali e nella diplomazia. (https://www.youtube.com/watch?v=JZl3cQTL6U0).

Ma, anche ponendo il caso che l’arguzia umana superi la sofisticatezza tecnologica, si potrebbe ingenerare un fenomeno quasi contrario. Il bombardamento mediatico di contenuti manipolati e manipolatori potrebbe contribuire a una crescente sfiducia nella veridicità delle informazioni e delle immagini. La manipolazione digitale potrebbe mettere in discussione l’autenticità di qualsiasi dichiarazione o evento, complicando la formazione di opinioni informate. Per concludere, o nei confronti della reputazione personale o anche peggio contro la stabilità politica e nazionale, questi contenuti possono risultare machiavellici e dannosi.

Implicazioni Aziendali e Rischi Economici

Implicazioni aziendali: Nel mondo complesso e sempre più interconnesso delle aziende, la manipolazione delle informazioni è senza dubbio una minaccia reale. Questa pratica non solo punta a danneggiare la reputazione delle organizzazioni, ma può anche avere impatti significativi sui mercati finanziari, generando danni notevoli.

Si può immaginare una situazione in cui notizie false sulle performance finanziarie di un’azienda vengono disseminate intenzionalmente. Un simile scenario potrebbe causare turbolenze finanziarie e minare la fiducia degli investitori, gettando un’ombra sull’integrità aziendale. La veridicità delle informazioni è un pilastro fondamentale nelle dinamiche aziendali, e la manipolazione di dati finanziari tramite deepfake costituisce una minaccia tangibile.

In aggiunta, emerge il rischio di frode, dove i deepfake diventano strumenti per ingannare le aziende. Basti pensare alla creazione di video contraffatti di dirigenti aziendali, i quali veicolano messaggi falsi o transazioni finanziarie manipolate. Questa forma di inganno può arrecare danni irreparabili alla reputazione delle aziende e dei loro leader.

Tuttavia, le preoccupazioni non si limitano alle questioni finanziarie. L’utilizzo dei deepfake apre la porta a nuove minacce per la sicurezza informatica. Criminali potrebbero sfruttare questa tecnologia per eludere sistemi di autenticazione basati su riconoscimento facciale o vocale. Inoltre, i dipendenti stessi potrebbero essere vittime di deepfake senza il loro consenso, un’azione che viola la loro privacy e crea situazioni dannose sia a livello personale che professionale.

Rischi e Sfide del Deepfake Audio

Il deepfake audio è una tecnica che utilizza l’intelligenza artificiale, in particolare il deep learning, per manipolare e generare file audio falsi che sembrano autentici. Questa tecnologia può essere utilizzata per alterare voci, creare discorsi o dialoghi inventati, o persino imitare voci di persone specifiche in modo convincente. Le moderne simulazioni vocali hanno raggiunto oltretutto una precisione tale da imitare con straordinaria fedeltà l’intonazione, il ritmo e le sfumature di una voce umana (impressionanti a tal proposito sono i deepfake che utilizzano voci di cantanti famosi deceduti utilizzandole in canzoni moderne ampiamente diffuse https://www.youtube.com/watch?v=Num0q-l-ldc). Questa capacità le rende virtualmente indistinguibili dalla realtà, diventando un potente strumento nelle mani dei criminali per truffare individui e aziende.

Un esempio recente, riportato dal New York Times, coinvolge un falso robocall che impersona il presidente Biden, il quale mira allo scopo di influenzare le primarie del New Hampshire. La chiamata, che sembra provenire da Kathy Sullivan, ex presidente del Partito Democratico del New Hampshire, scoraggia gli elettori dal partecipare alle primarie. Biden non è in corsa nelle primarie del New Hampshire, ma la chiamata è stata manipolata per sembrare legata a una campagna a livello statale che incoraggia a votare per lui.

Ma perché i deepfake audio sono così complessi da distinguere, a tal punto che sono tra i più utilizzati in truffe e tentativi di frode? Uno studio (Warning: Humans cannot reliably detect speech deepfakes) ha dimostrato che i partecipanti hanno fallito il 25% delle volte nel tentativo di rilevare i deepfake vocali. La metà dei partecipanti ha ricevuto una formazione preliminare ascoltando cinque esempi di voce sintetizzata, ma la loro prestazione è stata migliore solo del 3% rispetto al gruppo non addestrato.

Questo perché l’audio è soggettivo. A differenza del rilevamento dei deepfake visivi, in cui l’autenticità può essere giudicata osservando oggetti e sfondi, la natura soggettiva del parlato fa sì che le percezioni varino maggiormente. Le onde sonore assumono frequenze diverse attraversando l’aria o un mezzo solido e quindi la voce ha un timbro diverso. Inoltre, un registratore altera la voce, anche se in maniera minima.

Durante la registrazione, infatti, il suono viene “tradotto” da onde sonore meccano-elastiche (cioè vibrazioni) a onde elettromagnetiche (cioè segnali elettrici), mentre per l’ascolto avviene il processo inverso: così la voce che esce da questi passaggi non è mai perfettamente identica all’originale, e questo chiaramente ci rende meno attenti ai messaggi veicolati tramite voce, dato che siamo abituati a sentire anche voci a noi care come diverse via messaggio vocale. Il cervello umano è generalmente più sensibile e attento alle informazioni visive rispetto a quelle uditive e, dato che il riconoscimento di voci e tratti vocali è un processo complesso, è più difficile individuare anomalie nell’audio rispetto a segnali visivi.

Nel video, inoltre, ci sono più punti di riferimento visivi, come espressioni facciali, movimenti degli occhi, ecc, i quali possono essere utilizzati per individuare incongruenze. Nell’audio, tali punti di riferimento sono meno evidenti, rendendo difficile l’individuazione di manipolazioni.

Un ulteriore elemento discriminatorio si riscontra nel fatto che le persone possono essere più propense a sospettare di manipolazioni visive rispetto a manipolazioni uditive. Ciò può essere dovuto allo stigma che il concetto di “vedere per credere ” è più radicato nella società rispetto al “sentire per credere”.

Vantaggi e Utilizzi Positivi dei Deepfake

I deepfake, se utilizzati in modo etico e responsabile, presentano diverse applicazioni potenzialmente vantaggiose in diversi settori. Basti pensare a quante possibilità possono verificarsi in contesti in cui il limite pare essere solo quello della propria fantasia, che, si spera sempre di più, possa essere delineato dalle norme.

Di seguito sono stati fatti alcuni ragionamenti liberi rispetto ad ambiti in cui i deepfake possono trovare utilità:

Nel settore della formazione e dello sviluppo aziendale, l’integrazione dei deepfake può trasformare il modo in cui i dipendenti acquisiscono competenze. Le simulazioni realistiche, come colloqui, sessioni di coaching o scenari di interazione con i clienti, potrebbero offrire un ambiente di apprendimento più coinvolgente ed efficace. Ciò potrebbe tradursi in una migliore preparazione dei dipendenti e, di conseguenza, in un miglioramento delle prestazioni aziendali.

Per quanto riguarda la produzione di contenuti multimediali, soprattutto nell’industria dell’intrattenimento, i deepfake rappresentano un’opportunità unica. La capacità di creare personaggi digitali convincenti può ridurre significativamente i costi di produzione nella post-produzione, consentendo una maggiore flessibilità creativa. Questo potrebbe portare a storie più coinvolgenti, effetti speciali avanzati e un processo di produzione più efficiente nel complesso.

Un esempio su tutti di utilizzo di Deepfake con scopi migliorativi lo si può trovare in ambito sanitario: il progetto Revoice. La tecnologia deepfake può restituire la voce a coloro che hanno perso la capacità di parlare a causa di malattie come la SLA. L’iniziativa denominata “Progetto Revoice” ha come obiettivo primario la completa ricreazione dell’essenza unica di qualsiasi voce, al fine di sviluppare un clone digitale della stessa destinato all’utilizzo quotidiano mediante dispositivi di Comunicazione Aumentata/Alternativa (AAC).

Prevenzione e Difesa: Strategie e Strumenti

A causa della crescente sofisticazione delle tecnologie di manipolazione, la verifica dell’autenticità delle informazioni sta diventando una vera e propria sfida. Per questo motivo i grandi players dell’industria tecnologica si stanno adoperando per trovare delle contromisure al fine di limitare e contenere l’efficacia degli attacchi massivi e fraudolenti tramite deepfake.

Ad esempio, durante l’evento Consumer Electronics Show 2024, McAfee ha presentato Project Mockingbird, una soluzione che fa leva sull’intelligenza artificiale per mitigare i rischi legati alle frodi ai danni degli amministratori delegati (Ceo fraud) e ai deepfake audio. Project Mockingbird sta sviluppando una forma di riconoscimento attraverso l’integrazione di modelli di rilevamento contestuali, comportamentali e categoriali, impiegando l’intelligenza artificiale per determinare se l’audio di un video è probabilmente generato da un sistema di intelligenza artificiale. Anche Google ha intensificato la sua lotta contro i deepfake, immagini e video generati artificialmente, attraverso un aggiornamento della funzione “Informazioni su questa immagine”. Questa funzionalità fornisce agli utenti dati utili per verificare l’autenticità di un’immagine online.

L’aggiornamento ora è integrato nel motore di ricerca di Google. Gli utenti possono cliccare sui tre punti nell’angolo in alto a destra di un’immagine nei risultati di ricerca per accedere a informazioni specifiche. Questo include dettagli su quando l’immagine è apparsa per la prima volta su Google e altre pagine web, nonché l’utilizzo e la descrizione della foto da parte dei siti. Inoltre, per aiutare a identificare i deepfake, Google consente di visualizzare i metadati aggiunti a un’immagine, inclusi quelli che potrebbero indicare la generazione o il miglioramento tramite intelligenza artificiale.

Tuttavia, ciò dipende dalla corretta inserzione dei metadati da parte del proprietario dell’immagine. Esistono software più avanzati e a pagamento, come Sensity.ai, Sentinel, e il recente software di Intel con il detector “FakeCatcher”, che utilizzano l’intelligenza artificiale, in particolare reti neurali, per analizzare il contenuto alla ricerca di anomalie, ottenendo un’elevata percentuale di successo nell’identificazione dei deepfake. Tuttavia, attualmente, tali software con elevate capacità di calcolo e precisione sono limitati e prevalentemente utilizzati da grandi aziende e istituzioni. È opportuno quindi puntare sulla educazione delle persone e dare loro degli strumenti difensivi basati sulla consapevolezza. Puntare al fattore umano quindi, come baluardo della difesa personale e aziendale.

Educazione e Consapevolezza

Come visto pocanzi quindi, l’educazione del pubblico sulla possibilità di manipolazioni delle informazioni è fondamentale. La consapevolezza del problema può e deve aiutare le persone a essere più critiche nelle valutazioni delle informazioni che incontrano online. La sfida che viene posta oggi è: come si può creare un percorso di Awareness che ci possa istruire al meglio su questa nuova minaccia?

Certamente è opportuno porre l’attenzione sulla formazione tecnica, magari offrendo corsi o risorse online che insegnino le basi delle tecnologie utilizzate per creare deepfake, oppure promuovere il pensiero critico, fornendo esempi pratici e aggiornando le persone tramite newsletter, oltre che sensibilizzare il pubblico sui tool suddetti di detection.

Proviamo ora a stilare noi una lista di elementi dei quali è opportuno tener conto per difendersi da attacchi generati con i Deepfake:

Occhi: La replicazione del naturale movimento degli occhi e dello sbattere delle ciglia risulta ancora complessa, poiché il soggetto spesso segue o fissa l’interlocutore durante una conversazione. Un movimento degli occhi innaturale o distorto può essere un segnale di possibile presenza di deepfake. Nel caso di immagini, è importante osservare la pupilla del soggetto, poiché spesso viene ricreata in modo inaccurato con bordi sfocati e una forma poco definita.

Viso ed espressioni facciali: I deepfake spesso coinvolgono sovrapposizioni di immagini, generando espressioni facciali distorte e innaturali. La pelle può essere un indicatore utile, specialmente se presenta discromie evidenti, texture irrealistiche (troppo liscia o troppo rugosa), ombre strane e barba o baffi con forme e definizioni anomale.

Denti e capelli: La ricostruzione di denti e capelli tramite intelligenza artificiale è difficile, e questo può rendere i sorrisi nei deepfake strani e poco definiti o i capelli troppo piatti e luminosi, come se fossero un oggetto unico.

Rumori o audio incoerente: Nell’analisi di un video, è essenziale prestare attenzione all’audio e cercare di correlarlo con il movimento delle labbra della persona che parla. La mancanza di coerenza tra audio e movimenti labiali può indicare la presenza di un deepfake.

Distorsioni visive: Pixel visibili, ombre innaturali o la presenza di oggetti fuori posto costituiscono indicatori importanti di un possibile deepfake.

Attendibilità della fonte: Oltre all’analisi visiva del presunto deepfake, è cruciale considerare la fonte in cui l’immagine o il video è stato pubblicato, valutandone l’affidabilità e la reputazione.

Affrontare queste sfide richiederà sforzi coordinati tra governi, aziende, organizzazioni non governative e individui. La ricerca continua, lo sviluppo di tecnologie di difesa avanzate e la promozione della consapevolezza sono tutte parti cruciali di una strategia globale contro la manipolazione delle informazioni.

Riferimenti bibliografici

- https://www.theguardian.com/technology/2018/nov/12/deep-fakes-fake-news-truth

- https://www.creativebloq.com/features/deepfake-examples

- https://www.corriere.it/caffe-gramellini/19_settembre_26/profondo-falso-e1d251c8-dfcf-11e9-aa5f-fbca0c81b7c9.shtml?refresh_ce

- https://www.agendadigitale.eu/sicurezza/deepfake-le-armi-per-contrastarli-ci-sono-ma-serve-anche-educazione-ai-rischi/

- https://www.brennancenter.org/our-work/research-reports/regulating-ai-deepfakes-and-synthetic-media-political-arena

- https://www.garanteprivacy.it/home/docweb/-/docweb-display/docweb/9512278#:~:text=I%20deepfake%20sono%20foto%2C%20video,imitare%20fedelmente%20una%20determinata%20voce.

- https://www.medialaws.eu/regulating-deep-fakes-in-the-proposed-ai-act/

- https://www.researchgate.net/publication/350663190_Dealing_with_deepfakes_-_an_interdisciplinary_examination_of_the_state_of_research_and_implications_for_communication_studies

- https://www.academia.edu/68727382/Deep_Insights_of_Deepfake_Technology_A_Review

- https://www.wired.it/play/cinema/2021/04/24/intervista-deepfake-hao-li-massimo-esperto/

- https://link.springer.com/article/10.1007/s00500-023-08605-y

- https://www.youtube.com/watch?v=vqFsaKhGdDY

- https://spectrumnews1.com/ca/la-east/inside-the-issues/2019/09/05/technology-behind-deepfakes-reveals-pros-and-cons

- https://www.ai4business.it/intelligenza-artificiale/visual-deepfakes-come-vengono-generati-e-come-possono-essere-identificati/

- https://www.wired.it/article/google-strumento-deepfake/

- https://www.cybersecurity360.it/news/ces-2024-mcafee-project-mockingbird-la-soluzione-ai-contro-i-deepfake-audio/

- https://journals.plos.org/plosone/article?id=10.1371/journal.pone.0285333

- https://english.elpais.com/society/2023-08-03/ai-voices-are-hard-to-spot-even-when-you-know-it-might-be-a-deepfake.html#

- https://www.destra.it/home/deepfake-audio-la-nuova-frontiera-delle-truffe-telefoniche/

- https://www.agendadigitale.eu/sicurezza/deepfake-le-armi-per-contrastarli-ci-sono-ma-serve-anche-educazione-ai-rischi/

- https://www.wired.com/story/biden-robocall-deepfake-danger/

Articolo a cura di Riccardo Laurenti

Consegue la Laurea magistrale in Scienze Politiche e Relazioni Internazionali presso la LUISS, improntando il percorso formativo in analisi e contrasto a fenomeni terroristici attraverso fonti OSINT e divulgazione mediatica.

Perfeziona il piano di studi prima con il Diploma di Specializzazione di 1° livello in Geopolitica e Sicurezza Globale, con particolare Focus al terrorismo di matrice islamica, poi con il Master 2° livello Homeland Security presso l’ Università Campus Bio-Medico di Roma, nel quale vengono approfonditi aspetti e tematiche di Cyber Security, OSINT, Business Continuity e Sicurezza delle infrastrutture critiche.

Dopo alcune esperienze lavorative nel settore della Reputation Intelligence, tra cui una in un importante player nazionale del settore energetico, attualmente è impiegato in Deep Cyber srl, con il ruolo di Cyber Secuirty Specialist, per il quale si occupa di analisi di minacce Cyber attraverso tools di simulazione e di Social Engineering (phishing, spear phishing, vishing, smishing, etc.) analisi OSINT e SOCMINT mediante strumenti di intelligence e Forensics investigations di compagnie, manager e 3°parti, al fine di supportare il management nei processi decisionali e di compliance.