Gli LLM: lama dalla punta spezzata?

L’evoluzione dei modelli linguistici di grandi dimensioni, noti come Large Language Models (LLM[1]), rappresenta uno dei progressi più significativi nell’ambito dell’intelligenza artificiale. Questi modelli hanno la capacità di comprendere e generare linguaggio umano con un livello di sofisticazione e coerenza mai visto prima, influenzando in modo profondo la nostra vita personale e professionale.

L’impatto degli LLM si estende a molteplici settori: dalla gestione del tempo all’ottimizzazione dei processi aziendali, fino al supporto creativo e alla generazione di contenuti.

Tuttavia, l’adozione su larga scala di queste tecnologie solleva anche una serie di domande e sfide relative alla loro sicurezza, affidabilità, trasparenza ed etica.

In questo contributo esploriamo le potenzialità, i limiti e le implicazioni degli LLM, con un focus particolare sul ruolo della regolamentazione, come l’AI Act dell’Unione Europea, per garantire un uso responsabile e sicuro di questi strumenti.

Quanto può aiutarmi nella vita personale e professionale un LLM?

I Large Language Models (LLM) rappresentano una tecnologia dirompente che può influenzare e migliorare la vita personale e professionale in modi che vanno ben oltre l’automazione di compiti ripetitivi.

A livello personale, un LLM può essere un assistente virtuale capace di fornire supporto in diverse aree, dall’apprendimento continuo alla gestione del tempo e all’organizzazione di attività quotidiane.

Per chi desidera apprendere una nuova lingua un LLM può fungere da tutor linguistico, fornendo esercizi, risposte personalizzate, traduzioni istantanee e spiegazioni contestuali che migliorano la comprensione in tempo reale; la gestione del tempo, un problema comune per molte persone, può essere resa più semplice grazie alla capacità degli LLM di pianificare, creare promemoria e persino suggerire strategie di produttività basate sui tuoi comportamenti e necessità specifiche.

Un LLM può inoltre aiutare ad esplorare nuove idee, ispirare progetti artistici o letterari e persino suggerire metodi innovativi per affrontare problemi personali o professionali.

Sul piano professionale, le capacità di un LLM possono essere sfruttate per ottimizzare numerosi processi lavorativi.

Gli LLM possono semplificare la stesura e revisione di documenti, automatizzare la generazione di report, facilitare l’analisi di grandi quantità di dati e proporre soluzioni a problemi complessi.

Ad esempio un ricercatore può avvalersi di un LLM per analizzare la letteratura scientifica in modo rapido ed efficiente, scoprendo correlazioni e nuovi spunti di ricerca altrimenti difficili da individuare. Un programmatore può delegare agli LLM la scrittura di codice, l’ottimizzazione delle prestazioni e la correzione di bug, accelerando così lo sviluppo del software. Anche nel settore legale un LLM può analizzare rapidamente la giurisprudenza, redigere documenti legali e fornire suggerimenti basati sui precedenti esistenti; tuttavia in questo campo il loro impiego va attentamente valutato, essendosi verificati diversi casi di “allucinazioni” in cui sono state citate pronunce giurisprudenziali inesistenti[2].

Gli esempi pratici dell’uso degli LLM sono praticamente infiniti. Possono assistere un docente nel definire un programma scolastico, generare esercitazioni interattive per gli studenti, suggerire strategie didattiche basate sull’analisi delle prestazioni e persino fungere da assistente virtuale durante le lezioni.

Anche in ambito artistico, pur senza sostituire l’inventiva umana, un LLM può aiutare un autore a sviluppare trame, generare dialoghi realistici e proporre sviluppi narrativi unici, contribuendo così al processo creativo.

La riduzione del tempo come valore aggiunto

Una delle qualità più apprezzate degli LLM è la loro capacità di ridurre drasticamente il tempo necessario per svolgere attività complesse o ripetitive. Questo vantaggio è particolarmente rilevante in un’epoca in cui la velocità e l’efficienza sono fattori chiave per il successo personale e professionale.

Grazie alla loro capacità di analizzare, sintetizzare e organizzare grandi quantità di dati, gli LLM consentono di evitare ore di ricerche manuali, confronti, catalogazione ed etichettatura. Possono fornire risposte pertinenti in pochi secondi, risparmiando tempo prezioso e migliorando l’efficienza generale.

In un mondo in cui il costo dello spazio per immagazzinare dati sta rapidamente diminuendo, mentre il valore del tempo cresce, la capacità degli LLM di accelerare processi e decisioni ha un impatto diretto sull’efficacia e sulla produttività. Il tempo risparmiato può essere reindirizzato verso attività più significative, come la pianificazione strategica, l’innovazione o il miglioramento continuo delle competenze.

Tuttavia, gli LLM non si limitano a svolgere semplici operazioni di ricerca e recupero delle informazioni; possono trasformare dati grezzi in conoscenza pratica, facilitando il riassunto e l’espansione di documenti complessi, progettando lezioni e percorsi formativi, generando programmi software e offrendo persino consulenza personalizzata su questioni complesse. La capacità di sintetizzare contenuti e adattarli a diversi contesti rende gli LLM strumenti estremamente versatili e potenti.

Apprendimento automatico e NLP in sinergia

Il cuore degli LLM è rappresentato dal machine learning (apprendimento automatico) e dall’elaborazione del linguaggio naturale (Natural Language Processing o NLP). Gli LLM vengono addestrati su enormi quantità di dati provenienti da diverse fonti, che spaziano da libri e articoli scientifici a documenti tecnici e conversazioni.

Durante il processo di addestramento, gli LLM utilizzano reti neurali profonde (deep learning[3]) per comprendere e generare testo in modo coerente e contestuale. Le reti neurali profonde sono costituite da numerosi strati (layers) che elaborano i dati in modo gerarchico e sempre più complesso, consentendo ai modelli di apprendere rappresentazioni sofisticate e relazioni tra le parole.

L’apprendimento automatico può essere supervisionato, non supervisionato o basato sul rinforzo.

Nell’apprendimento supervisionato, il modello viene addestrato utilizzando dati etichettati, dove ogni esempio ha un input e un output atteso; nell’apprendimento non supervisionato il modello analizza i dati senza etichette, cercando di scoprire autonomamente pattern e relazioni; l’apprendimento basato sul rinforzo, invece, prevede un sistema di ricompense e penalità che guida il modello verso il raggiungimento di obiettivi specifici.

Il deep learning ha trasformato il modo in cui i computer “pensano” e comprendono il linguaggio. Le reti neurali profonde consentono agli LLM di riconoscere modelli complessi nei dati, generare risposte contestualizzate e persino imitare il comportamento umano in determinati contesti. Questo approccio gerarchico e progressivo rende possibile l’analisi di testi complessi, la generazione di contenuti creativi e la comprensione di linguaggi naturali in modo fluido. Approfondimenti sul deep learning sono disponibili in numerose fonti[4].

Machine learning e complessità computazionale: i limiti degli LLM

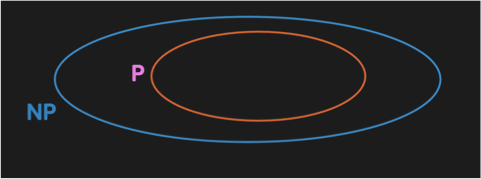

Nonostante i notevoli progressi, gli LLM non hanno modificato i fondamenti della complessità computazionale. La tesi di Church-Turing[5], che definisce ciò che è calcolabile da una macchina, rimane invariata. Gli LLM non hanno spostato il confine tra problemi trattabili (P) e intrattabili (NP).

In altre parole, i modelli non sono in grado di risolvere problemi computazionalmente complessi che non erano già trattabili prima della loro esistenza. Questo punto è fondamentale per comprendere le loro reali capacità e i loro limiti.[6].

Dopo l’AI winter,[7] gli LLM possono migliorare l’efficienza di molte operazioni già fattibili, accelerando processi e offrendo risposte rapide e precise. Tuttavia, non sono in grado di sovvertire la complessità intrinseca dei problemi o di rendere trattabili questioni che non lo erano. La loro forza risiede nella capacità di elaborare rapidamente grandi quantità di dati e di offrire soluzioni pratiche, ma non di superare limiti teorici consolidati.

Il momento in cui un LLM riuscirà a modificare la classe di complessità di un qualsivoglia problema – semmai ci riuscirà – sarà epocale. Sinceramente, sono scettico.

La questione dell’intelligenza: è giusto definire “intelligenti” gli LLM?

La definizione di intelligenza è complessa e spesso soggettiva. Gli LLM possono simulare l’intelligenza umana attraverso risposte coerenti e contestualizzate: ma è corretto definirli realmente intelligenti?

L’intelligenza umana è caratterizzata da creatività, innovazione, capacità di risolvere problemi complessi in modo originale e di generare nuove idee. Gli LLM, invece, si basano su dati esistenti e seguono schemi predeterminati. Possono generare contenuti che sembrano creativi, ma che sono sempre derivati dalle informazioni già disponibili nei dati di addestramento.

Questo non significa che gli LLM siano inutili o privi di valore. Al contrario, rappresentano strumenti estremamente potenti per l’automazione di processi, la generazione di contenuti e l’analisi di dati. Tuttavia, è importante non confondere le loro capacità con quelle di un essere umano.

Gli LLM non hanno coscienza, emozioni o etica. Sono strumenti che seguono logiche e modelli statistici, non entità autonome dotate di capacità decisionali.

- LLM negli attacchi

I cybercriminali possono sfruttare gli LLM per condurre attacchi sofisticati e difficili da rilevare. Le principali aree di applicazione malevola includono:

- Phishing e social engineering

Gli LLM eccellono nella comprensione e generazione di linguaggio naturale, il che li rende strumenti formidabili per orchestrare campagne di phishing altamente personalizzate e difficili da riconoscere. Gli attaccanti possono utilizzare gli LLM per creare e-mail, messaggi di testo e comunicazioni che imitano perfettamente lo stile e il tono di colleghi, superiori o aziende fidate, aumentando notevolmente la probabilità che le vittime si fidino e compiano azioni dannose. Questi attacchi sfruttano la capacità degli LLM di adattarsi al contesto e di utilizzare informazioni pubblicamente disponibili per personalizzare i messaggi, facendo riferimento a eventi o progetti specifici che coinvolgono la vittima.

Ad esempio, un attaccante potrebbe chiedere a un LLM di generare un’e-mail apparentemente inviata dal reparto IT dell’azienda della vittima, in cui si richiede un urgente aggiornamento della password aziendale. L’e-mail include riferimenti a politiche di sicurezza interne e un link a un sito di phishing che replica fedelmente la pagina di accesso dell’azienda, aumentando la possibilità di compromettere l’account della vittima.

- Generazione di codice e malware

Gli LLM possono essere utilizzati per scrivere codice exploit e generare varianti di malware in grado di eludere i sistemi di rilevamento tradizionali. Gli attaccanti possono modificare automaticamente il codice malevolo per renderlo più difficile da identificare attraverso strumenti di sicurezza, come antivirus e sistemi di rilevamento basati su firme. Questo rende gli LLM strumenti preziosi per gli attacchi che richiedono la creazione di varianti sempre nuove di codice dannoso.

Ad esempio, gli LLM possono essere utilizzati per generare malware polimorfico che cambia il proprio codice a ogni esecuzione, eludendo i controlli statici e complicando il lavoro di analisi e rilevamento da parte dei professionisti della sicurezza.

- Deepfake e impersonificazione

Combinando gli LLM con modelli di sintesi vocale e video, gli attaccanti possono creare contenuti deepfake estremamente realistici, utilizzabili per ingannare le vittime e condurle a compiere azioni pericolose. Questo approccio può essere sfruttato per impersonare individui di alto profilo, convincendo le vittime a trasferire fondi, condividere informazioni sensibili o concedere accessi privilegiati.

Un attacco che utilizza un deepfake audio potrebbe ad esempio convincere un dipendente a trasferire fondi aziendali, credendo di ricevere una richiesta urgente dal proprio direttore generale.

- Disinformazione

Gli LLM possono essere utilizzati per automatizzare la creazione di contenuti falsi su larga scala, come post sui social media, articoli e recensioni, con l’obiettivo di influenzare l’opinione pubblica, destabilizzare situazioni sociali o distruggere la reputazione di individui e organizzazioni.

Esempio: un gruppo di attaccanti potrebbe generare migliaia di recensioni negative su prodotti o servizi di una specifica azienda, danneggiandone la reputazione e influenzando negativamente la fiducia dei consumatori.

- Evasione dei sistemi di rilevamento

Gli LLM possono creare varianti di input che eludono i sistemi di rilevamento automatico, modificando leggermente il codice o i dati in modo che risultino “invisibili” agli strumenti di sicurezza. Questi attacchi adversarial[8] (antagonistici) sono progettati per indurre errori nei modelli di rilevamento basati su machine learning, bypassando le difese con input creati ad arte.

Esempio: un attaccante utilizza un LLM per generare una versione modificata di un codice dannoso che sfugge ai controlli dei sistemi di sicurezza tradizionali.

- LLM nella difesa

Gli LLM non sono solo strumenti di attacco; possono anche rappresentare una risorsa fondamentale per la difesa delle infrastrutture digitali e la protezione dei dati.

- Analisi e rilevamento delle cyber-minacce

Gli LLM possono analizzare grandi volumi di dati e log per identificare comportamenti sospetti, anomalie e potenziali attacchi. La loro capacità di apprendimento consente di rilevare schemi complessi che spesso sfuggono ai sistemi tradizionali.

Esempio: un LLM addestrato per analizzare i log di accesso rileva tentativi di accesso non autorizzati a sistemi critici, segnalando comportamenti che si discostano dalla norma.

- Automazione della risposta a Incidenti

Gli LLM possono essere configurati per rispondere automaticamente agli incidenti di sicurezza, riducendo il tempo di reazione e limitando il danno. Ciò è particolarmente utile per affrontare attacchi in tempo reale.

Esempio: quando un attacco ransomware viene rilevato, un LLM può isolare i sistemi infetti, bloccare i processi malevoli e notificare il personale IT.

- Formazione

Gli LLM possono essere utilizzati per simulare attacchi realistici, addestrando il personale a riconoscere e rispondere efficacemente alle minacce.

Esempio: un’azienda utilizza un LLM per generare scenari di phishing che testano la reattività dei dipendenti e migliorano la loro consapevolezza dei rischi.

- LLM nella prevenzione

Gli LLM possono svolgere un ruolo chiave nella prevenzione, anticipando le minacce e proteggendo le organizzazioni.

- Monitoraggio proattivo

Gli LLM possono analizzare fonti di intelligence per prevedere nuove minacce, offrendo un vantaggio strategico. Un LLM potrebbe monitorare forum e dark web per identificare conversazioni su potenziali attacchi, avvisando in anticipo le aziende a rischio.

- Controllo del codice

Gli sviluppatori possono utilizzare gli LLM per controllare il codice in tempo reale, identificando eventuali vulnerabilità durante la fase di sviluppo. Un LLM potrebbe suggerire correzioni per vulnerabilità di sicurezza mentre lo sviluppatore scrive codice per un’applicazione web.

In modo più generico, sebbene non possano prevedere con esattezza specifici attacchi zero-day[9], gli LLM possono analizzare una vasta gamma di dati per identificare potenziali vulnerabilità e suggerire contromisure. La loro capacità di sintetizzare informazioni provenienti da diverse fonti li rende strumenti preziosi per i team di sicurezza informatica che cercano di prevenire attacchi complessi e persistenti (APT o Advanced Persistent Threats[10]).

È chiaro che quanto discusso nel paragrafo 6.1 solleva importanti questioni etiche e di sicurezza, che devono essere affrontate per garantire un utilizzo responsabile di queste tecnologie.

La responsabilità nell’uso degli LLM e il ruolo dell’AI Act

Un elemento cruciale per l’adozione sicura e responsabile degli LLM in Europa è rappresentato dal cosiddetto AI Act,[11] regolamento dell’Unione Europea mirato a disciplinare l’intelligenza artificiale in tutti i suoi aspetti. L’AI Act mira a creare un quadro normativo che garantisca l’uso sicuro, trasparente e conforme dell’AI, riducendo i rischi e proteggendo i diritti dei cittadini europei.

Gli LLM, essendo strumenti di AI avanzati, rientrano pienamente nell’ambito di applicazione dell’AI Act, che classifica le applicazioni di AI in base al livello di rischio che possono comportare.

Le categorie di rischio sono suddivise in rischio minimo, limitato, alto e inaccettabile. Per gli LLM, il livello di rischio dipende dall’uso specifico e dal contesto di applicazione: ad esempio un LLM utilizzato per automatizzare semplici risposte nelle chat aziendali potrebbe essere considerato a rischio limitato, mentre un LLM utilizzato per valutazioni mediche o giuridiche potrebbe rientrare in una categoria a rischio elevato a causa delle implicazioni etiche e sociali.

Requisiti di conformità e trasparenza

Secondo l’AI Act, le applicazioni di AI ad alto rischio devono soddisfare specifici requisiti di trasparenza, sicurezza e robustezza.

Ciò significa che gli LLM destinati a usi critici devono essere sottoposti a valutazioni rigorose, audit e processi di certificazione per garantire che operino in modo equo e sicuro: per esempio, un LLM utilizzato per prendere decisioni automatizzate in ambito finanziario deve essere trasparente circa il modo in cui elabora i dati e le sue logiche decisionali. Questo implica che i fornitori di LLM devono garantire la tracciabilità dei dati di addestramento, la minimizzazione dei bias e la capacità di spiegare le decisioni prese dal modello.

L’AI Act pone anche l’accento sull’importanza della supervisione umana, che rimane un pilastro fondamentale per l’uso degli LLM. Ciò implica che, anche quando gli LLM vengono utilizzati per automatizzare decisioni complesse, il controllo umano deve essere garantito, specialmente in situazioni che possono avere un impatto significativo sui diritti e sulle libertà delle persone.

La supervisione umana riduce il rischio di decisioni discriminatorie o ingiuste derivanti dall’uso di modelli addestrati su dati potenzialmente distorti o incompleti.

Implicazioni etiche e sociali

L’AI Act non si limita agli aspetti tecnici, affrontando anche le implicazioni etiche dell’uso degli LLM.

Gli LLM possono, infatti, amplificare i bias presenti nei dati di addestramento, influenzare la percezione pubblica attraverso la generazione di contenuti e persino essere utilizzati per manipolare informazioni e disinformare il pubblico. L’AI Act prevede quindi misure per contrastare l’uso malevolo dell’IA e per garantire che gli LLM siano progettati e utilizzati in modo responsabile; ciò include la necessità di valutazioni d’impatto etico, che consentano di identificare e mitigare potenziali effetti negativi sulle persone e sulla società.

Inoltre il regolamento incoraggia la trasparenza nei sistemi di AI, compresi gli LLM, attraverso meccanismi come la spiegabilità degli output generati e la possibilità per gli utenti di essere informati quando interagiscono con un sistema di AI. Questo aspetto è particolarmente rilevante per gli LLM, che spesso operano in contesti dove la trasparenza è cruciale per evitare malintesi o l’attribuzione di un’intelligenza umana a ciò che, in realtà, è un algoritmo avanzato.

Sfide e opportunità legate alla regolamentazione degli LLM

L’AI Act rappresenta una sfida per i fornitori di LLM, che devono adattare i propri modelli per soddisfare i requisiti normativi imposti dall’Unione Europea.

Tuttavia, questa sfida può trasformarsi in un’opportunità per garantire maggiore fiducia e sicurezza nell’uso di questi strumenti: la conformità all’AI Act può spingere gli sviluppatori a migliorare la qualità dei dati utilizzati per l’addestramento, ridurre i bias, aumentare la trasparenza e fornire strumenti di audit che consentano un controllo più efficace delle applicazioni di AI.

Gli utenti finali, sia privati che professionali, possono trarre vantaggio da un contesto regolamentato che garantisce l’affidabilità e la sicurezza degli LLM. Ad esempio, un’azienda che utilizza un LLM conforme alle normative europee può essere più sicura dell’affidabilità delle decisioni automatizzate e ridurre il rischio di esposizione a problemi legali o etici.

La regolamentazione offre anche un quadro di protezione per i consumatori, che possono essere sicuri di non subire discriminazioni o trattamenti ingiusti derivanti da decisioni automatizzate.

Il futuro degli LLM nel contesto dell’AI Act

L’AI Act è destinato a plasmare il futuro degli LLM, promuovendo l’adozione di standard elevati di qualità e sicurezza. Questa regolamentazione potrebbe diventare un modello globale per l’uso etico e responsabile dell’AI, stabilendo una base di fiducia tra i cittadini e le tecnologie che interagiscono quotidianamente con loro. Sebbene possa sembrare una sfida per gli sviluppatori di LLM, l’adozione di pratiche etiche e responsabili può portare a una maggiore accettazione e diffusione di queste tecnologie in ambito commerciale e sociale.

Gli LLM rappresentano una straordinaria opportunità per migliorare la nostra vita personale e professionale, ma devono essere utilizzati nel rispetto di normative e principi etici.

L’AI Act fornisce una cornice solida per garantire che gli LLM siano progettati, sviluppati e utilizzati in modo responsabile, con un’attenzione particolare ai diritti fondamentali e alla sicurezza degli utenti. Questo quadro normativo, se applicato correttamente, contribuirà a creare un ambiente in cui l’innovazione tecnologica e la protezione dei diritti umani possano coesistere in armonia.

In conclusione, i Large Language Models (LLM) offrono straordinarie opportunità per migliorare la nostra vita personale e professionale, grazie alla loro capacità di automatizzare processi, generare contenuti e supportare decisioni complesse. È tuttavia essenziale utilizzare questi strumenti con consapevolezza e responsabilità, tenendo conto delle implicazioni etiche, sociali e normative che il loro impiego comporta.

L’AI Act, creando un quadro regolamentare per garantire trasparenza, sicurezza e supervisione, rappresenta un passo cruciale verso un’adozione etica e responsabile degli LLM. Solo attraverso un approccio equilibrato, che bilanci l’innovazione con la protezione dei diritti e la sicurezza, sarà possibile sfruttare appieno il potenziale di queste tecnologie, creando un impatto positivo e duraturo sulla società.

Non temiamo gli LLM: temiamo invece il loro cattivo impiego da parte umana, capendo quanto possiamo attenderci e – soprattutto – come poterlo prevenire.

Per una comprensione completa delle dinamiche di cyber intelligence e delle applicazioni avanzate degli LLM nel contesto della sicurezza informatica, vi invitiamo a consultare il Quaderni di Cyber Intelligence #7, dove potrete approfondire le metodologie di ricerca, i case study pratici e le prospettive future di questa tecnologia rivoluzionaria.

Articolo a cura di Fabrizio d’Amore – Socint

Note

[1] Un LLM è un’AI basata su reti neurali, addestrata su vasti dataset di testo per comprendere e generare linguaggio naturale, utilizzando miliardi di parametri per eseguire compiti come rispondere a domande, tradurre e scrivere testi.

[2]https://www.sistemapenale.it/it/articolo/amidani-chatgpt-bocciato-allesame-di-diritto-processuale

[3] https://en.wikipedia.org/wiki/Deep_learning

[4] Ad es., https://www.deeplearningbook.org/

[5] https://en.wikipedia.org/wiki/Church%E2%80%93Turing_thesis

[6] In termini colloquiali: possono velocizzare ciò che è già veloce.

[7] https://en.wikipedia.org/wiki/AI_winter

[8]Un attacco adversarial è un tipo di attacco in cui un LLM viene ingannato mediante l’introduzione di piccole e spesso impercettibili perturbazioni o modifiche ai dati di input.

L’obiettivo dell’attaccante è alterare il comportamento del modello, portandolo a fare previsioni errate o a prendere decisioni sbagliate. Ad esempio, nel caso di un sistema di riconoscimento delle immagini, un attacco adversarial potrebbe consistere nel modificare leggermente un’immagine in modo che il sistema non la riconosca correttamente, pur rimanendo quasi identica per l’occhio umano.

Questo tipo di attacco è particolarmente rilevante nei contesti di sicurezza informatica e può essere un problema critico per applicazioni che richiedono alta affidabilità, come l’identificazione facciale, la guida autonoma o la diagnosi medica assistita dall’AI.

[9] https://en.wikipedia.org/wiki/Zero-day_vulnerability

[10] https://en.wikipedia.org/wiki/Advanced_persistent_threat

[11] https://www.artificial-intelligence-act.com/

Romano, docente di Cybersecurity alla Sapienza Università di Roma. Ha trascorso periodi di studio e ricerca all’estero (Zurigo, Buenos Aires, Berkeley, UMIACS a College Park Maryland). Insegna inoltre corsi di crittografia, sicurezza delle informazioni, sicurezza applicativa e steganografia presso alcuni master ed altre iniziative di alta formazione. Direttore del master di 2° livello in Sicurezza delle informazioni e informazione strategica, in collaborazione con il DIS. Svolge attività di verificatore e di consulente tecnico di parte. Referente scientifico di contratti di ricerca applicata, studio e analisi fra università ed enti istituzionali e privati. Dal 2015 la sua attività di ricerca si concentra sul campo della steganografia/watermarking, sicurezza del software (antiplagio), cybersecurity del volo aero civile e delle infrastrutture, modelli di autenticazione, protezione dei dati & privacy e OSINT.